开篇词|从熟练到精通:开启你的Go语言进阶之旅

你好,我是 Tony Bai,一名在 Go 领域深耕多年的布道师。

也许你已经完成了我的 《Go语言第一课》,或者通过其他途径掌握了 Go 的基础语法和常用库。但你可能正面临这样的困惑:

-

感觉到了瓶颈? 写了不少 Go 代码,但总觉得离“精通”还差一口气,想写出更优雅、更高性能的代码却不知从何下手?

-

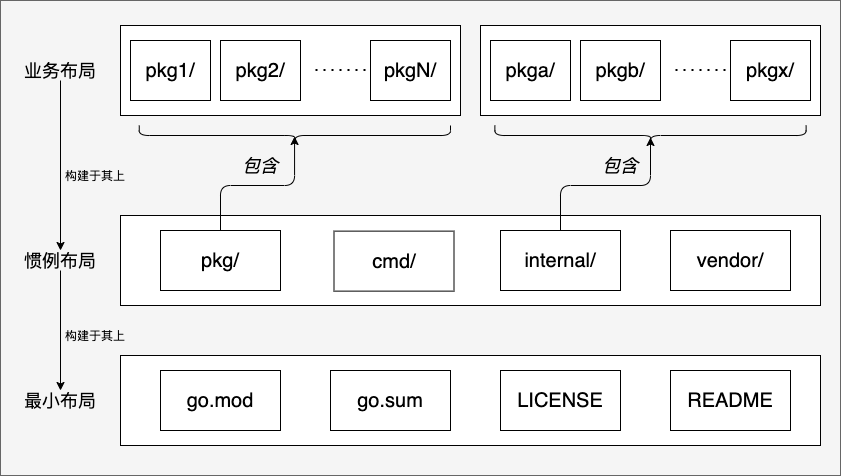

设计能力跟不上? 面对复杂的业务需求,如何进行合理的项目布局、包设计、接口设计?如何选择合适的并发模型?

-

工程实践经验不足? 知道要测试、要监控、要优化,但具体到 Go 项目,如何搭建可观测性体系?如何进行有效的故障排查和性能调优?如何保证代码质量和线上稳定?

-

……

如果你有这些疑问,那么这门“Go 语言进阶课”正是为你量身打造的。

现在是进阶 Go 的最佳时机吗?

如果你还在观望:Go语言还值得深入吗?前景如何?我的答案是:现在正是学习和进阶 Go 的最佳时机!

Go 正迎来它的黄金十年

如果你关注近些年的主流语言应用趋势,不难发现,从国外的Google、特斯拉,到国内的腾讯(连续两年内部最热门语言)、字节跳动(超55%服务用Go实现,并开源了Kitex、Hertz等框架),再到越来越多的中小和初创公司,都在生产环境大规模使用Go。为什么? Go 语言是生产力与执行效率的最佳结合,尤其在云原生、微服务、中间件领域优势明显,能实实在在的降本增效。

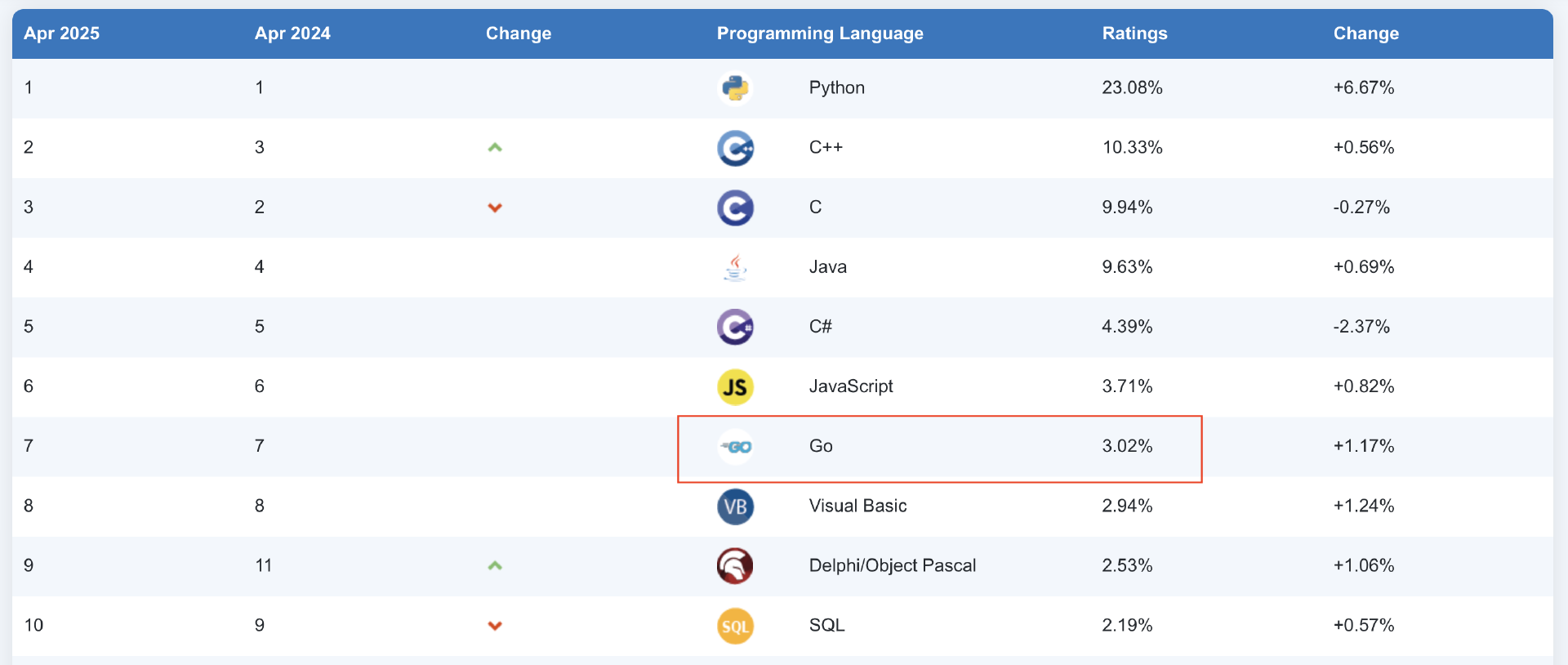

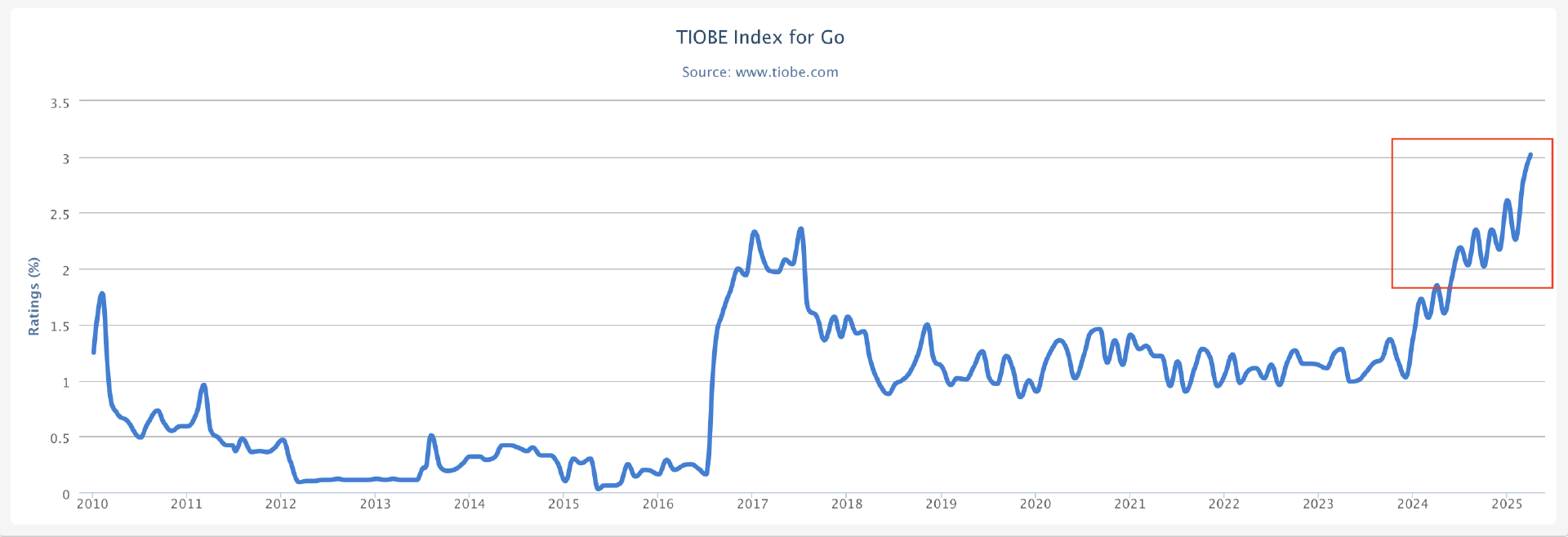

各大行业榜单也是稳中有进。无论是关注工程师需求的IEEE Spectrum,追踪社区热度的RedMonk,衡量开源项目量的GitHub Octoverse,还是搜索热度的TIOBE,Go语言都呈现出稳步上升甚至屡创新高的态势。特别是在TIOBE榜单上,Go 已稳定在第 7 名,并且 在 2025 年 4 月榜中,其份额首次超过 3%,达到 3.02%。

从全球开发者社区来看的话,热度不减。新冠疫情后,全球GopherCon大会和Meetup纷纷回归线下,国内GopherChina甚至一年两办,连非洲也迎来了首届GopherCon。 这背后是 Go 开发者生态的持续繁荣。

开发者基数扩大、优秀项目涌现是排名上升的基础。2025年伊始,我们看到 TypeScript 编译器项目向 Go 移植,各大主流大模型厂商纷纷推出官方Go SDK项目,Ollama成为本地运行大模型工具的事实标准,我们还看到 Grafana 基于 Go 构建 MCP Server( mcp-grafana),GitHub 更是 用 Go 重写了其 MCP Server(替换原有 JS 版本)……这些都展示了Go社区的活力以及Go在AI生态中的快速渗透和发展,也预示着 Go 在构建下一代 AI 应用(特别是与大模型交互相关的组件)方面将扮演越来越重要的角色。

结合技术成熟度曲线来看,Go语言已经走出了“泡沫破裂谷底期”,稳步迈入“光明期”。正如我在 《Go 语言第一课》 结束语中预测的,Go 正迎来它的黄金十年。

Go 持续进化,能力更强大

另外,Go语言并非一成不变,它在保持简洁和兼容性的同时,也在积极地吸纳社区反馈,不断进行自我完善和能力增强。近些年,Go语言迎来了许多重要的里程碑,为开发者提供了更现代、更高效的工具集。

-

泛型落地(Go 1.18): 这无疑是近年来最重大的语言特性更新,解决了无数 Gopher 的“心头痛”,极大地提升了代码的复用性和表达力,让编写类型安全的通用数据结构和函数成为可能。

-

兼容性承诺与演进策略(Go 1.x & math/rand/v2): Russ Cox 明确“不会有 Go 2”,并强调兼容性是 Go 最重要的特性,给开发者吃下了定心丸。同时,通过 math/rand/v2 包的发布,Go 团队也展示了如何在保持兼容性的前提下,对标准库进行版本化演进,为未来的改进铺平了道路。

-

性能优化持续发力(PGO & Runtime): Profile-Guided Optimization (PGO) 从 Go 1.20 的技术预览,到 Go 1.21 正式可用,并在 Go 1.22 中进一步增强了去虚拟化(devirtualization)的能力,Go 1.23 则显著降低了 PGO 的编译开销。这些改进能为典型 Go 应用带来 3-7% 甚至更高的性能提升。运行时的垃圾收集元数据优化也在持续进行,以降低 CPU 和内存开销。

-

语言层面精益求精(Loopvar Fix & Function Iterators): Go 团队勇于修正历史包袱。例如,长期困扰开发者的 for 循环变量共享问题在 Go 1.22 中得到了历史性的修正,每次迭代都会获得独立的变量实例。Go 1.23 则引入了对自定义函数迭代器的支持(range over func),让 for range 语句可以优雅地遍历用户自定义的集合类型,提升了语言的灵活性。

-

工程化与标准库能力显著增强:

-

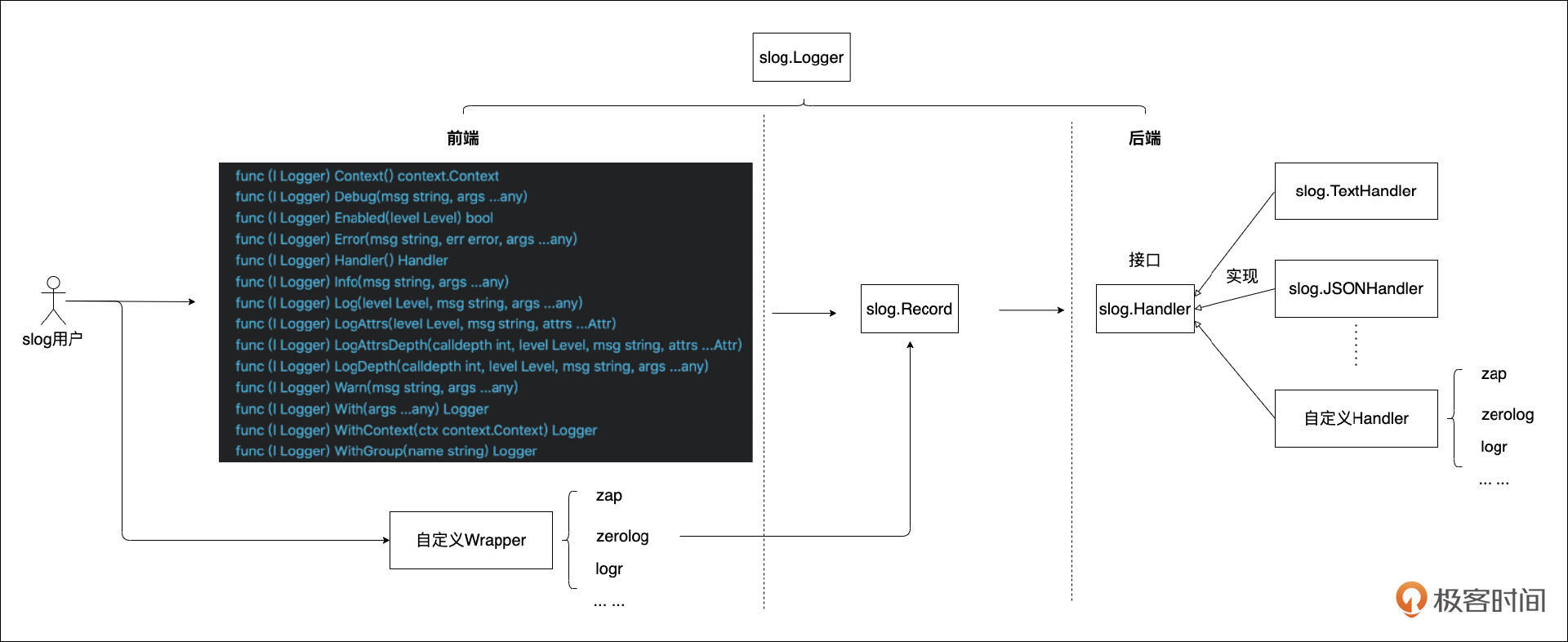

标准库: 新增了如 log/slog 结构化日志包,采用泛型实现的 slices、maps、cmp 包,用于处理唯一值的 unique 包,以及支持函数迭代器的 iter 包等。net/http.ServeMux 的路由能力在 Go 1.22 中也得到了大幅增强,支持方法谓词、路径变量和通配符。

-

工具链: 推出了官方安全漏洞扫描工具 govulncheck,加强了软件供应链安全。Go 1.23 正式引入了官方遥测系统(Telemetry),用于收集匿名的使用数据以指导 Go 的未来发展。go work 对 vendor 的支持、go mod tidy -diff 等改进也提升了日常开发效率。godebug 指示符的引入使得在 go.mod 中管理实验性特性或行为调整更为便捷。

-

这些变化并非孤立的补丁,它们共同构成了 Go 语言持续进步的图景: 更强的表达力、更高的性能、更完善的工具链、更丰富的标准库以及对开发者痛点的积极响应。

正是因为 Go 语言这种务实、持续进化的态度,我们有理由相信,现在学习和掌握 Go 的进阶知识,将为你未来的技术生涯注入强大的动力。

大势所趋,Go 高级技能需求迫切

我们正处在一个 云原生、微服务、分布式系统 成为技术基础设施核心的时代。而Go语言,凭借其出色的并发性能、简洁的语法、高效的编译部署以及对网络编程的良好支持,已经成为构建这些现代系统的 首选语言之一。

这意味着什么?

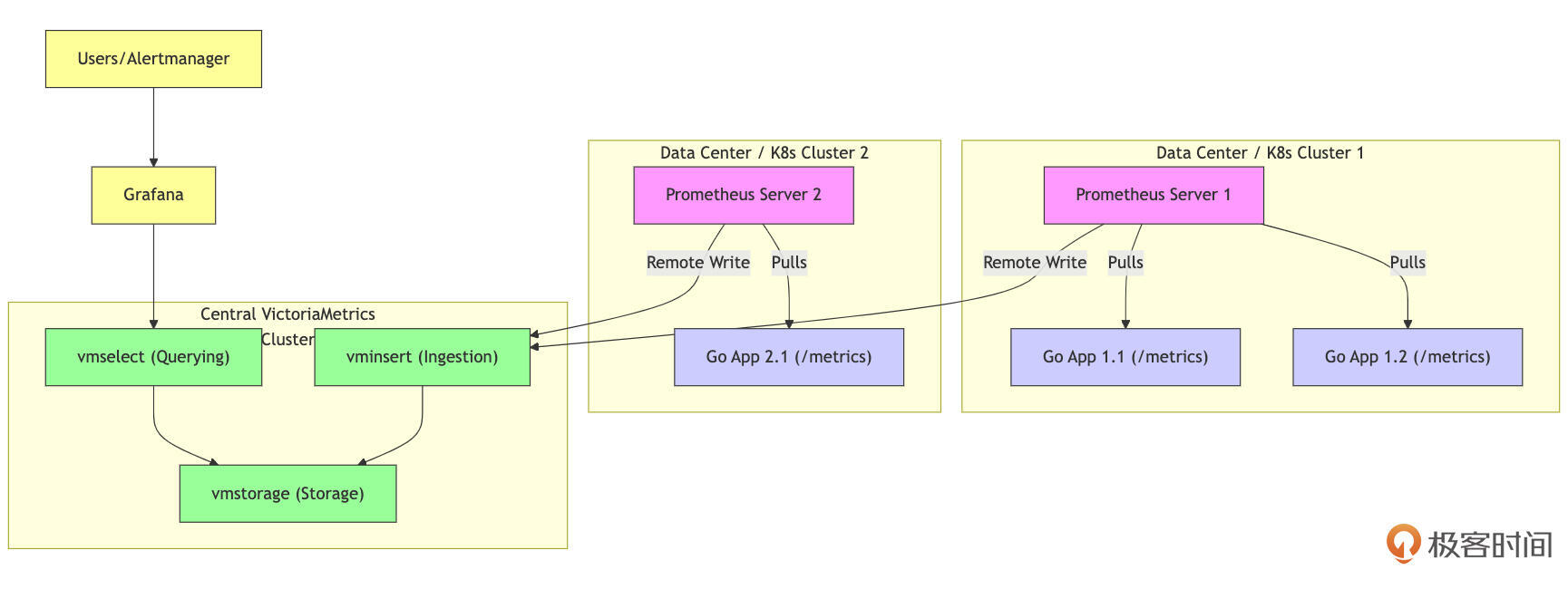

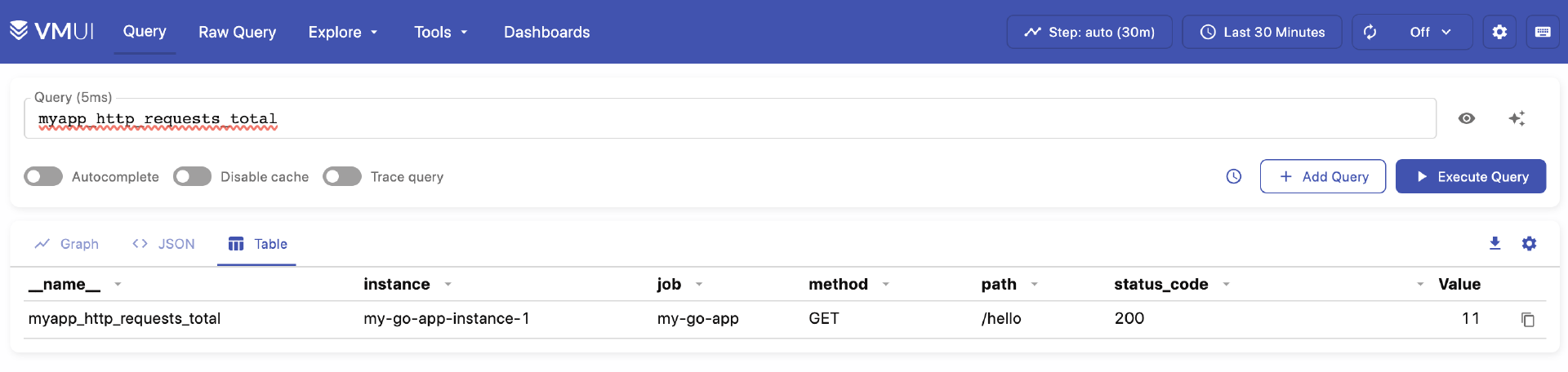

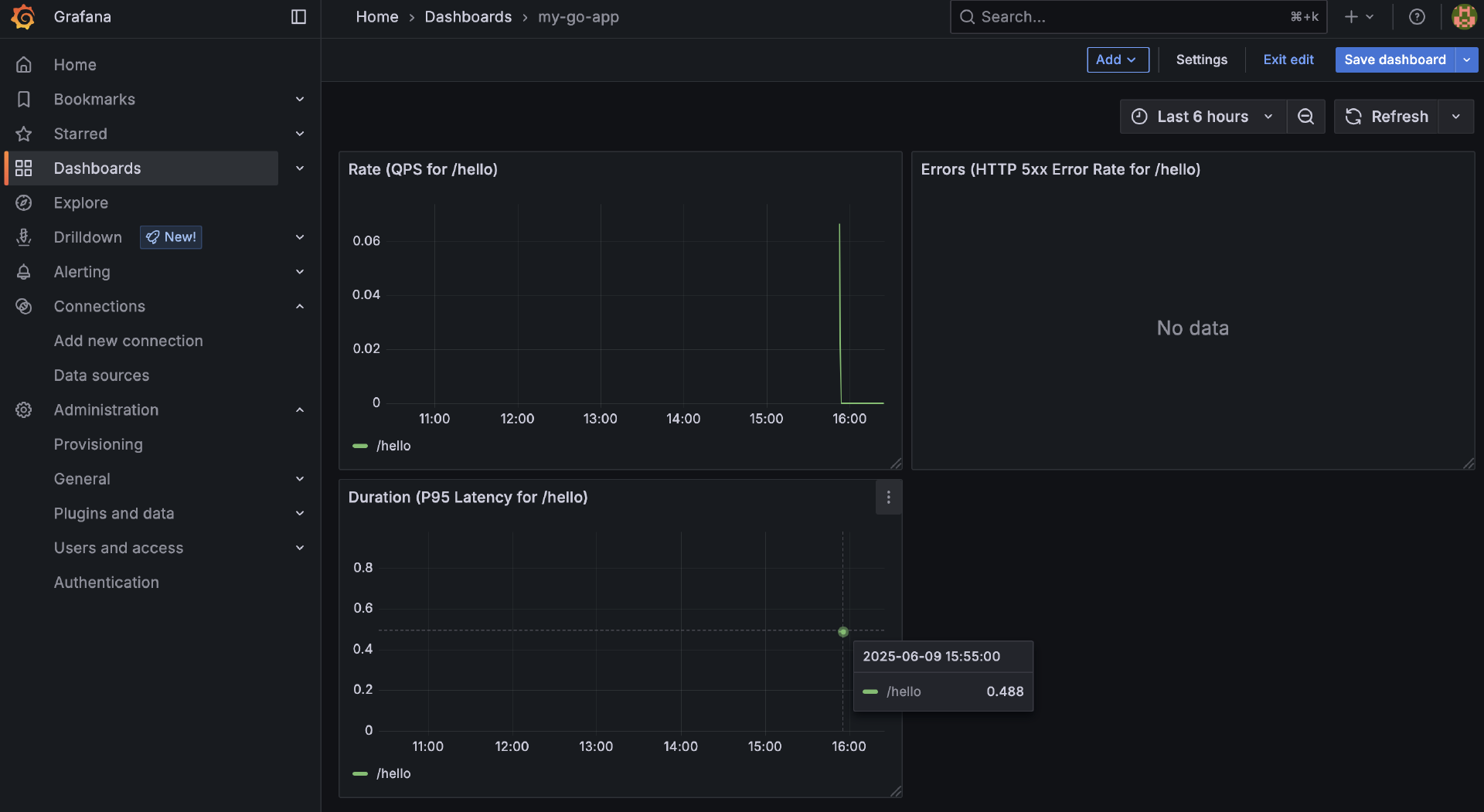

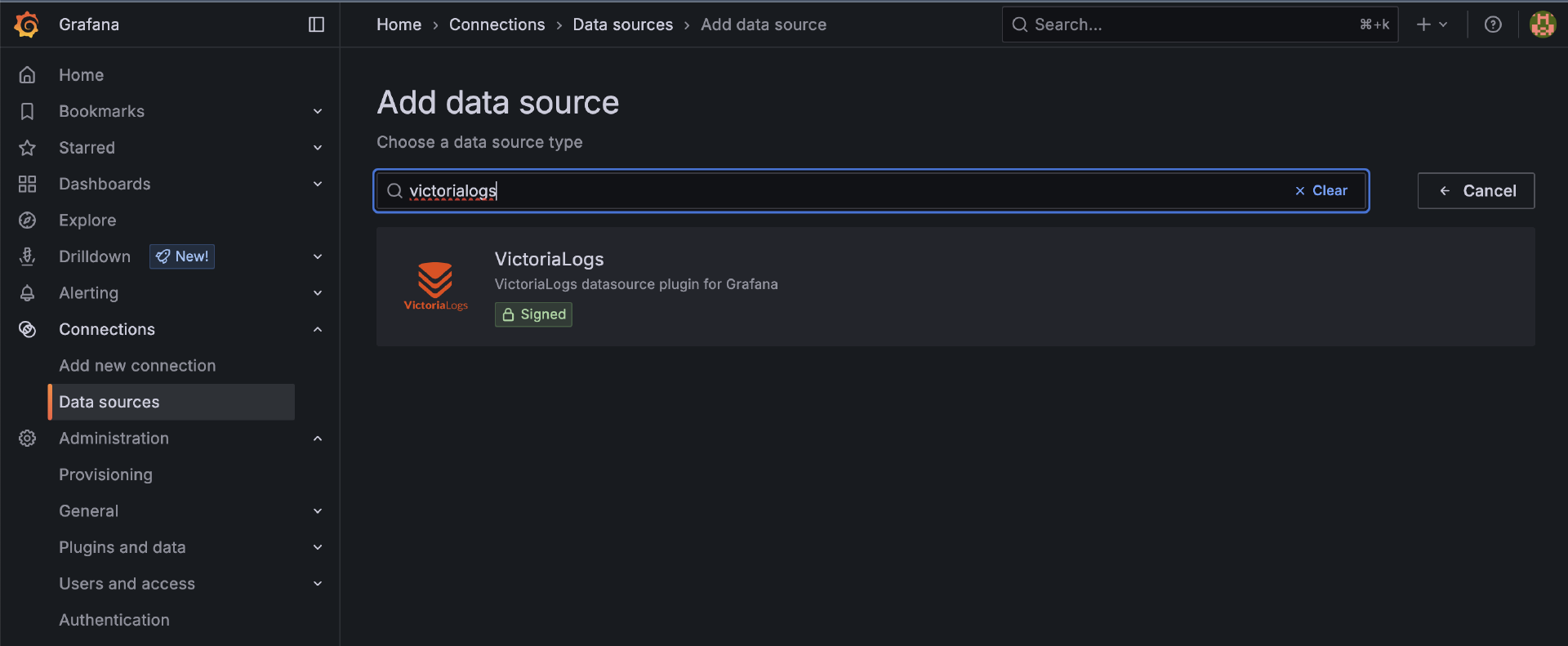

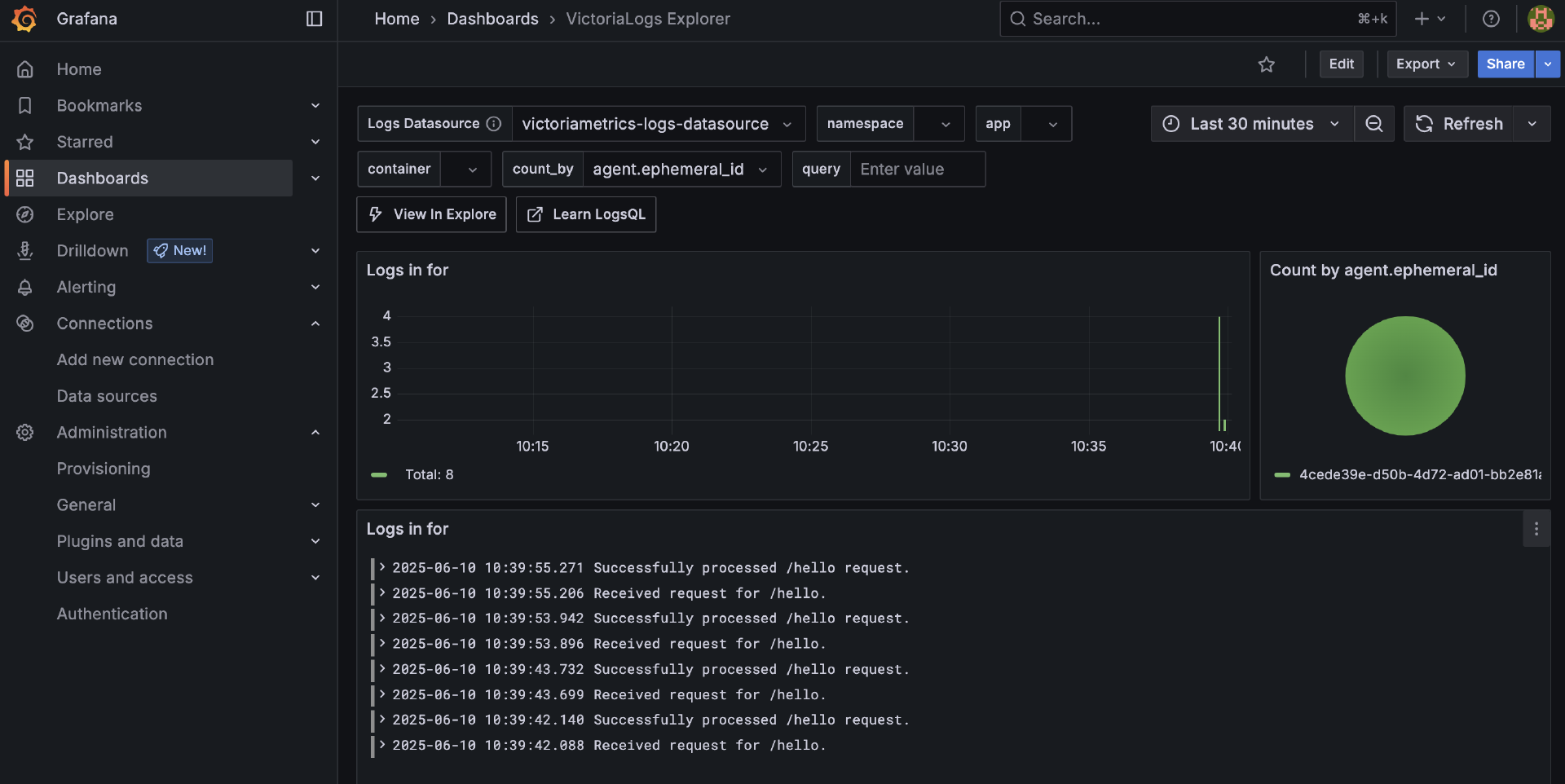

应用场景深化: Go不再仅仅用于编写简单的API服务或工具。它被广泛应用于构建复杂的中间件(如服务网格、消息队列)、高性能网关、容器编排(Kubernetes生态)、可观测性系统(如Prometheus、VictoriaMetrics、VictoriaLogs等)、分布式数据库(如CockroachDB等)等核心基础设施。大型语言模型(LLM)应用的兴起带来了新的架构挑战。构建复杂的AI Agent、RAG(Retrieval-Augmented Generation)系统或多模型编排应用,往往需要一个强大的后端来处理业务逻辑、协调对不同模型/API/工具的调用、管理状态和并发。Go的并发模型和性能优势,使其成为构建这类复杂、高并发AI应用后端的有力竞争者。

对工程师能力要求提升: 要在这些关键领域构建稳定、高效、可扩展的系统,仅仅掌握Go的基础语法是远远不够的。企业迫切需要那些深刻理解 Go 并发模型、内存管理、性能调优、具备良好系统设计能力和工程实践经验的高级工程师。

职业价值凸显: 掌握Go的进阶知识和实践技能,意味着你能够胜任更具挑战性、更有价值的工作岗位,解决更复杂的工程问题。这直接关系到你的职业竞争力和发展空间。

总结来说,行业的技术发展方向与Go语言的优势高度契合,这催生了对真正掌握 Go 进阶技能人才的巨大需求。仅仅“会用” Go 已经不足以应对挑战,市场需要的是能够“精通”并能解决复杂问题的Go专家。

这门课能带给你什么?

作为一名在Go领域深耕多年的布道师和一线技术负责人(你可以在 tonybai.com 找到我的博客),目前,我带领团队使用Go语言构建的车云平台产品,已经成功服务于国内外多家知名车企的量产车型。

在将产品从0到1、再到服务生产环境的过程中,我们踩过坑,也积累了丰富的Go语言实战经验,尤其是在 系统设计、工程化实践和性能优化 方面。我深知Go开发者从“入门”到“熟练”,再到“精通”需要跨越哪些障碍。

过去几年,我将这些经验和思考在团队内部分享,并带到了GopherChina大会的“Go 高级工程师必修课”培训中,收到了非常积极的反馈。因此,我决定再推出一门进阶课,希望能系统性地帮助更多Gopher突破瓶颈。

提升能力的三个核心维度

那么这门课是如何设计的呢?

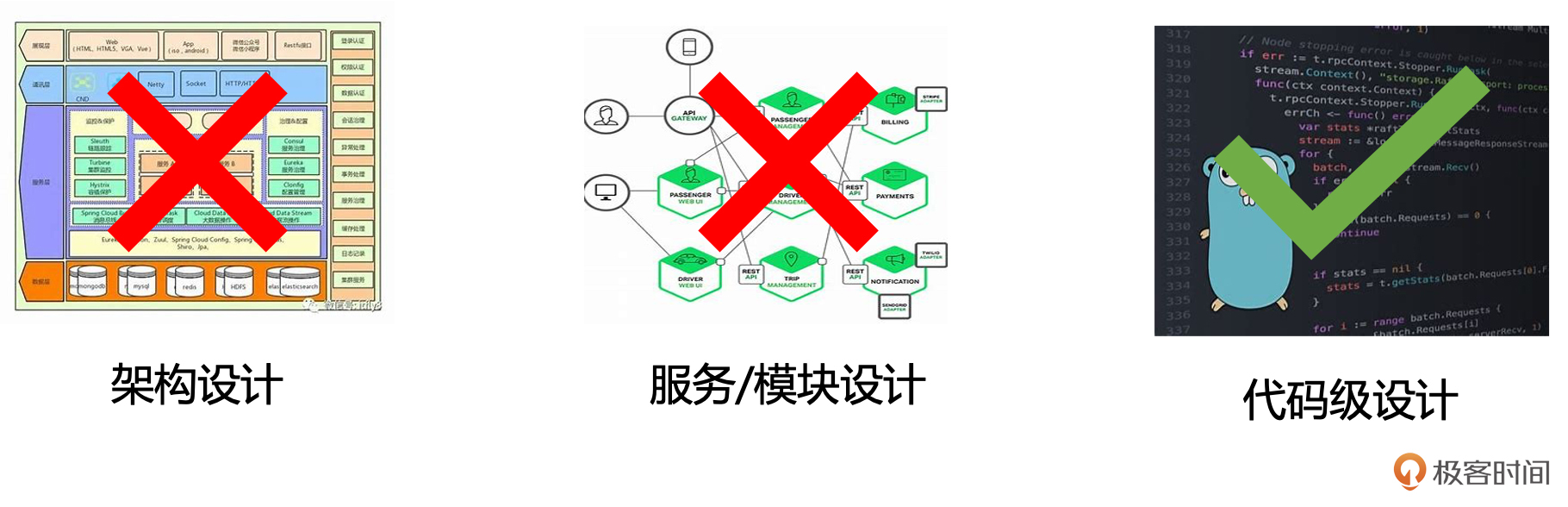

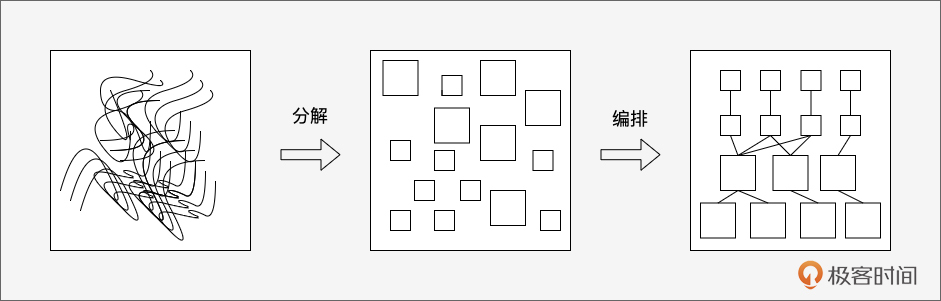

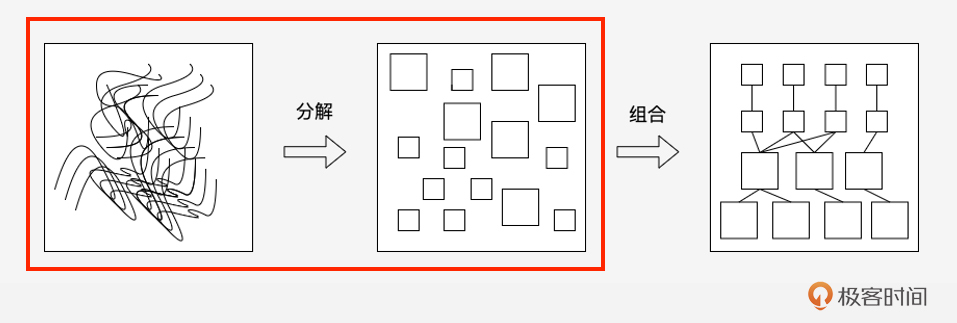

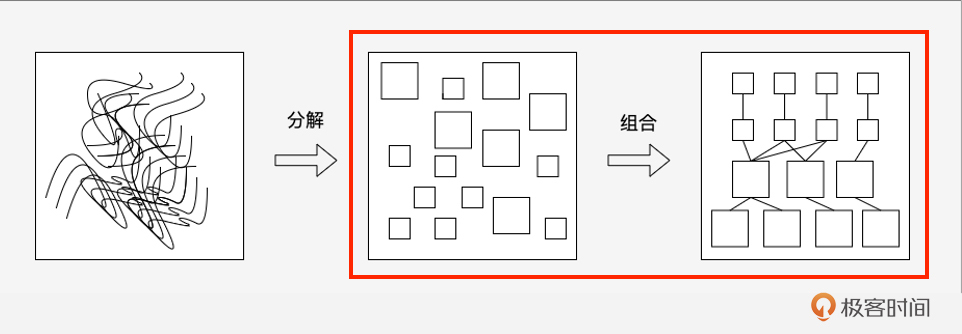

进阶课摒弃了简单罗列知识点的方式,聚焦于 Go 工程师能力提升的三个核心维度,为你精心设计了三大模块。

模块一:夯实基础,突破语法认知瓶颈

这里我们不满足于“知道”,而是追求“理解”。深入类型系统、值与指针、切片与map陷阱、接口与组合、context、泛型等核心概念的底层逻辑与设计哲学,让你写出更地道、更健壮的Go代码,彻底告别“语法坑”。

模块二:设计先行,奠定高质量代码基础

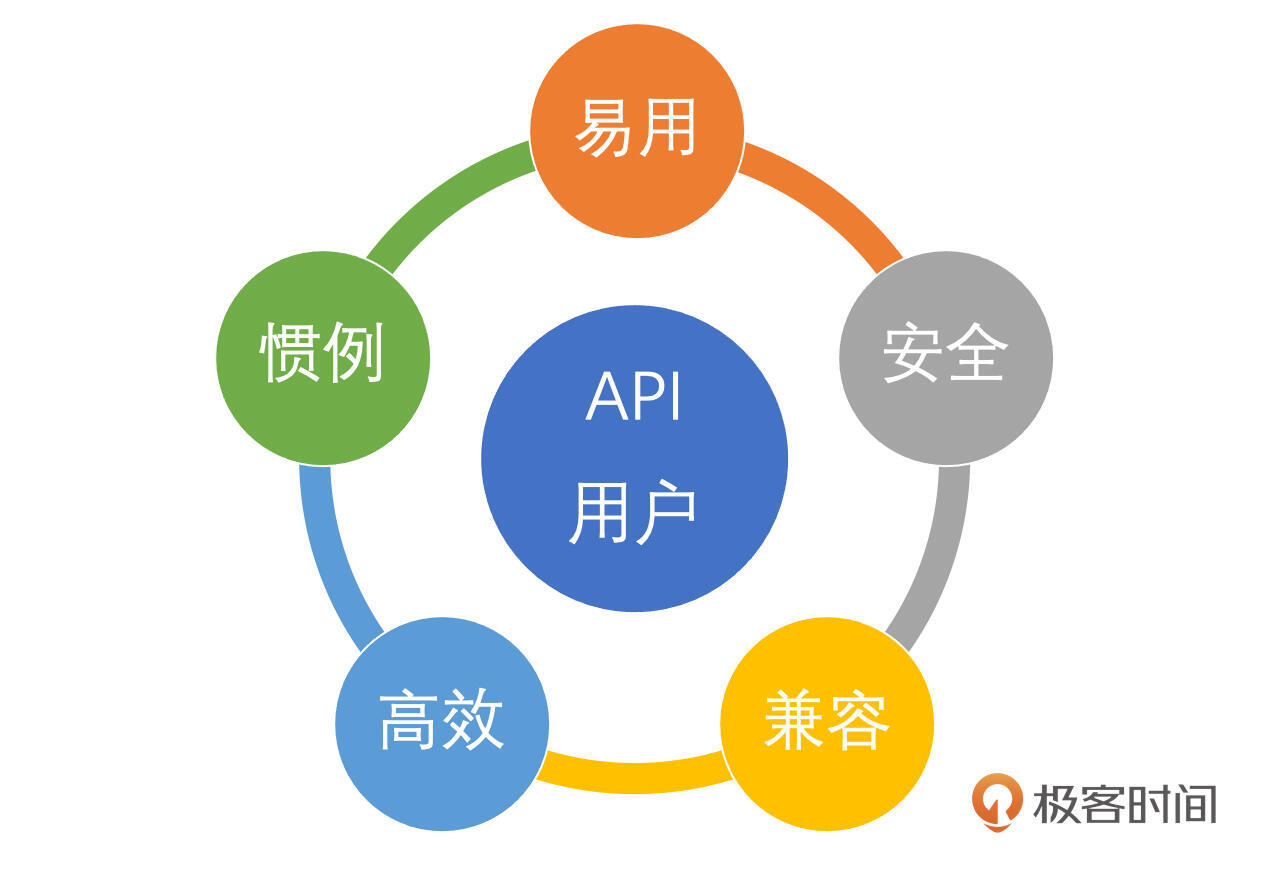

从宏观的项目布局、包设计,到具体的并发模型选择、接口设计原则,再到实用的错误处理策略和API设计规范。这一模块将提升你的软件设计能力,让你能驾驭更复杂的项目。

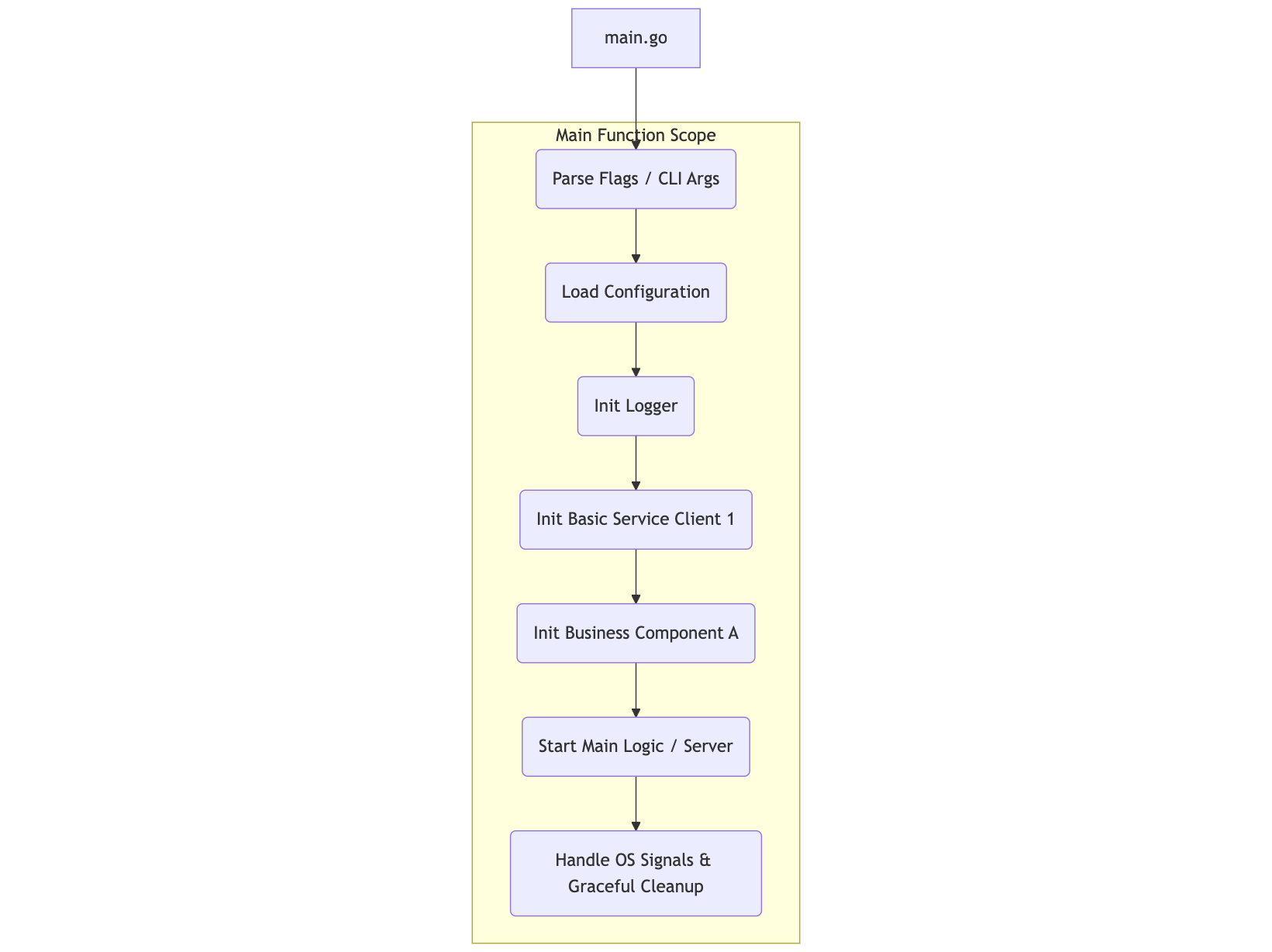

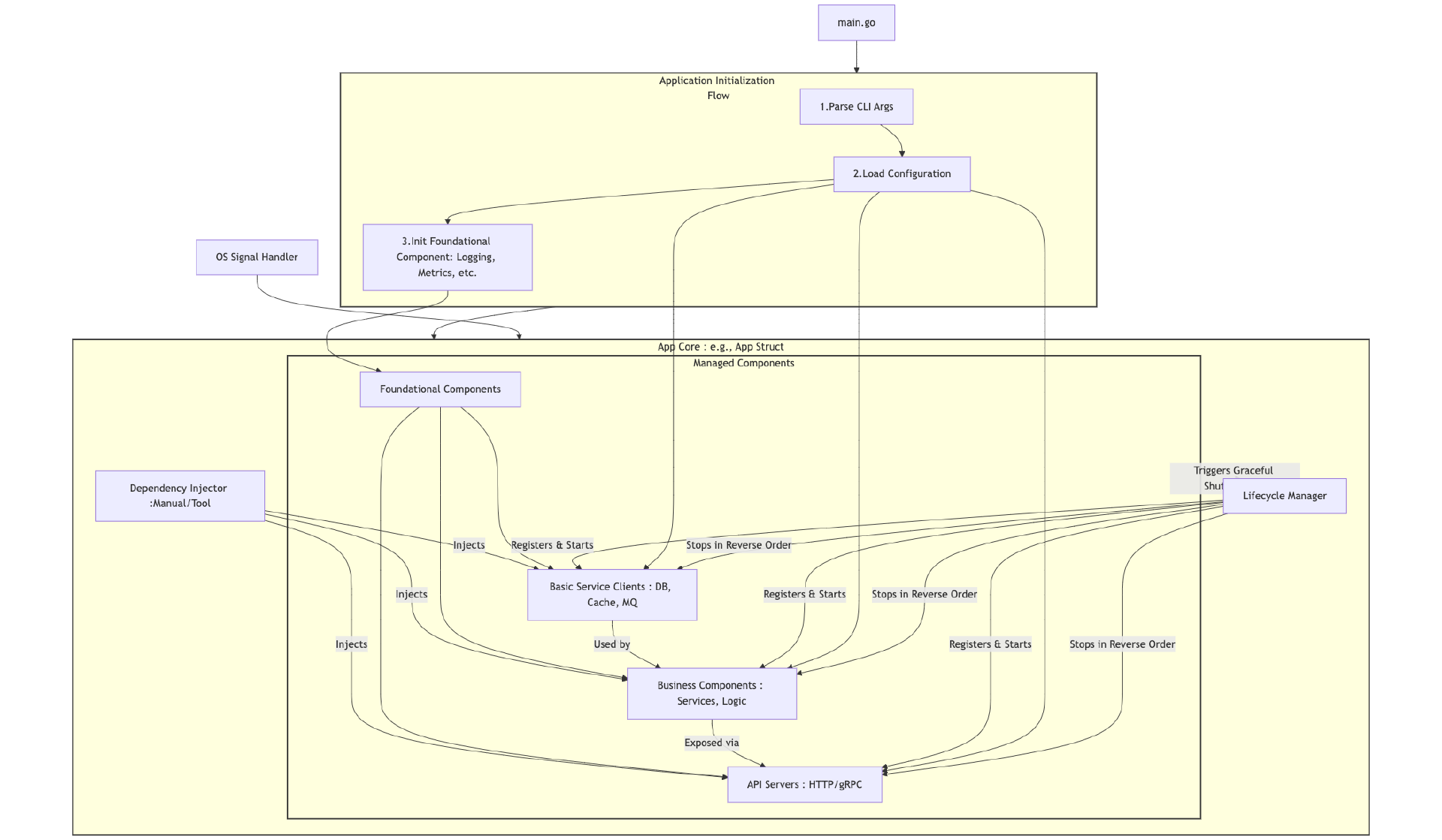

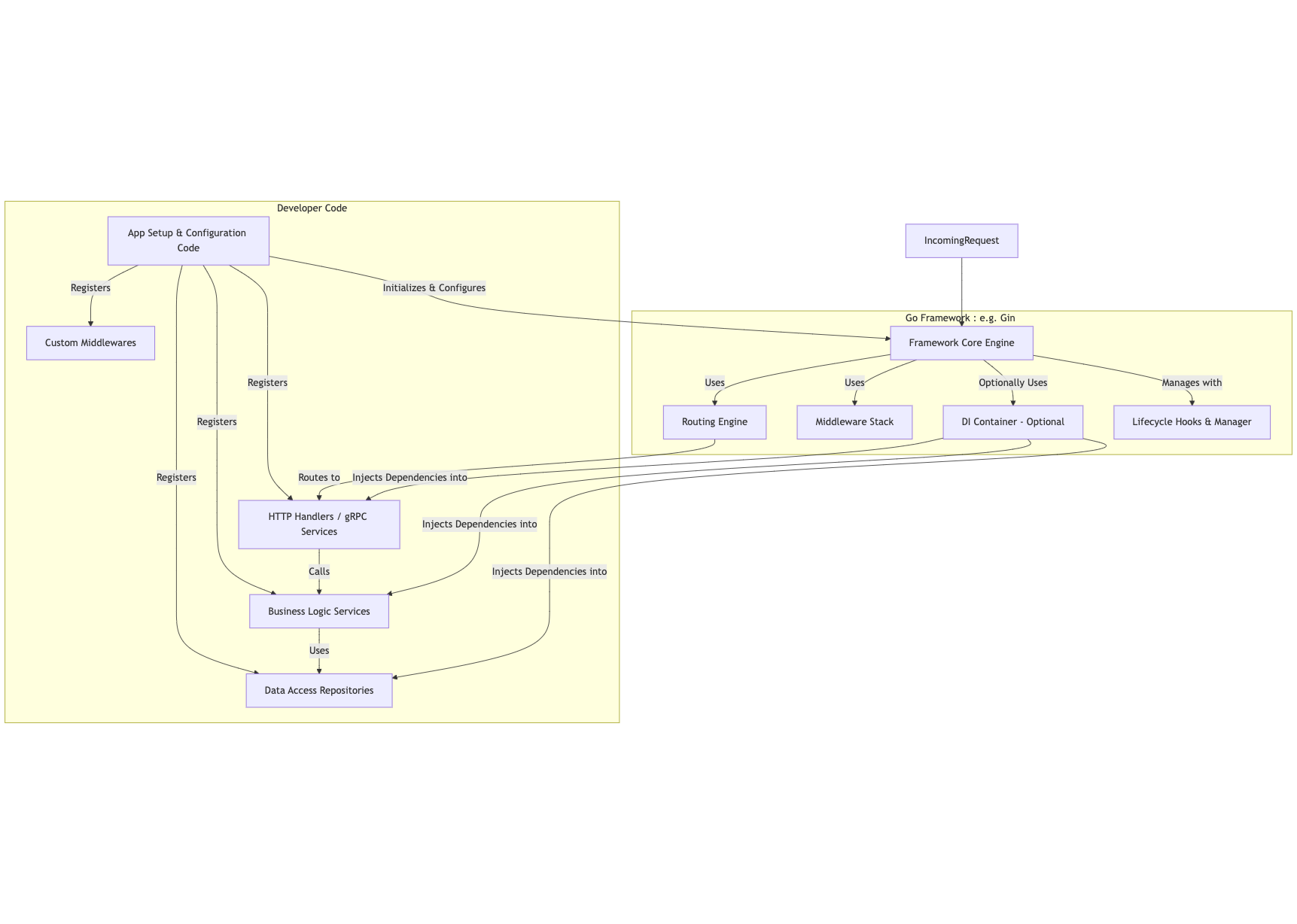

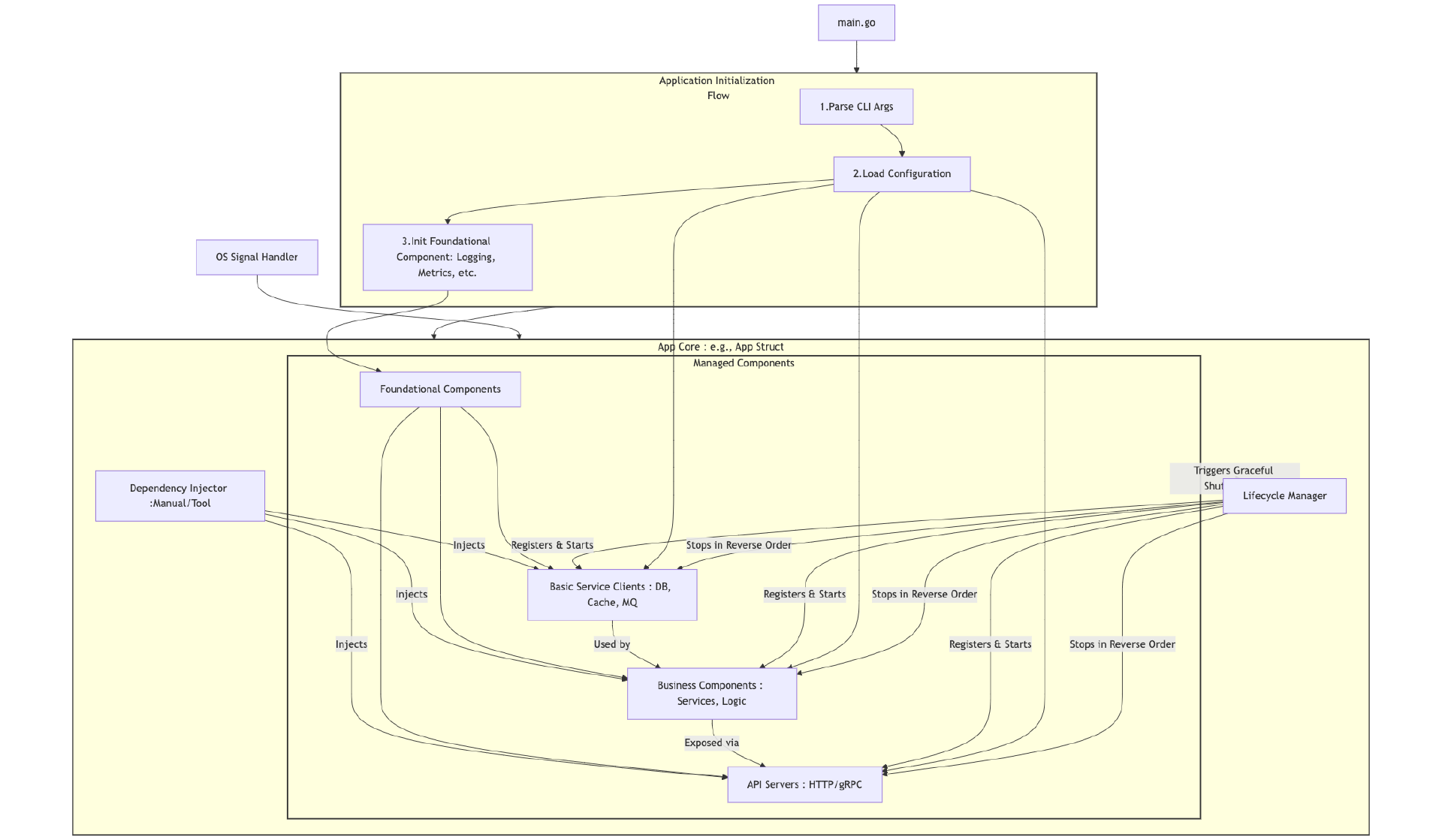

模块三:工程实践,锻造生产级Go服务

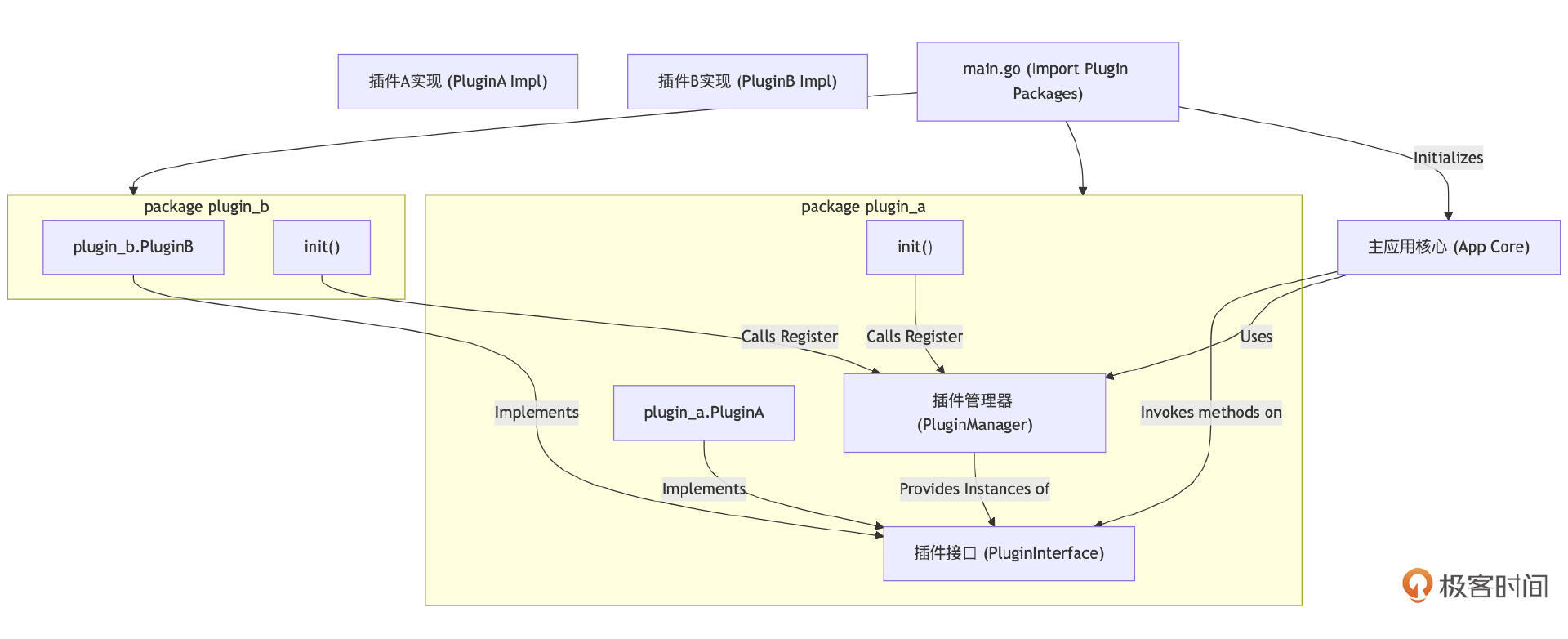

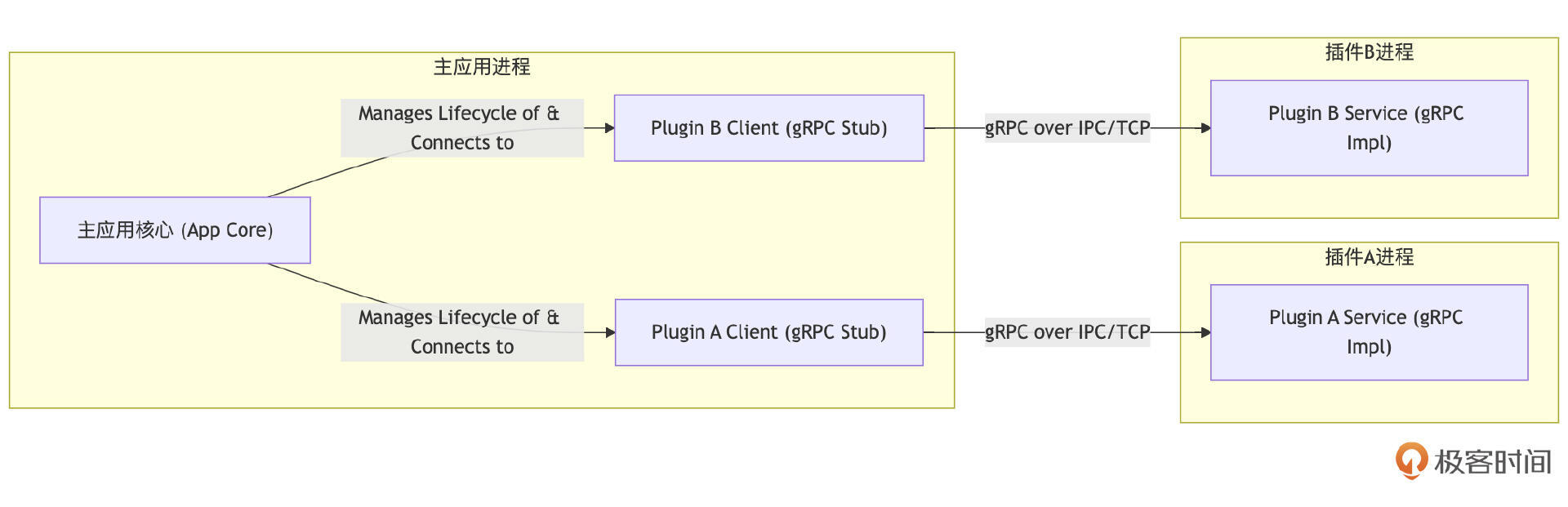

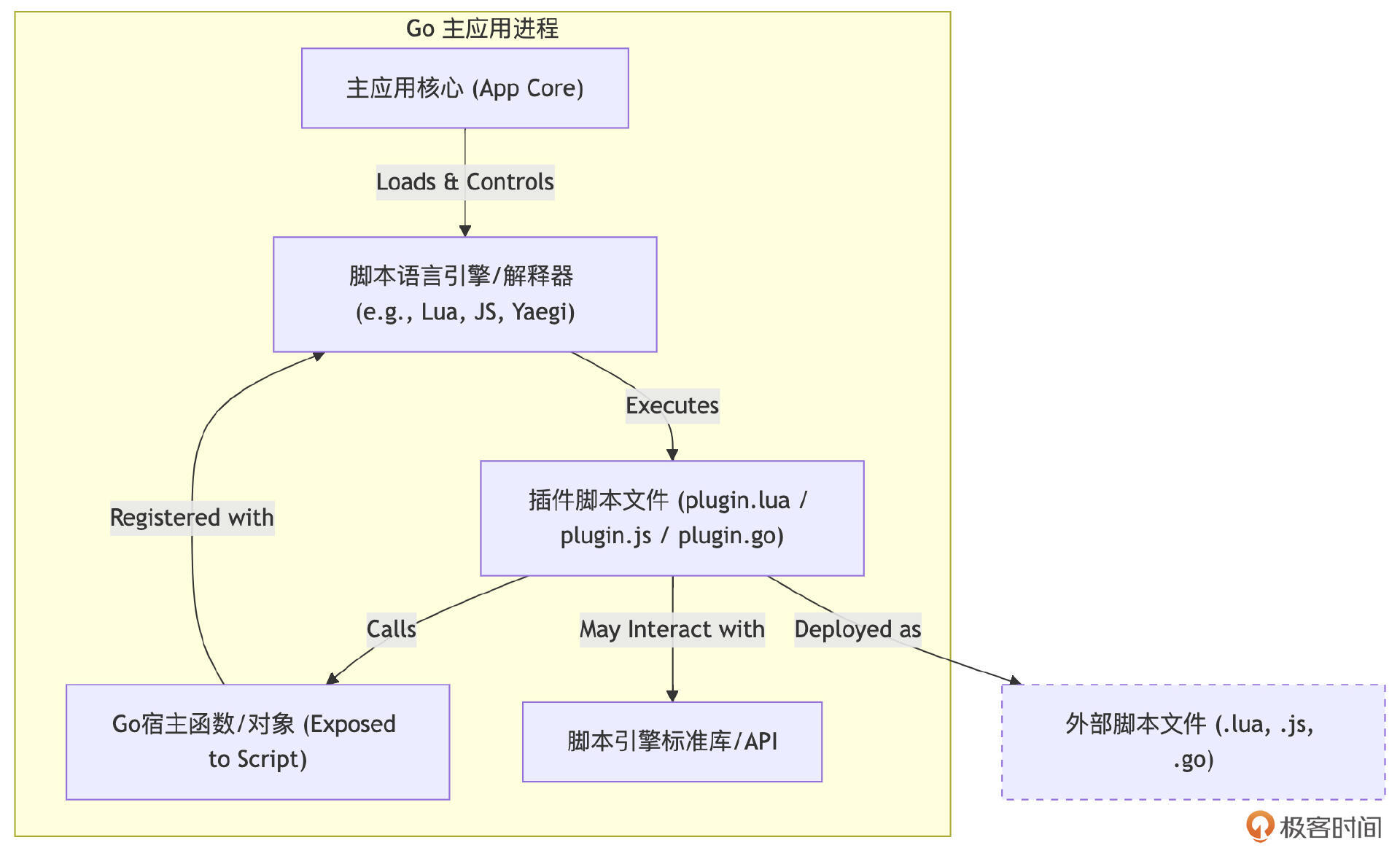

聚焦于将Go代码变成可靠线上服务的关键环节。如何构建应用骨架(初始化、依赖注入、优雅退出)?如何实现核心组件(配置、日志、插件化)?如何落地可观测性(Metrics、Logging、Tracing)?如何进行高效的故障排查、测试组织、性能调优、云原生部署以及与AI大模型集成?这里全是硬核干货。

此外,我们还安排了 实战串讲项目,带你将前面学到的知识融会贯通,亲手构建并完善一个真实的Go服务。

通过这门课程的学习,你不仅可以掌握Go的高级特性和用法,更能 建立起 Go 语言的设计思维和工程思维,真正具备驾驭大型Go项目、解决复杂工程问题的能力,完成从“Go 熟练工”到“Go 专家”的蜕变。

你准备好了吗?让我们一起,开启这段激动人心的Go语言进阶之旅!

类型系统:理解Go语言独特设计哲学的关键钥匙

你好,我是Tony Bai。

欢迎来到“Tony Bai·Go语言进阶课”的第一讲!

这门课不同于入门课程,我会假设你已经具备一定的 Go 语言基础。如果你是 Go 新手,我推荐你先学习我的《 Go语言第一课》专栏,那里是扎实基础的好起点。

今天,作为“语法强化篇”这个模块的开篇,我们要深入探讨 Go 语言的一个核心基石: 类型系统。

提到类型系统,你是不是也和我一样,有种“最熟悉的陌生人”的感觉?

熟悉,是因为我们每天都在和各种类型打交道,比如 int、string、struct、interface{}… 它们是我们构建程序的砖瓦。陌生,则是因为一旦加上 系统 二字,它就变得抽象起来。

很多人可能并不清楚,类型系统到底是什么,它在 Go 这门静态强类型语言中扮演着怎样至关重要的角色。

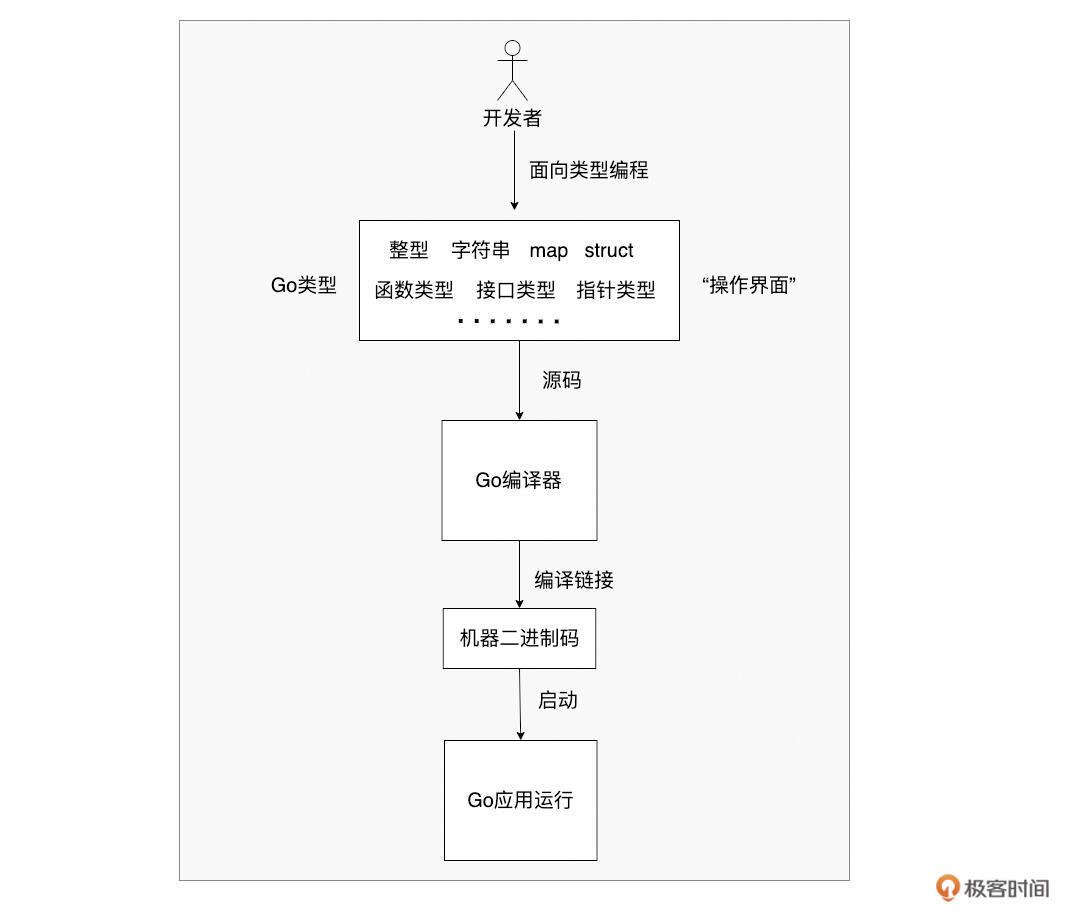

在Go的世界里,几乎每一行代码都离不开 类型。它是编译器检查我们代码的依据,是运行时保证程序安全的基础,更是我们理解 Go 诸多特性(比如接口、组合、泛型)的关键。

可以说, 对 Go 类型系统认知的高度,直接决定了你 Go 编程能力的深度。不深入理解它,你可能会在类型转换、接口使用、泛型约束等方面遇到各种“坑”。

那么,这节课,我们就来揭开Go类型系统的神秘面纱。我将带你一起探索:

-

编程语言中为什么需要类型这个抽象?

-

类型系统究竟是什么,它有哪些分类?

-

Go的类型系统有哪些独特的设计选择?它的规则和机制是怎样的?

准备好了吗?让我们先从最根本的问题开始:为什么要有类型?

类型的存在意义:编程语言为何需要它?

作为有经验的 Gopher,你肯定知道 Go 提供了丰富的内置类型(布尔、整型、浮点、复数、字符串、函数等),复合类型(数组、切片、map、struct、channel),代表行为抽象的接口类型,以及指针类型。我们还能通过 type 关键字自定义新类型或定义类型别名。

但你有没有想过:为什么编程语言需要类型?它究竟带来了什么好处?

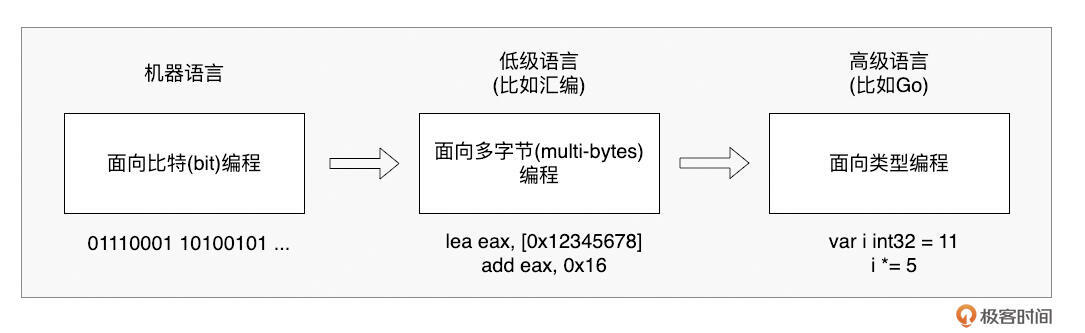

回顾编程语言的发展史,我们会发现一个关键点: 类型是高级语言区别于机器语言和汇编语言的重要抽象。

在机器眼中,一切数据都是 0 和 1。直接用机器码编程,复杂、低效且极易出错。汇编语言稍好一些,它操作的是固定长度的字节,比如 movb 操作 1 字节, movl 操作 4 字节,但它依然不关心这些字节代表的真正含义,只是在地址间搬运数据。

高级语言的“高级”之处,很大程度上就体现在类型这个抽象上。

类型,为开发者屏蔽了底层数据的复杂表示。 我们不再需要关心某个值在内存中具体是多少位、字节序如何,只需要跟类型打交道。类型告诉我们:

-

这个值能存储什么范围的数据(比如 int8 vs int64)?

-

能对它进行哪些操作(比如字符串拼接 vs 整数加法)?

-

它需要多少存储空间?

-

它如何与其他类型互动(转换、组合、实现接口等)?

可以说, 类型成为了开发者与编译器之间高效沟通的“操作界面”。我们面向类型编程,遵循类型的规则,而类型之下的复杂比特和字节操作,则由编译器和运行时帮我们处理。

那么,是谁赋予了类型这些能力和规则呢?答案就是—— 类型系统。

类型系统概览:约束与表达力

类型系统,并不是一个看得见摸得着的实体,而是围绕类型建立的一整套规则和机制。它贯穿于语言规范、编译器和运行时,共同定义、管理和约束着类型的使用。

-

语言规范层面:定义类型的种类、层次、语法语义、使用约束等,给开发者提供明确指引。

-

编译器层面:执行类型检查,确保类型兼容性、转换有效性等,在编译期捕捉大量潜在错误。

-

运行时层面:支持多态(根据实际类型动态绑定方法)、动态类型检查(如类型断言)等。

简单来说, 类型系统通过赋能和管理类型,来保证程序的正确性、安全性和可靠性。

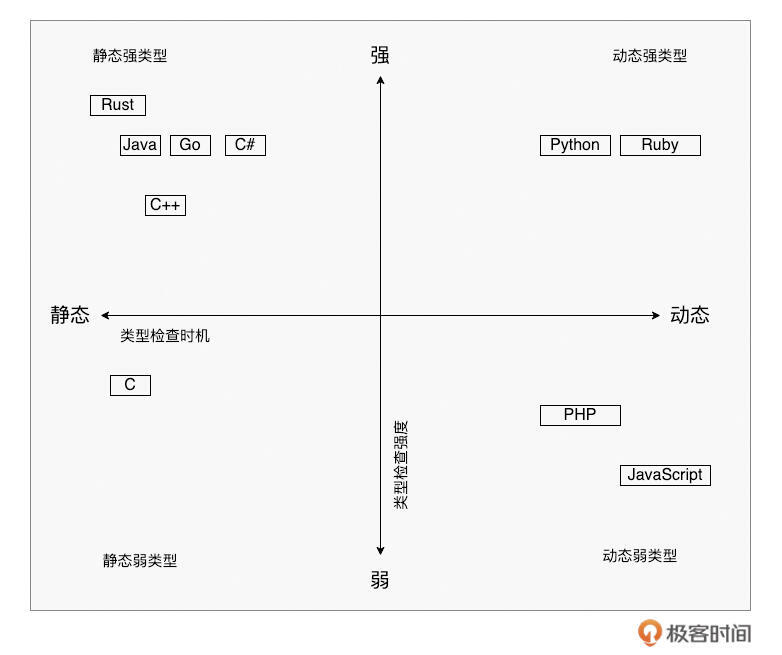

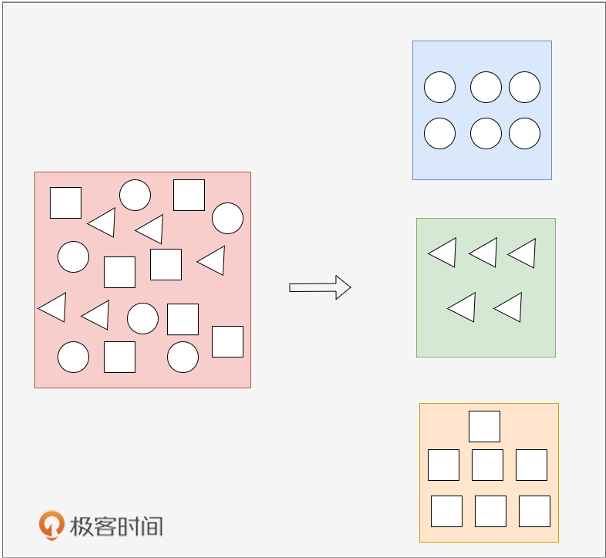

当然,不同语言的类型系统设计差异很大。主要的区别在于检查类型的时机和检查的严格程度。

- 按检查时机分:

-

静态类型系统:尽可能在 编译期间 进行类型检查。变量类型在编译时确定,能及早发现类型错误。代表:Go、C、C++、Java 以及 Rust 等。

-

动态类型系统:主要在 运行时 进行类型检查。变量类型可变,更灵活,但错误可能到运行时才暴露。代表:Python、JavaScript 以及 Ruby 等。

-

- 按检查严格程度分:

-

强类型系统:类型检查严格,不允许隐式或不合理的类型混合操作和转换。强调类型安全。代表:Go、Java、Rust、C++(相对于其他强类型语言,其类型检查严格程度略弱一些)、Python(注意 Python 是动态强类型)等。

-

弱类型系统:类型检查相对宽松,允许一定程度的隐式类型转换和混合操作。更便利,但可能隐藏类型风险。代表:C、JavaScript、PHP 等。

-

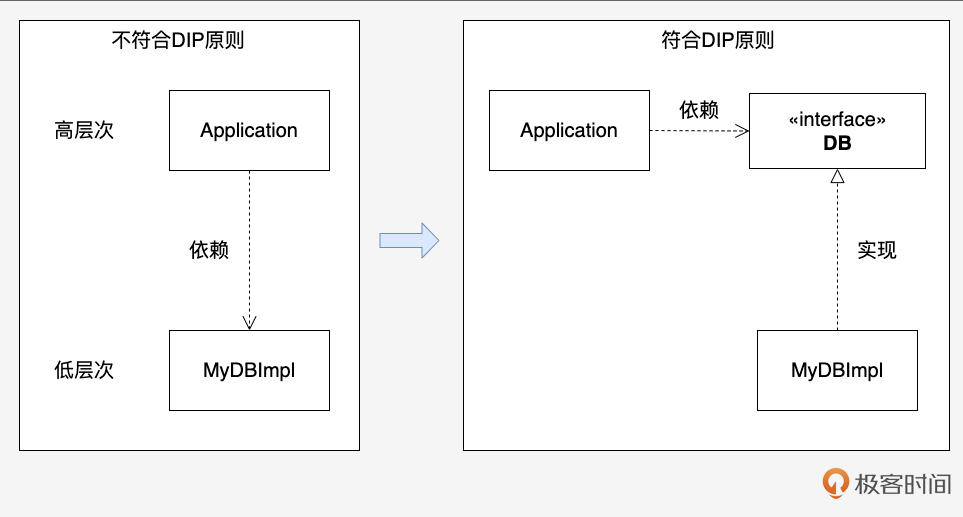

下面我们再用一张示意图,直观地展示这些主流编程语言的类型系统在“检查时机”和“检查严格程度”象限图中的位置。

了解了这些分类,我们就清楚了 Go 的定位: Go 拥有一个静态强类型系统。这意味着它倾向于在编译阶段就发现尽可能多的类型错误,并且对类型的匹配和转换要求非常严格。

接下来,让我们聚焦 Go,看看它的类型系统具体有哪些独特的设计和规则。

Go语言类型系统的独特设计与选择

要理解 Go 的类型系统,关键在于弄懂它围绕类型建立的具体规则。我们从类型定义、类型推断、类型检查和类型连接这几个方面来看。

类型定义:内置与自定义

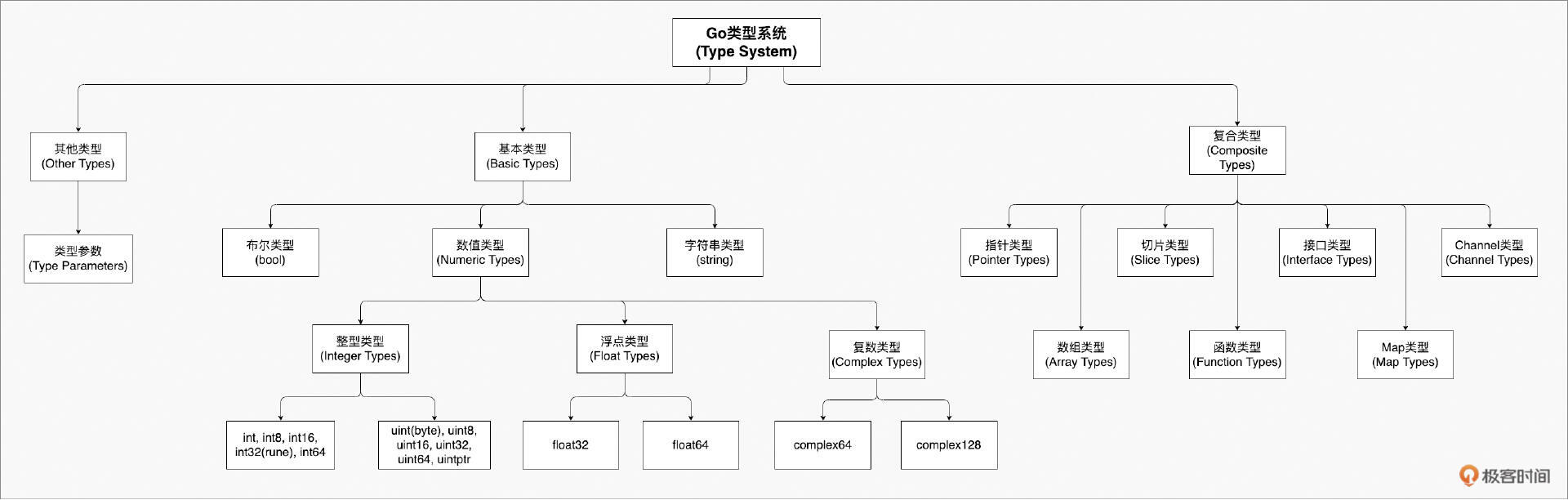

类型是开发者用来抽象现实世界的工具。Go 内置了丰富的类型,我们通过一张示意图来看一下 Go 类型系统中的类型:

从图中我们看到,Go 语言的类型系统主要包含基本类型和复合类型。

其中,内置的基本类型包括布尔类型 bool(表示 true 和 false),以及多种数值类型:整数类型 int8、int16、int32、int64、uint8、uint16、uint32、uint64、int、uint、uintptr,浮点类型 float32、float64,以及复数类型 complex64、complex128。

byte 是 uint8 的别名,rune 是 int32 的别名。此外,还有字符串类型 string,表示不可变的字节序列。

复合类型则包括数组类型、切片类型、结构体类型、指针类型、函数类型、接口类型、Map 类型以及 Channel 类型。

除了这些,我们还可以使用 type 关键字来创造自己的类型:

// 定义一个新类型 T,其底层类型是 U

type T U

这里的 U 被称为 T 的底层类型(underlying type)。这是一个非常重要的概念! 类型系统会认为自定义类型 T 和它的底层类型 U 是两个完全不同的类型。这是编译期类型检查的基础规则之一。

type MyInt int // MyInt 是一个新类型,底层类型是 int

type S struct { // S 是一个新类型

a int

b string

}

Go 1.9 之后,还引入了 类型别名(type alias):

// 定义 P 作为 Q 的别名

type P = Q

注意,这里并 没有 创建新类型。 P 和 Q 在类型系统看来是完全等价并可以互换的。别名机制的引入主要是为了方便代码重构。

秉承“简单”的设计哲学,Go 类型系统并未内置支持其他语言中常见的几种类型。

第一种是 联合体类型(union)。在这种类型中,其所有字段共享同一个内存空间,比如下面 C 语言例子代码中 num 类型:

union num {

int m;

char ch;

double f;

};

union num a, b, c; // 声明三个union类型变量

这段 C 代码定义了一个名为 num 的联合体类型,其三个成员 m、ch 和 f 共享同一个内存空间,C 编译器会以最大的字段的 size 为 num 类型的变量分配内存空间。

另外一种Go语言不支持的是 枚举类型(enum)。Go 没有原生的 enum 关键字。但我们可以通过 常量(通常配合 iota)和 自定义类型 来模拟基础的枚举行为(值仅限布尔、数值或字符串)。

// C语法枚举

enum Weekday {

SUNDAY,

MONDAY,

TUESDAY,

WEDNESDAY,

THURSDAY,

FRIDAY,

SATURDAY

};

// Go模拟实现Weekday

type Weekday int

const (

Sunday Weekday = iota

Monday

Tuesday

Wednesday

Thursday

Friday

Saturday

)

对于像 Rust 语言实现的新式枚举类型(见下面例子),Go 类型系统目前是无能为力的。Rust 中的枚举可以包含关联的数据,每个枚举成员可以有不同的数据类型,并且可以使用 match 表达式对枚举进行模式匹配,处理每个可能的枚举成员和关联的数据。

// Rust的枚举示例

enum Shape {

Circle(f64), // 圆形,关联半径 (f64 类型)

Rectangle(f64, f64), // 矩形,关联宽度和高度 (两个 f64 类型)

Triangle(f64, f64, f64), // 三角形,关联三条边的长度 (三个 f64 类型)

}

fn main() {

let circle = Shape::Circle(3.14);

let rectangle = Shape::Rectangle(2.0, 4.0);

let triangle = Shape::Triangle(3.0, 4.0, 5.0);

// 使用 match 表达式匹配枚举成员并访问关联数据

match circle {

Shape::Circle(radius) => {

println!("Circle with radius: {}", radius);

},

_ => {}

}

match rectangle {

Shape::Rectangle(width, height) => {

println!("Rectangle with width: {} and height: {}", width, height);

},

_ => {}

}

match triangle {

Shape::Triangle(a, b, c) => {

println!("Triangle with sides: {}, {}, {}", a, b, c);

},

_ => {}

}

}

最后一种 Go 类型系统不支持的类型是 元组类型(tuple)。元组类型是一种用于组合多个值的数据结构。它是一个有序的集合,其中的每个元素可以具有不同的类型。元组允许将多个值绑定在一起,形成一个逻辑上相关的单元,可以作为单个实体进行传递、返回或操作。

元组的长度是固定的,一旦定义,就不能添加或删除元素。元素可以通过索引来访问,通常使用点号(.)或类似的语法来访问元组的成员。下面是 Rust 中关于元组使用的一个示例:

fn get_person_info() -> (String, u32, bool) { // 返回一个元组类型

let name = String::from("Alice");

let age = 30;

let is_employed = true;

(name, age, is_employed)

}

fn main() {

let person = get_person_info();

let name = person.0; // 通过索引来访问元组中的元素

let age = person.1;

let is_employed = person.2;

println!("Name: {}", name);

println!("Age: {}", age);

println!("Employed: {}", is_employed);

}

虽然没有内置支持元组类型,但在 Go 中我们可以通过以下方式来实现类似元组的功能。

我们可以定义一个结构体,其中的字段对应元组中的各个元素。每个字段可以具有不同的类型。例如:

type Tuple struct {

First int

Second string

Third bool

}

使用结构体可以方便地将多个值组合在一起,并通过访问结构体的字段来获取和操作元组的元素。

我们还可以使用数组或切片来模拟元组类型。可以定义一个固定长度的数组,其中的每个元素对应元组中的一个元素,类型为 interface{}。例如:

tuple := [3]interface{}{42, "Hello", true}

这里使用了一个 interface{} 类型的数组,其中的元素可以是任意类型。通过索引来访问数组的元素,就可以获取和操作元组中的元素。

需要注意的是,上面使用结构体、数组/切片方式仅是模拟元组,不同方式模拟得到的“元组”会丧失一些元组类型的特性,例如固定长度、类型安全或索引访问等。

Go 1.18 引入了 泛型,通过 类型参数(type parameter) 极大地增强了语言的表达力,也给类型系统带来了新的维度。我们可以定义泛型函数、泛型类型以及它们的约束。

// 定义一个泛型约束 (Go 1.21及以后可用cmp.Ordered的预定义约束)

type Ordered interface {

~int | ~int8 | ~int16 | ~int32 | ~int64 |

~uint | ~uint8 | ~uint16 | ~uint32 | ~uint64 |

~float32 | ~float64 |

~string

}

// 泛型函数

func Max[T Ordered](x, y T) T { /* ... */ }

// 泛型类型

type Stack[T any] struct { items []T }

// 泛型类型的方法

func (s *Stack[T]) Push(item T) { /* ... */ }

func (s *Stack[T]) Pop() (T, bool) { /* ... */ }

泛型无疑让 Go 更强大,但也增加了类型系统的复杂性。关于泛型的深入探讨,可以回顾 《 Go语言第一课》 专栏的泛型篇,或关注本专栏后续可能涉及的泛型实践内容。

类型推断:简洁之道

Go 从一开始就支持基本的类型推断(type inference),编译器能自动推导出变量或常量的类型,让我们少写很多代码:

var s = "hello" // 编译器推断 s 为 string 类型

a := 128 // 编译器推断 a 为 int 类型

const f = 4.3567 // 编译器推断 f 为 untyped float, 默认 float64

泛型引入后,类型推断能力进一步增强,编译器通常能自动推断出调用泛型函数或实例化泛型类型时所需的 类型实参(type argument):

import "slices"

nums := []int{3, 1, 4}

slices.Sort(nums) // 无需写 slices.Sort[[]int, int](nums)

strs := []string{"b", "a", "c"}

slices.Sort(strs) // 无需写 slices.Sort[[]string, string](strs)

无论是普通变量还是泛型参数的类型推断,都起到了 语法糖 的作用,减少了代码的冗余,提高了可读性。

类型检查:编译与运行时的守护

作为静态语言,Go 要求变量在使用前必须声明类型。编译器和运行时会进行 类型检查(type checking),确保我们对变量的操作是合法的,遵守类型系统的规则,从而保障 类型安全(type safety)。

Go 是强类型语言,严格限制 隐式类型转换(implicit type conversion)。绝大多数情况下,不同类型之间的转换必须通过 显式类型转换(explicit type conversion) 来完成,并且只有在 底层类型(underlying type) 兼容时才允许转换:

type T1 int

type T2 struct{}

type MyInt int // 新类型,底层是 int

var i int = 5

var t1 T1

var s T2

var mi MyInt

// t1 = i // 错误:类型不匹配 (T1 和 int 是不同类型)

t1 = T1(i) // 正确:显式转换,底层类型 (int) 兼容

// s = T2(t1) // 错误:底层类型不兼容 (struct{} 和 int)

// mi = i // 错误:类型不匹配 (MyInt 和 int 是不同类型)

mi = MyInt(i) // 正确:显式转换

// i = mi // 错误:类型不匹配

i = int(mi) // 正确:显式转换

但是,有一个重要的“例外”规则与赋值有关!

思考一下这个例子:

type MyInt int

type MyMap map[string]int

var x MyInt

var y int

// x = y // 报错: cannot use y (type int) as type MyInt in assignment

x = MyInt(y) // ok

var m1 MyMap

var m2 map[string]int

m1 = m2 // 不报错!

m2 = m1 // 也不报错!

为什么 MyInt 和 int 之间赋值需要显式转换,而 MyMap 和 map[string]int 之间可以直接赋值?

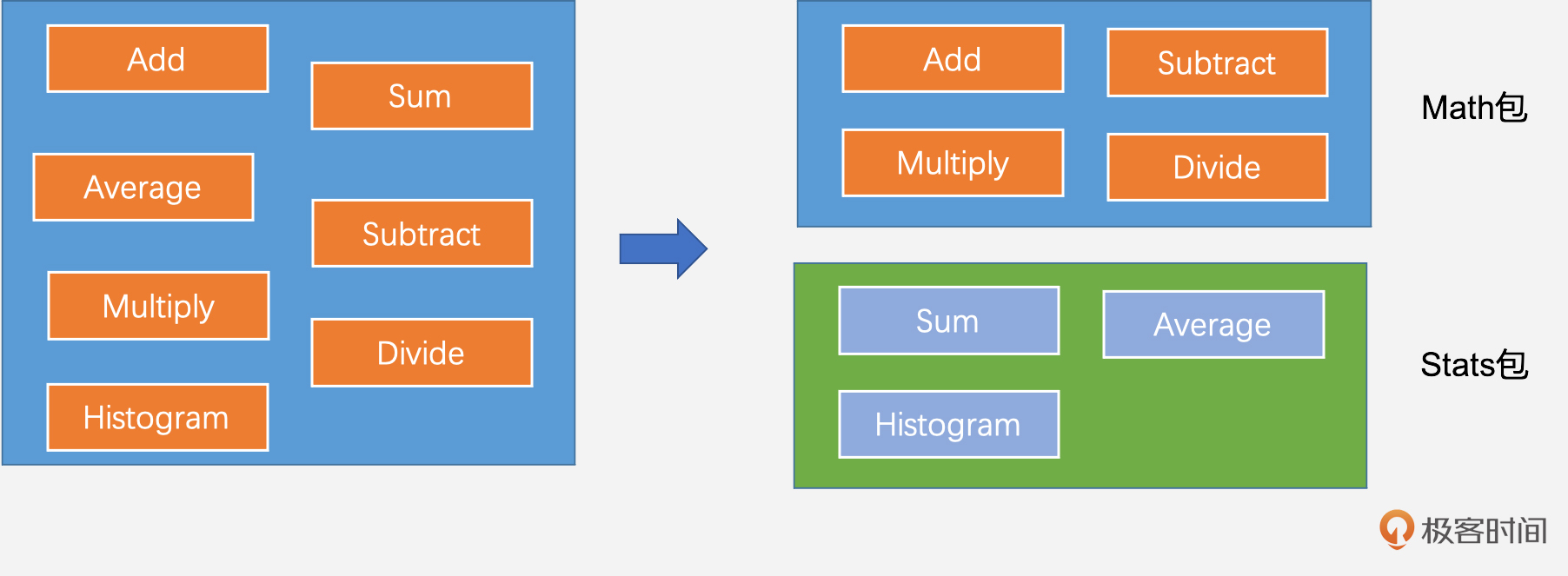

关键在于具定义类型(defined type)这个概念(在引入类型别名前也叫named type)。

Go语言规范规定:如果变量 x 的类型 V 与类型 T 具有相同的底层类型,并且 V 和 T 中至少有一个不是 defined type,那么 x 就可以直接赋值给类型为 T 的变量。

那么,哪些是 defined type?Go 语言规范给出的定义如下:

-

所有通过

type NewType BaseType定义的新类型都是 defined type (如MyInt,MyMap)。 -

Go 内置类型中,所有数值类型(int, float64 等)、string 类型、bool 类型都是defined type。

注意:map、slice、array、channel、func 这些复合类型本身不是 defined type!

现在再来看看上面的例子:

-

MyInt是 defined type,int也是 defined type。两者底层类型相同,但都不是“非defined type”,所以赋值需要显式转换。 -

MyMap是 defined type,但它的底层类型map[string]int不是 defined type。满足了“至少有一个不是 defined type”的条件,因此它们之间可以直接赋值。

理解 defined type 和赋值规则对于深入掌握Go类型系统至关重要。

除了编译期的静态检查,Go 类型系统还提供了运行时的动态类型检查:

-

接口类型检查:运行时检查存入接口变量的实际值是否真的实现了该接口的所有方法。

-

数组/切片下标检查:运行时检查访问的索引是否越界,越界则

panic。 -

类型断言(type assertion):在运行时检查接口变量底层存储的具体类型,并可以获取该类型的值。

var x interface{} = 42

// 安全的类型断言

if i, ok := x.(int); ok {

fmt.Printf("x is an int with value %d\n", i)

} else {

fmt.Println("x is not an int")

}

// 非安全的类型断言 (如果 x 不是 int 会 panic)

// j := x.(int)

当然,Go也提供了打破类型系统约束的“后门”—— unsafe.Pointer 和 反射(reflection)。

unsafe.Pointer 允许你在不同类型的指针间进行转换,直接操作内存,完全绕过类型检查。

标准库 math.Float64frombits 就是一个例子:

// $GOROOT/src/math/unsafe.go

func Float64frombits(b uint64) float64 {

// 将 uint64 的内存解释为 float64

return *(*float64)(unsafe.Pointer(&b))

}

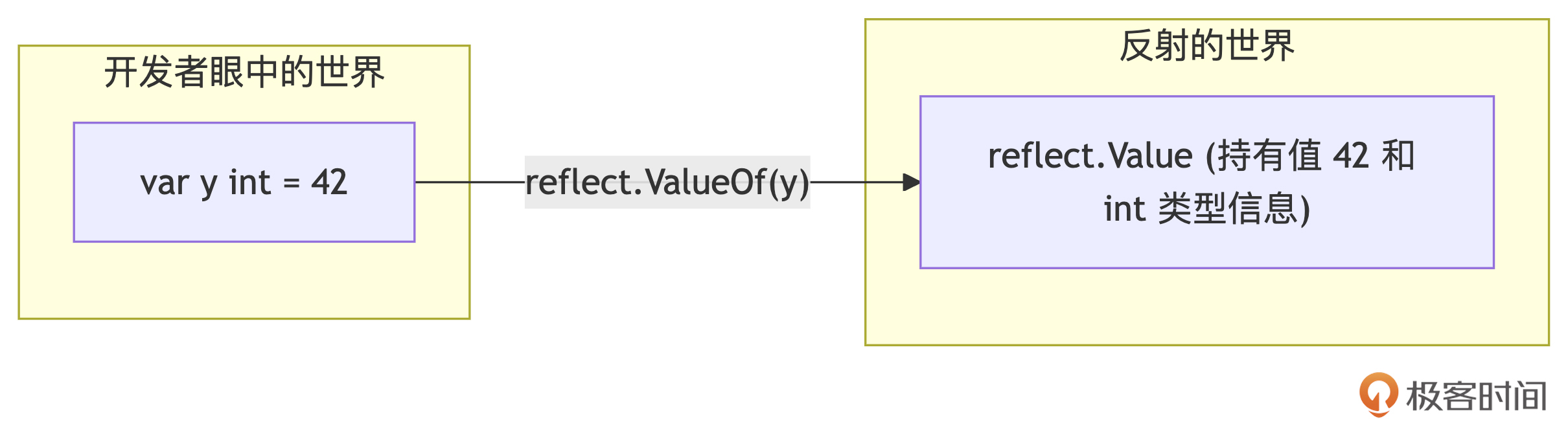

反射允许在运行时检查类型信息、获取和设置值、调用方法等,也能在一定程度上绕过编译期类型检查。

import "reflect"

type MyStruct struct{ Field int }

func main() {

s := MyStruct{Field: 10}

v := reflect.ValueOf(&s).Elem() // 获取可设置的 Value

f := v.FieldByName("Field")

if f.CanSet() {

f.SetInt(20) // 通过反射修改了MyStruct的字段值

}

fmt.Println(s) // Output: {20}

}

警告: 使用 unsafe 和反射是非常危险的,它们破坏了Go的类型安全保证,可能导致程序崩溃或难以预料的行为。除非你完全清楚自己在做什么,并且没有其他更安全的方法,否则, 强烈建议避免使用。

类型连接:组合优于继承

Go 并非经典的面向对象语言。它没有类(class),没有继承(inheritance)层级,也没有构造函数。

在 Go 的类型系统中,类型之间建立连接的主要方式是 组合(composition),通常通过 类型嵌入(type embedding) 实现。我们可以将一个类型(接口或非接口)嵌入到另一个类型(通常是struct)中,从而“借用”或“聚合”其字段和方法。

下面示例中 Server 直接使用了其嵌入的类型 *Logger 的 Log 方法:

type Logger struct { Verbose bool }

func (l *Logger) Log(msg string) { fmt.Println(msg) }

type Server struct {

*Logger // 嵌入 Logger 类型 (指针形式)

Addr string

}

func main() {

s := Server{

Logger: &Logger{Verbose: true},

Addr: ":8080",

}

s.Log("Server starting...") //可以直接调用嵌入类型的 Log 方法

fmt.Println(s.Verbose) // 也可以直接访问嵌入类型的字段

}

Go 的多态性主要通过接口(interface)实现。接口定义了一组行为(方法签名),任何类型只要实现了接口要求的所有方法,就被视为 隐式地(implicitly) 实现了该接口,无需像 Java 或 C# 那样显式声明 implements。

type Speaker interface {

Speak() string

}

type Cat struct{}

func (c Cat) Speak() string { return "Meow" }

type Human struct{}

func (h Human) Speak() string { return "Hello" }

func MakeSpeak(s Speaker) {

fmt.Println(s.Speak())

}

func main() {

var c Speaker = Cat{} // Cat 实现了 Speaker 接口

var h Speaker = Human{} // Human 也实现了

MakeSpeak(c) // Output: Meow

MakeSpeak(h) // Output: Hello

}

这种隐式实现让 Go 的接口非常灵活和解耦。

此外,Go 中的 函数是一等公民,可以赋值给变量、作为参数传递、作为返回值。这使得函数类型本身也展现出一种形式的多态性:一个函数类型的变量可以在运行时指向不同的函数实现,从而表现出不同的行为。

type FilterFunc func(string) bool

func IsLong(s string) bool { return len(s) > 5 }

func HasPrefixA(s string) bool { return strings.HasPrefix(s, "A") }

func FilterStrings(strs []string, filter FilterFunc) []string {

var result []string

for _, s := range strs {

if filter(s) {

result = append(result, s)

}

}

return result

}

func main() {

words := []string{"Apple", "Banana", "Ant", "Orange", "Apricot"}

longWords := FilterStrings(words, IsLong)

fmt.Println(longWords) // Output: [Banana Orange Apricot]

aWords := FilterStrings(words, HasPrefixA)

fmt.Println(aWords) // Output: [Apple Ant Apricot]

}

小结

好了,关于 Go 类型系统的第一课就到这里。我们来快速回顾一下核心要点。

-

类型是关键抽象:它屏蔽了底层细节,是开发者与编译器沟通的界面,提高了编程效率和代码可读性。

-

类型系统是规则集:围绕类型建立,贯穿编译和运行时,保证类型安全。Go 拥有静态、强类型系统,强调编译期检查和严格性。

-

Go 类型定义:内置丰富类型,支持 type 定义新类型(产生不同类型,关注底层类型)和 type alias 定义别名(类型等价)。不支持 union、enum、tuple,但可模拟。Go 1.18 加入 泛型 增强了表达力。

-

Go 类型推断:编译器能自动推断变量、常量及泛型参数类型,简化代码。

-

Go 类型检查:编译期严格检查,限制隐式转换,需 显式转换。运行时检查接口实现、数组/切片越界、类型断言。理解 defined type 对掌握赋值规则很重要。unsafe 和反射可绕过检查,但需极度谨慎。

-

Go 类型连接:摒弃继承,采用组合(通过类型嵌入)和接口(隐式实现)来构建类型关系和实现多态。函数作为一等公民也提供了一种多态形式。

总的来说,Go 的类型系统设计简洁、一致,以 可读性 和 类型安全 为优先考量。虽然有时需要开发者编写更明确的代码(如显式转换),但这有助于构建更健壮、更易于维护的系统。

对于想要在Go编程道路上进阶的你来说,花时间深入理解 Go 类型系统的设计哲学和具体规则,是非常有价值的。它将为你后续学习 Go 的并发、接口设计、错误处理、泛型应用等打下坚实的基础。

如果小伙伴对编程语言的类型系统理论感兴趣,这里推荐阅读一下《 编程与类型系统》这本书。

思考题

Go 语言选择了静态强类型系统。相比之下,像 Python 这样的动态类型语言将许多类型检查推迟到运行时。请你思考一下:

-

Go 采用静态强类型系统,主要的优点是什么?它给开发者带来了哪些好处?

-

同时,这种选择可能带来哪些挑战或不便之处(相比动态类型语言)?

欢迎在留言区分享你的思考和见解!也欢迎你把这节课分享给更多对 Go 类型系统感兴趣的朋友。我是Tony Bai,我们下节课见!

Go兼容性:你的代码能在未来版本运行吗?

你好,我是 Tony Bai。

上一讲,我们深入了 Go 语言类型系统的设计哲学。一个好的类型系统是构建可靠软件的基石,但要让我们的 Go 程序经受住时间的考验,光有类型安全还不够。

Go 语言本身也在不断进化,新版本、新特性层出不穷。这就引出了一个对所有工程师都至关重要的问题: 我的 Go 代码,在未来的 Go 版本中还能跑吗?反过来,我用了新特性的代码,能在旧环境编译运行吗?

这背后,就是兼容性(Compatibility)的问题。对任何一门被广泛应用的语言来说,兼容性都是生命线。你肯定不希望每次 Go 升级,都意味着大量的代码修改和潜在的生产事故。

幸运的是,Go 从诞生之初就极其重视兼容性。著名的 Go 1 兼容性承诺 像定海神针一样,保证了语言和标准库核心 API 的稳定性,这是 Go 能在工业界快速普及的关键因素之一。

但 Go 的兼容性策略不止于此。它还创造性地引入了 向前兼容 的概念,并通过 GODEBUG 和 GOEXPERIMENT 这两个环境变量提供了更精细的控制手段。这种“ 向后保稳定 + 向前可管理 + 实验有控制”的组合拳,让 Go 得以在稳健发展的同时,又能拥抱变化,持续创新。

那么这节课,我们就来彻底搞懂 Go 的兼容性大法。我将带你:

- 深入理解 Go 1 向后兼容性承诺的具体内容和适用范围。

- 弄清楚 Go 向前兼容性是什么,以及 Go 1.21 后引入的新机制(如 go 指令语义变化、toolchain 指令、GOTOOLCHAIN 环境变量)如何工作。

- 掌握如何使用 GODEBUG 和 GOEXPERIMENT 来微调运行时行为和尝鲜实验性特性。

- 最后,我会在小结里给你一些编写高兼容性 Go 代码的实用建议。

理解 Go 的兼容性策略,不仅能让你更有信心地管理项目的 Go 版本依赖,还能让你更深刻地理解 Go 团队的演进哲学。让我们开始吧!

向后兼容性保证

Go 1 兼容性承诺是什么?

在 Go 1.0 发布前,Go 语言处于快速迭代期,语言规范和标准库 API 频繁变动,给早期使用者带来了不小的痛苦。为了改变这一局面,Go 团队在发布 1.0 版本时,郑重地做出了 Go 1 兼容性承诺。

这份承诺的核心内容,记录在官方文档 Go 1 and the Future of Go Programs 中(这里直接将摘录的核心片段译为了中文):

按照 Go 1 规范编写的程序将在该规范的整个生命周期内继续正确编译和运行,无需更改。在某个不确定的时间点,可能会出现 Go2 规范,但在此之前,即使出现 Go 1 的未来“点”版本(Go 1.1、Go 1.2 等),今天可以运行的 Go 程序也应该可以继续运行。

这个承诺意味着什么?意味着 稳定!开发者可以放心地使用 Go 1.x 版本进行开发,不必担心下一个小版本升级(比如从 1.18 到 1.19)会导致现有代码无法编译或运行。这极大地降低了采用和维护 Go 项目的成本,是 Go 能够在生产环境中被广泛应用的关键基石。

那么,这个承诺具体涵盖哪些内容呢?它的边界又在哪里呢?

Go 1 兼容性规则的适用范围

首先要明确这个承诺是 源代码层面 的,不保证不同 Go 版本编译出的二进制包(如 .a 文件)互相兼容。

其次,承诺并非覆盖所有方面,主要针对以下两个核心领域。

- 语言规范(Language Specification)

Go 保证 Go 1.x 系列中的 语法和语义 是稳定的。只要你的代码符合某个 Go 1.x 版本的规范,它就应该能在所有后续的 Go 1.x 版本中正确编译和运行。这个保证主要由 Go 团队维护的官方编译器 gc(以及 gccgo)来兑现。

自 Go 1 发布以来,语言规范确实只做了微小的、向后兼容的调整。例如,Go 1.9 引入 类型别名(type alias),Go 1.18 引入 泛型(generics),这些都是对语言的扩展,并没有破坏现有代码的兼容性。

- 标准库(Standard Library)

Go 保证标准库中公开 API(exported API)的行为是稳定的。如果你只使用了标准库公开的函数、类型、变量、常量,那么在后续 Go 1.x 版本中,它们的行为应该保持一致。

例如,Go 1.16 虽然将 io/ioutil 包标记为废弃,并将其功能迁移到 io 和 os 包,但 io/ioutil 包依然存在且可用,只是不推荐继续使用。需要注意: Go1 兼容性承诺不适用于标准库的内部实现。 Go 团队可以自由修改内部实现细节,只要不影响公开 API 的行为。

当然,凡事皆有例外。Go 1 兼容性承诺也并非绝对的“铁板一块”。在极其特殊的情况下,为了修复严重问题,Go 团队可能会做出不兼容的更改。官方文档列举了一些可能导致不兼容的情况。

- 安全问题:修复严重安全漏洞可能需要破坏兼容性。

- 规范错误:修正语言规范中的明显错误或不一致。

- 编译器/库 Bug:修复违反了规范的实现 Bug。

- 依赖未定义行为:代码如果依赖了规范中未明确定义的行为,后续版本行为可能改变。

- 结构体字面值(省略字段名):如果标准库结构体新增了导出字段,使用

pkg.T{val1, val2}形式的代码会编译失败。推荐使用带字段名的字面值pkg.T{FieldA: val1, FieldB: val2},Go 团队保证这种方式的兼容性。 - 向非接口类型添加方法:在某些嵌入场景下,新增的方法可能与现有方法冲突,导致编译失败。这种情况无法完全避免。

- 点导入(import . “path”):标准库后续新增的导出标识符可能与你的代码冲突。 不建议在非测试代码中使用点导入。

- 使用 unsafe 包:依赖 unsafe 包的代码可能依赖了 Go 的内部实现细节,这些细节不受兼容性保护,升级后可能失效。

一个近期的例子是 Go 1.22 对 for 循环变量语义的修改。Go 1.22 之前,循环变量在整个循环中只有一个实例,Go 1.22 改为每次迭代创建一个新实例。这确实改变了某些依赖旧行为的代码的语义。但 Go 团队认为旧行为是语言规范的“遗留错误”,其修正在兼容性承诺允许的范围内。我们后续课程会详细讨论这个变化。

尽管存在这些例外,Go 团队始终极其谨慎地对待不兼容变更。在绝大多数情况下,你的 Go 1.x 代码都能在不同版本间平滑迁移。

理解了 Go 的向后兼容性,我们再来看看另一个重要维度: 向前兼容性。

Go如何处理向前兼容性?

为什么需要向前兼容性?

向后兼容保证了旧代码能在新环境运行,但解决不了新代码在旧环境运行的问题。

在 Go 1.21 之前,go.mod 文件中的 go 指令(比如 go 1.20)更多的是一个 建议,而非强制约束。你可以用 Go 1.19 甚至 Go 1.15 的工具链去尝试编译一个声明了 go 1.20 的模块。

这会带来什么问题?

- 如果代码恰好没用到 Go 1.20 的新特性,编译可能成功,但隐藏了潜在风险。

- 如果代码用到了新特性,低版本编译器可能会报出一些莫名其妙、难以理解的错误。

- 更糟的是,有时编译“侥幸”通过(比如依赖库的某个内部实现变化),但运行时行为却与预期不符。

这种不确定性很麻烦,尤其是在管理复杂的依赖关系时。你可能自己很小心,但无法保证你依赖的所有库都没有偷偷使用更高版本的特性。

为了解决这个问题,Go 1.21 版本对向前兼容性机制进行了重大改进,让 Go 版本要求更加明确和可靠。

Go 的向前兼容性机制 (Go 1.21+)

Go 1.21及以后版本,通过以下几个关键机制增强了向前兼容性,我们来逐一看一下。

1. go.mod 中 go 指令的语义强化

在 Go 1.21 之前,go.mod 文件中的 go 指令只用于提示开发者该项目的最低 Go 版本要求,但 go 指令并不影响 Go 工具链的选择,无论 go.mod 文件中指定的版本是什么,Go 都会使用当前安装的 Go 版本的工具链来构建。

从 Go 1.21 开始, go.mod 文件中的 go 指令,比如 go 1.21.0,不再仅仅是提示, 而是明确表示编译该模块所需的最低 Go 版本。

这意味着,如果你用 Go 1.21.0 的工具链去编译一个声明了 go 1.21.1 的模块, go 命令会直接拒绝编译,并提示版本过低。这从根本上避免了旧工具链尝试编译新代码时可能出现的各种混乱。

2. 内置工具链管理

强制执行最低版本要求,会不会导致开发者需要频繁手动升级 Go?为了解决这个问题,Go 1.21 引入了 内置的工具链管理 功能(类似于 Node.js 的 nvm 或 Rust 的 rustup),支持在本地“安装”多个版本的 Go 工具链,并根据 go.mod 中的要求使用对应版本的 Go 工具链。

具体来说,当 go 命令(如 go build)发现当前使用的 Go 版本低于 go.mod 中要求的最低版本时,它会 自动下载 所需的、符合要求的 Go 工具链版本,并使用新下载的工具链来执行命令。

例如,你当前环境是 Go 1.21.0,但项目 go.mod 写着 go 1.21.3。运行 go build 时,go工具链会执行如下动作:

- Go 1.21.0 发现版本不够。

- 自动下载 Go 1.21.3 工具链(如果本地缓存没有)。

- 使用下载的 Go 1.21.3 工具链重新执行

go build。

注意:自动下载的工具链通常存储在你的 module cache 目录中(GOMODCACHE),并不会替换你系统全局安装的 Go 版本。

3. 新增 toolchain 指令

除了 go 指令, go.mod 中还可以添加一个 toolchain 指令,用来指定一个 建议使用的工具链版本。这在你希望团队成员使用某个特定版本(可能高于最低要求版本)进行开发时很有用。

module example.com/mymodule

go 1.18 // 最低要求 Go 1.18

toolchain go1.21.4 // 建议使用 Go 1.21.4 或更高版本开发

- toolchain 指令主要影响开发环境,对依赖该模块的其他模块没有影响。

- 通常,toolchain 版本会高于或等于 go 版本。

- 如果未显式设置 toolchain,它会隐式地等于 go 指令指定的版本。

toolchain default表示使用默认行为(基于 go 指令)。

4. 新增 GOTOOLCHAIN 环境变量

为了更精细地控制工具链的选择行为,Go 1.21 还引入了 GOTOOLCHAIN 环境变量。它有多种设置,常用的包括:

- GOTOOLCHAIN=local 强制使用本地安装的 Go 工具链(即你当前运行的 go 命令对应的版本),即使它低于

go.mod的要求。如果版本不满足,则报错。适用于需要严格控制构建环境或离线工作的情况。 - GOTOOLCHAIN=go1.X.Y (例如

GOTOOLCHAIN=go1.21.0)强制使用特定版本的 Go 工具链。go 命令会先在 PATH 环境变量中查找版本为go1.21.0的可执行文件,如果找不到,会尝试下载并使用。适用于需要固定构建版本以保证可重复性的场景。 - GOTOOLCHAIN=auto (或 local+auto,这是默认值)最智能的模式。go 命令会根据

go.mod中的 toolchain 指令(优先)或 go 指令来决定是否需要切换到更新的工具链。切换时,优先使用本地已有的(在 PATH 中找到的),找不到再尝试自动下载。 - GOTOOLCHAIN=go1.X.Y+auto(例如

GOTOOLCHAIN=go1.21.1+auto)类似 auto,但指定了一个默认的基础工具链go1.X.Y。如果这个基础版本不够,再按 auto 的规则尝试升级。 - GOTOOLCHAIN=go1.X.Y+path(或 local+path)类似

go1.X.Y+auto,但禁用自动下载。如果默认或本地路径中找不到满足要求的工具链,则报错。

根据上述 Go 向前兼容性的各种新增和变更的机制,我们来总结一下 Go 工具链的选择过程,以 GOTOOLCHAIN=auto 为例。

-

初始工具链:

go命令开始执行时,会有一个初始的工具链(通常是你安装的 Go 版本)。 -

读取

go.mod:go命令读取go.mod文件,获取go指令和toolchain指令(如果有)。 -

比较版本

a. 如果

toolchain指令存在,且指定的工具链版本比初始工具链新,则进入下一步。b. 如果

toolchain指令不存在(或为default),但go指令指定的版本比初始工具链新,则进入下一步。c. 否则,使用初始工具链,结束选择过程。

-

寻找工具链

a. 根据

toolchain或go指令,确定需要使用的工具链版本(例如go1.23.1)。b. 在

PATH环境变量中查找该版本的工具链(例如查找版本为go1.23.1的可执行文件)。c. 如果找到,使用找到的工具链,结束选择过程。

d. 如果未找到,进入下一步。

-

下载工具链(仅在

auto模式下):a. 从官方网站下载所需版本的工具链。

b. 将下载的工具链存储在 module cache 中。

c. 使用下载的工具链,结束选择过程。

不得不说,上面的 Go 工具链选择过程还是蛮复杂的,不过幸运的是,从 Go 1.24 版本开始,你可以通过 GODEBUG=toolchaintrace=1 来跟踪 go 命令的工具链选择过程,比如:

$GODEBUG=toolchaintrace=1 go build

go: upgrading toolchain to go1.24.1 (required by toolchain line in go.mod; upgrade allowed by GOTOOLCHAIN=auto)

go: downloading go1.24.1 (darwin/amd64)

... ...

通过这些机制的结合,Go 1.21+ 在向前兼容性上实现了巨大飞跃,让开发者能更清晰、更可靠地管理 Go 版本依赖。

基于GODEBUG和GOEXPERIMENT的可控实验

除了宏观的兼容性策略,Go 还提供了两个环境变量,让我们能在更细粒度上控制 Go 的行为,特别是在处理新旧特性切换或尝试实验功能时。

GODEBUG:运行时行为的微调

GODEBUG 用于在运行时控制 Go 程序的行为。它像一个临时的开关面板,让你可以在不修改代码、不重新编译的情况下,调整某些内部机制,主要用于:

-

调试与诊断:开启或关闭特定的运行时跟踪信息,如垃圾回收(

gctrace=1)、调度器(schedtrace=1000)等。 -

兼容性控制:临时启用某个旧版本的行为,以帮助诊断因版本升级引起的问题。例如,Go 1.21 改变了

panic(nil)的行为,如果需要恢复旧行为来排查问题,可以设置GODEBUG=panicnil=1。

设置方式为逗号分隔的键值对:

GODEBUG=name1=value1,name2=value2,... ./your_program

每个 Go 版本支持的 GODEBUG 选项都不同,具体请查阅官方文档 GODEBUG history。

GOEXPERIMENT:实验性特性的尝鲜

与 GODEBUG 控制运行时不同,GOEXPERIMENT 用于在编译时告诉 Go 编译器启用 哪些实验性特性(experimental features)。这些特性是 Go 团队正在探索的新功能或优化,尚未正式发布,通过 GOEXPERIMENT 开放给社区进行测试和反馈。

设置方式为逗号分隔的特性名称,用在 go build、 go run 等编译命令之前:

GOEXPERIMENT=name1,name2,... go build

例如,Go 1.23 引入了一个实验性特性,允许类型别名带有类型参数。要启用它,可以这样编译:

GOEXPERIMENT=aliastypeparams go build

重要提示: GOEXPERIMENT 启用的特性是不稳定的,它们可能在未来版本中发生重大变化,甚至被完全移除(比如曾经在 Go 1.20 中引入的arena包实验)。因此,不建议在生产环境中使用依赖 GOEXPERIMENT 的特性。它仅适用于本地实验和向 Go 团队提供反馈。

小结

这一讲我们深入了解了 Go 语言精心设计的兼容性策略,它远不止简单的“向后兼容”。现在我们来总结一下关键点,并列举几条关于编写高兼容性代码的建议。

-

Go 1 向后兼容性承诺:这是 Go 稳定性的基石。保证了符合 Go 1 规范的代码能在后续 Go 1.x 版本中无需修改即可编译运行(主要针对语言规范和标准库公开 API)。理解其适用范围和少数例外情况很重要。

-

Go 向前兼容性机制(Go 1.21+):解决了新代码在旧环境运行的问题。核心机制包括:

a. go.mod 中 go 指令语义强化(最低版本要求)。

b. 内置工具链管理(自动下载)。

c. 可选的 toolchain 指令(建议开发版本)。

d. 灵活的 GOTOOLCHAIN 环境变量(控制工具链选择行为)。

-

可控实验机制

a. GODEBUG:运行时开关,用于调试、诊断和临时兼容性调整。

b. GOEXPERIMENT:编译时开关,用于尝鲜不稳定的实验性特性,不应用于生产。

-

编写高兼容性代码建议

a. 遵循规范:严格按照 Go 1 规范编码,避免依赖未定义行为和 unsafe。

b. 明确版本:合理设置

go.mod中的 go 指令。c. 拥抱默认:通常使用默认的 GOTOOLCHAIN=auto。

d. 谨慎实验:仅在必要时使用 GODEBUG,避免在生产中使用 GOEXPERIMENT。

e. 善用工具:使用

go vet等工具检查潜在问题。f. 阅读文档:关注每个 Go 版本的 Release Notes,了解兼容性相关的变更。

Go 团队在兼容性上付出的巨大努力,为我们开发者创造了一个既稳定又持续进化的生态。理解并善用这些兼容性策略和工具,能帮助我们编写出更健壮、更易于维护的 Go 代码,从容应对 Go 语言的发展和项目版本的演进。

思考题

最后,留给你两个问题思考:

- 你认为 Go 1 兼容性承诺对 Go 语言的生态系统(比如库的开发、社区的形成)产生了哪些深远的影响?

- 在你的实际 Go 项目开发中,是否遇到过因为 Go 版本升级或版本不匹配导致的兼容性问题?你是如何定位和解决的(可以结合 go 指令、GOTOOLCHAIN 或 GODEBUG 的使用经历来谈谈)?

欢迎在评论区分享你的经验和看法!我是 Tony Bai,我们下节课见。

值传递vs指针传递:深入Go数据操作的底层逻辑与性能考量

你好,我是 Tony Bai。

从这一节课开始,我们将进入 Go 语法细节。作为 Go 进阶者,你一定已经用过值类型(如 int、float64 以及自定义结构体类型)和指针类型(如 *int、*T)。你可能也知道什么时候用值、什么时候用指针,会对程序的性能和行为产生影响。

但你是否真正思考过:

- 当我们说“值”时,在计算机内存层面,它到底意味着什么?

- Go 语言中“一切皆值”的理念,具体是如何体现的?

- Go 的函数参数传递,到底是“值传递”还是“引用传递”?为什么传递指针和传递切片看起来效果不同?

- 在性能和程序正确性之间,我们该如何明智地选择使用值还是指针?

这些问题看似基础,却直击 Go 数据操作的本质。 不深入理解值与指针的底层机制,你可能只是“知其然”,但在面对性能瓶颈、内存问题或复杂的共享状态时,会“不知其所以然”,难以写出真正高质量的 Go 代码。

这节课,我们就来彻底厘清这些概念,我们就将从计算机如何存储数据的底层原理出发,由浅入深、层层推进地讨论 Go 语言中的值类型、指针类型,以及它们在数据传递中的行为表现。同时也会介绍一些在使用值和指针时需要注意的事项。

掌握了这些,你对 Go 的数据操作将有更深刻的认识,为后续学习方法、接口、并发等打下坚实基础。

从计算机内存看“值”的本质

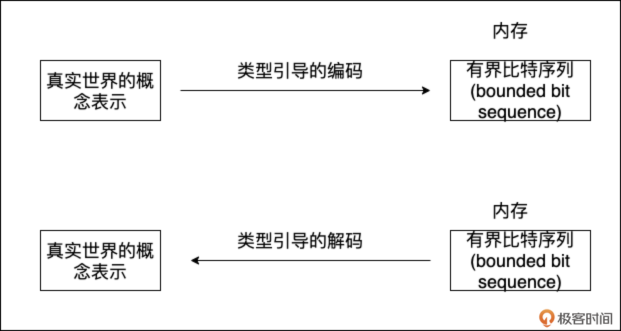

我们人类通过抽象来理解世界,比如数量、大小、颜色、文本。计算机要解决现实问题,也需要对这些概念进行表示。它如何做到的呢?答案是:通过内存中的 有界比特序列(bounded bit sequence)。

无论是整数 1000,还是字符串 “hello”,或者一个复杂的结构体,当它们存储在计算机内存中时,本质上都是一连串的 0 和 1。 这串有界的 0 和 1,我们就可以称之为“一个值(value)”。

而类型(type),则赋予了这段比特序列以含义。同一段比特序列,用不同的类型去“解码 (decode)”,会得到完全不同的结果。

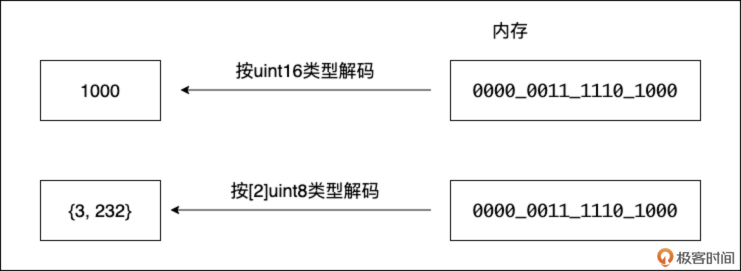

比如,内存中有这样 16 个比特: 0000 0011 1110 1000

- 如果用 uint16 类型去解释,它代表整数 1000。

- 如果用 [2]byte(长度为 2 的字节数组)类型去解释,它可能代表两个字节,数值分别是 3 和 232。

为了方便编程,高级语言引入了 标识符(identifier)(如变量名、常量名)来与内存地址建立关联。我们说变量持有(hold)一个值,实际上是指这个变量名对应着某个内存地址,该地址上存储着那个值的比特序列。

当然,也存在不与任何标识符绑定的值,我们称之为 字面值(literal),常用于初始化变量或常量:

var a int = 17 // 用字面值17初始化变量a

s := "hello" // 用字面值"hello"初始化变量s

const f float64 = 3.14 // 用字面值3.14初始化常量f

fmt.Println(42) // 42是一个整型字面值

原生类型的字面值,可以简单理解为汇编中的立即数;而复杂类型(比如结构体)的字面值,则一般是临时存储在栈上的有界比特序列。

“一切皆值”:Go 语言的核心理念

根据上面关于值的定义,我们可以认为, 在 Go 语言中,所有类型的实例都是以值的形式存在的:包括基本类型,如整数、浮点数、布尔等,以及复杂的数据类型,如结构体、数组、切片、map、channel 等。

到这里你可能会问:“不对吧?我听说 map 和 channel 是引用类型,传递它们更像是传递指针?”别急,要解答这个问题,我们就要来先看看值的分类。

值的分类:不止基本类型

Go 中的值大致可分为三类。

- 基本类型值

基本类型是 Go 语言中最基础的数据类型,它们是直接由语言定义的。基本类型的值通常是简单的值,比如整数、浮点数、布尔值等。在 Go 语言中,基本类型的值可以进行各种运算和比较操作。

- 复合类型值

复合类型则是由基本类型组成的更复杂的数据类型。它们的值由多个基本类型值或复合类型值组合而成,并且可以使用结构化的方式进行访问和操作。

在 Go 语言中,复合类型包括数组、切片、map、结构体、接口、channel 等多种类型。这些复合类型在不同的场景下都有不同的用途,可以用于表示不同的数据结构或者实现不同的算法。

注意,字符串在 Go 中是一个特殊的存在,从 Go 类型角度来看,它应该属于原生内置的基本类型,但从值的角度考虑,由于在运行时字符串类型表示为一个两字段的结构(这在《 Go语言第一课》专栏中有讲过,在后续的课程我们还会提到),因此,我们可将其归为 复合类型值 范畴。

- 指针类型值

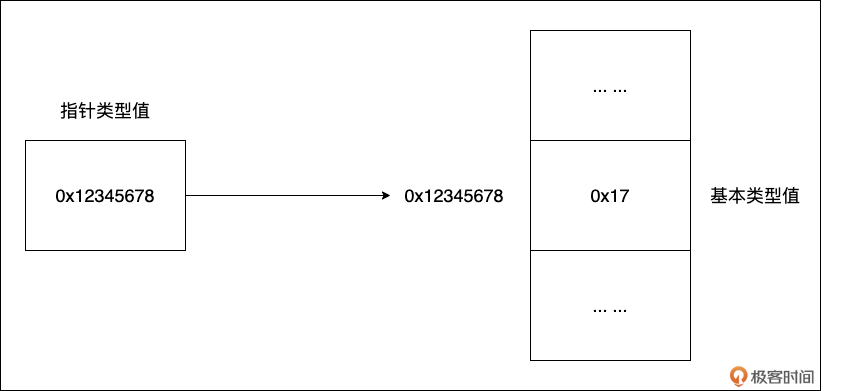

有一类值十分特殊,它自身是一个基本类型值,更准确的说是一个整型值, 但这个整型值的含义却是另外一个值所在内存单元的地址。如下图所示:

我们看到:指针类型值为 0x12345678,这个值是另外一个内存块(值为0x17)的地址。指针类型值在 Go 语言以及 C、C++ 这一的静态语言中扮演着极其重要的角色。

现在我们可以回答前面的问题了: map 和 channel 是值吗?

是的,它们是值。 更准确地说,从 Go 运行时的角度看,一个 map 变量或 channel 变量,其本身存储的值是一个指针,这个指针指向了运行时在堆上分配的、用于实现 map 或 channel 功能的内部数据结构(比如哈希表、缓冲区等)。

所以, 当你传递一个 map 或 channel 变量时,你实际上是在按值传递这个指针。这就是为什么在函数内部对 map 或 channel 进行操作(如添加键值对、发送接收数据)会影响到函数外部的原始变量——因为它们指向的是同一个底层的运行时数据结构。

值的可变性:并非所有值都能修改

虽然从物理内存角度看,内存单元的数据都可以被改写,但在编程语言和操作系统层面,对值的可变性做了限制。

- 内存段限制:操作系统将虚拟内存划分为不同段,如代码段(只读)、数据段、BSS 段、堆、栈等。存储在只读段(如代码段)的值是不可变的。

- 语言层面限制

- 常量(const)定义的值是不可变的。

- 字符串(string)类型的值在 Go 中也是不可变的。尝试修改字符串内容会导致编译错误或创建新字符串。

- 其他大部分类型(如 int、struct 的字段,slice 或 array 的元素)的值,如果它们不在只读内存段且不是常量,则是可变(mutable)的。

指针:特殊的值,重要的工具

针对指针这类值,编程语言抽象出了一种类型: 指针类型,写作 *T。指针类型的变量与指针类型值绑定,它内部存储的是另外一个内存单元的地址。这样就衍生出通过指针读取和更新指针指向的值的操作方法:

var a int = 5 // 基础类型值

var p = &a // p为指针类型变量(*int),其值为变量a的地址。

println(*p) // 通过指针读取其指向的变量a的值

*p = 15 // 通过指针更新其指向的变量a的值

当一个指针变量存储的地址是另外一个指针变量的地址时,我们就有了多级指针:

var x int = 1

var y int = 2

var p *int = &x // p是指向变量x的指针

var q *int = &y // q是指向变量y的指针

var pp **int = &p // pp是指向指针p的指针,即int**类型

可以通过下面的方式来访问和修改多级指针的指向:

fmt.Println(**pp) // 输出1,相当于两次间接访问

pp = &q

fmt.Println(**pp) // 输出2,相当于两次间接访问

**pp = 3 // 相当于y=3,即修改y的值为3

fmt.Println(y) // 输出3

通过多级指针,我们可以实现对同一份数据的多层间接访问和操作。这在某些场景下很有用,最典型的,比如在函数中修改上层函数的局部指针变量的指向:

func changePointer(pp **int) {

var nv = 20

*pp = &nv

}

func main() {

var v = 10

var p = &v

var pp = &p

fmt.Println("Before:", **pp) // 输出 Before: 10

changePointer(pp)

fmt.Println("After:", **pp) // 输出 After: 20

}

需要注意的是,多级指针的使用会增加代码的复杂度,在实际编程中要根据需要适度使用,过度使用反而会降低代码的可读性。

指针更大的好处就在于传递开销低,且传递后,接收指针的函数/方法体中依然可以修改指针指向的内存单元的值。接下来,我们就来详细说一下值的传递。

剖析值传递与指针传递的机制

无论是赋值还是传参,Go 语言中所有值传递的方法都是值拷贝,也称为逐位拷贝(bitwise copy)。不过即便是值拷贝,也会带来三种不同效果,我们逐一来看一下。

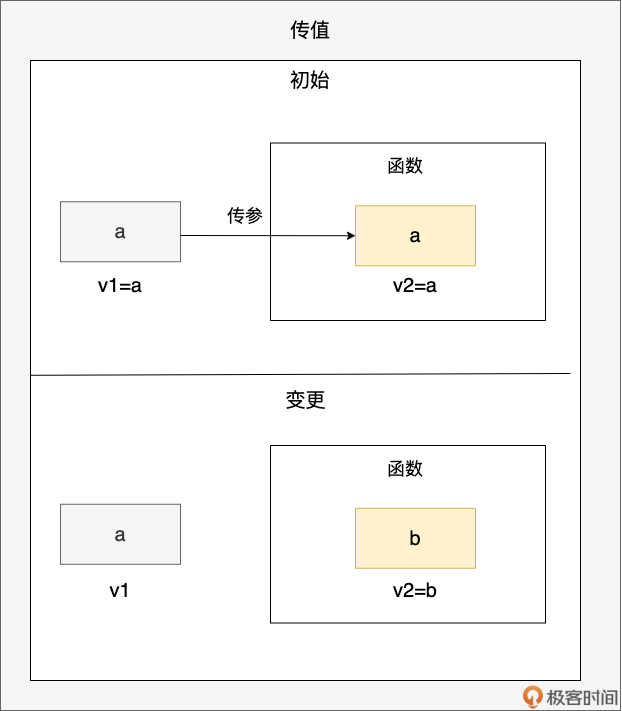

- 传值:你是你,我是我

通过上面传值的示意图,我们看到值变量 v1(初值为 a)被传递到函数参数 v2 中,之后函数内 v2 的值更新为 b,但并不影响 v1,v1 的值仍为 a,用代码表示即为:

func foo(v2 int) {

b := 2

v2 = b // 传递后的v2独立更新为b

_ = v2

}

func main() {

a := 1

v1 := a

println(v1) // 1

foo(v1)

println(v1) // v1值仍为1

}

日常开发中,像传整型、浮点型、布尔值等都属于这种类型的传值。

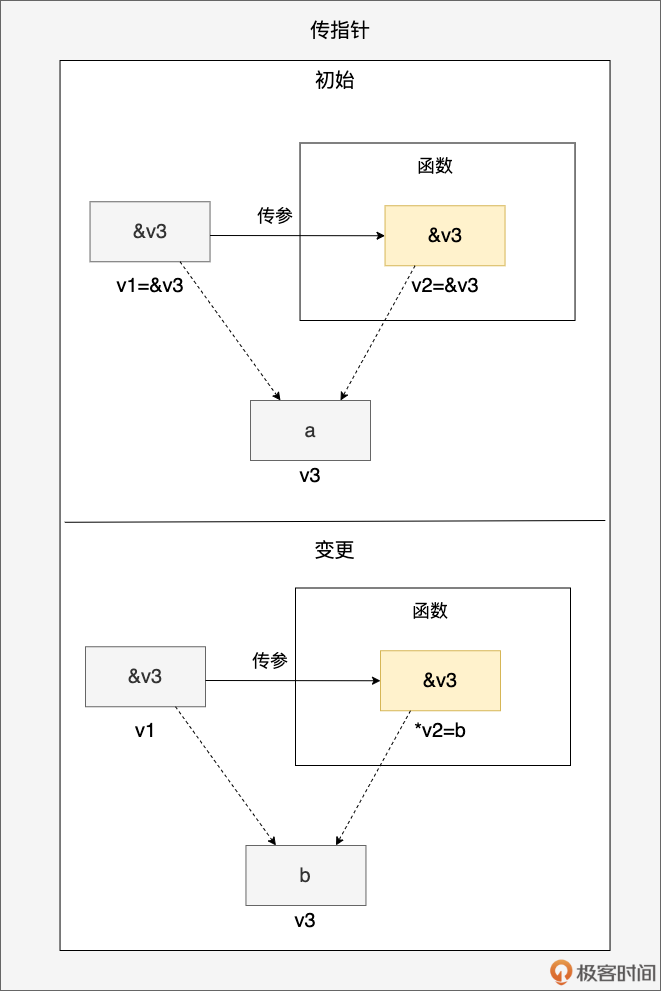

- 传指针:你是你,我是我,但我们共同指向他

通过上面传指针的示意图,我们看到指针变量 v1(初值为 v3 的地址)被传递到函数参数 v2 中,v1 和 v2 拥有相同的指针值,都指向 v3 变量所在的内存块(初值为 a)。当函数通过 v2 指针解引用修改 v3 的值为 b 后,v1 也能感受到相同的变化。用代码表示即为:

func foo(v2 *int) {

b := 2

*v2 = b

}

func main() {

a := 1

v3 := a

v1 := &v3

println(*v1) // 1

foo(v1)

println(*v1) // 2

}

日常开发中,传递 *T 指针类型变量,以及那些在 Go runtime 层面本质是一个指针的类型的实例时,比如 map、channel 等,都归属于这一类型。

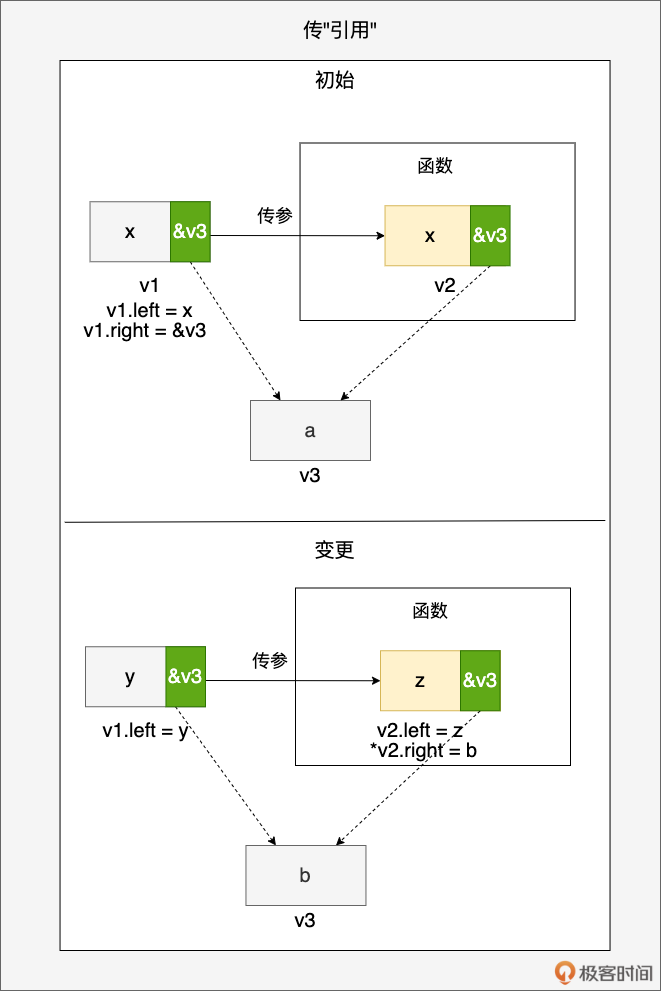

- 传“引用”:你是你,我是我,但我们有一部分共同指向他

首先要注意,Go 语言规范中没有“引用类型”这一表述。其次,也不要将这里的“引用”与其他语言的“引用类型”相提并论。

这里传“引用”的效果是:传递前后的变量一部分是独立更新互不影响的,一部分则是有共同指向,相互影响的。示例图很好理解,这里就不赘述了。

最典型的例子就是切片。 当我们将切片传入函数后,函数内对切片的更新操作会影响到原切片,包括更新切片元素的值、向切片追加元素等。尤其是向切片追加(append)元素后,会导致传递前后的两个切片出现“不一致”,比如下面的示例:

func foo(sl []int) {

sl = append(sl, 5)

sl = append(sl, 6)

fmt.Println(sl, len(sl), cap(sl)) // [1 2 3 4 5 6] 6 8

}

type SliceHeader struct {

Data uintptr

Len int

Cap int

}

func main() {

sl := make([]int, 4, 8)

sl[0] = 1

sl[1] = 2

sl[2] = 3

sl[3] = 4

foo(sl)

fmt.Println(sl, len(sl), cap(sl)) // [1 2 3 4] 4 8

p0 := unsafe.SliceData(sl)

p := (*[8]int)(unsafe.Pointer(p0))

fmt.Println(*p) // [1 2 3 4 5 6 0 0]

}

我们看到:foo 函数实际上已经修改了 sl 对应的底层数组(见最后一行输出结果),但由于传递前的 sl 中的 Len 和 Cap 值并没有变更(如果你尚不清楚切片的 len 和 cap 是什么,可以重温一下《 Go语言第一课》专栏),因此出现了不一致的情况。

因此, 当切片作为函数参数时,我们通常会将修改后的切片作为返回值返回出来,这样就能保持传递前后修改的一致,就像下面代码中那样:

func foo(sl []int) []int {

sl = append(sl, 5)

sl = append(sl, 6)

fmt.Println(sl, len(sl), cap(sl)) // [1 2 3 4 5 6] 6 8

return sl

}

type SliceHeader struct {

Data uintptr

Len int

Cap int

}

func main() {

sl := make([]int, 4, 8)

sl[0] = 1

sl[1] = 2

sl[2] = 3

sl[3] = 4

sl = foo(sl)

fmt.Println(sl, len(sl), cap(sl)) // [1 2 3 4 5 6] 6 8

}

这里之所以使用“引用”来形容这种效果,主要是像切片这样的类型与我们熟知的其他语言中的引用(reference)很像,它们都是以“值”的形态传递,但却能干着“指针”的活儿。

值 vs 指针:选择场景与注意事项

零值:Go的默认与安全

Go 中,变量在声明但未显式初始化时,会被自动赋予其类型的零值。

- 数值类型:

0 - 布尔类型:

false - 字符串类型:

""(空字符串) - 指针、接口、切片、map、channel、函数类型:

nil - 数组、结构体:每个元素或字段都是其类型的零值

零值机制保证了 Go 变量总是有个确定的初始状态,避免了未初始化变量带来的风险。

注意:对 nil 指针、 nil map、 nil slice 等进行解引用或访问操作通常会导致运行时 panic。使用前务必检查是否为 nil(或确保它们已被正确初始化)。

一个特殊用法是零长度数组 [0]T,它的实例不占用内存,常用来使结构体不可比较(因为函数类型不可比较):

type NonComparable struct {

_ [0]func() // 包含不可比较类型,使整个结构体不可比较

Data int

}

// var nc1, nc2 NonComparable

// fmt.Println(nc1 == nc2) // 编译错误

值的比较:并非都能“==”

不是所有 Go 类型都支持使用 == 或 != 运算符进行比较:

func main() {

var sl1 []int

var sl2 []int

var m1 map[string]int

var m2 map[string]int

var f1 = func() {}

var f2 = func() {}

fmt.Println(sl1 == sl2) // invalid operation: sl1 == sl2 (slice can only be compared to nil)

fmt.Println(sl1 != sl2) // invalid operation: sl1 != sl2 (slice can only be compared to nil)

fmt.Println(m1 == m2) // invalid operation: m1 == m2 (map can only be compared to nil)

fmt.Println(m1 != m2) // invalid operation: m1 != m2 (map can only be compared to nil)

fmt.Println(f1 == f2) // invalid operation: f1 == f2 (func can only be compared to nil)

fmt.Println(f1 != f2) // invalid operation: f1 != f2 (func can only be compared to nil)

}

Go 中的切片、map 和函数类型只支持与 nil 进行相等或不等比较。

针对除此之外的其他不同类型,Go 执行的比较操作也是不同的。

- 对于基本类型(如 int、float、bool 等)以及指针类型,只需要比较它们的值的二进制表示就可以了。

- 对于结构体类型(不包含不支持比较的类型的字段),需要逐一比较它们的每个字段。

- 对于数组类型(元素类型不是不可比较类型),需要逐一比较它们的每个元素。

- 对于接口类型,需要判断它们是否指向同一个动态类型以及动态值是否相等。

下面还有一些值比较的注意事项,你也要了解一下。

- 对于浮点数类型,不能使用 “==” 运算符进行比较相等性,因为浮点数的精度问题可能导致比较结果不正确,可以使用 math 包中的函数进行比较。

- 对于结构体和数组类型,如果其中包含不可比较的字段(如切片、map、函数等),则整个结构体和数组类型也是不可比较的。

- 对于切片类型,可以使用 reflect 包中的函数 DeepEqual 进行比较。

- 对于指针类型,需要注意空指针的情况,应该先判断指针是否为 nil,再进行比较。

传值还是传指针:性能与语义的权衡

传值还是传指针是我们日常 Go 编程时经常需要考虑的一个问题。我总结了一下,选择传值还是传指针主要取决于以下三个因素:

- 对象的大小

如果对象的大小较小(例如一个简单的结构体或者基本类型值),建议使用传值的方式,因为这种情况下复制对象的开销相对较小。相反,如果对象的大小较大(例如一个庞大的结构体或者大的数组),建议使用传指针的方式,这样可以避免复制整个对象,从而节省内存和 CPU 开销。

// 传值示例

type SmallStruct struct {

A int

B bool

}

func updateValue(s SmallStruct) SmallStruct {

s.A = 42

s.B = true

return s

}

// 传指针示例

type LargeStruct struct {

Data [1024]byte

}

func updatePointer(s *LargeStruct) {

for i := range s.Data {

s.Data[i] = byte(i % 256)

}

}

- 对象的可变性

如果需要在函数内部修改对象的值,则必须使用传指针的方式,其原因在前面讲解不同传值方式的效果时已经阐明了。如果使用传值的方式,函数内部对对象的修改将不会影响到原始对象。

- 对象是否支持复制

如果对象包含一些不支持或语义上不允许复制的字段(例如 sync.Mutex 等),则必须使用传指针的方式,因为这些字段在复制时会导致编译错误或运行时的非预期结果。

上述的三个因素也同样适用于方法的 receiver 参数类型选择,但还有一个因素会制约 method receiver 的选型,那就是考虑 T 或 *T 是否需要实现某个接口类型。关于 method receiver 的类型选择问题,我们会在后面的课程中有系统的讲解,这里就不赘述了。

总的来说,在选择传值还是传指针时,需要根据对象的大小、可变性和是否支持复制等因素进行权衡,合理选择可以提高程序的性能和可读性。

类型转换与内存解释:unsafe的力量与风险

前面说过,值是一个“有界比特序列”,按照不同类型进行解码,得到的结果也是不同的。我们可以通过 unsafe.Pointer 来进行不同的解码。比如下面例子中,将一个 uint32 的值分别按 [2]uint16 和 [4]uint8 数组类型进行解码后的结果:

package main

import (

"fmt"

"unsafe"

)

func main() {

var a uint32 = 0x12345678

b := (*[2]uint16)(unsafe.Pointer(&a))

c := (*[4]uint8)(unsafe.Pointer(&a))

fmt.Println(*b) // [22136 4660] 按[2]uint16做内存解释

fmt.Println(*c) // [120 86 52 18] 按[4]uint8做内存解释

}

再次强调:unsafe 包的使用非常危险,它打破了 Go 的类型安全,可能导致难以追踪的错误和程序崩溃。只应在绝对必要且完全理解其后果的情况下使用(通常在与 C 库交互或进行底层性能优化时)。

深拷贝 vs 浅拷贝:复制的陷阱

在编码过程中,当我们复制一个对象时,会涉及到两种不同的复制方式:浅拷贝(Shallow Copy)和深拷贝(Deep Copy)。 这两种方式的主要区别在于它们如何处理对象内部包含的指针(或引用)类型字段。

浅拷贝只复制对象本身。如果对象内部包含指针,那么副本中的指针将与原始对象中的指针指向同一块内存地址。这意味着,如果通过副本修改了指针指向的数据,原始对象也会受到影响。

深拷贝则不同,它不仅复制对象本身,还会递归地复制对象内部所有指针指向的数据。深拷贝完成后,副本与原始对象是完全独立的,它们没有任何共享的内存。

我们来看一个示例:

package main

import "fmt"

type Address struct {

City string

}

type Person struct {

Name string

Age int

Address *Address // 指针类型字段

}

// DeepCopy 方法实现了 Person 类型的深拷贝

func (p Person) DeepCopy() Person {

newPerson := p // 先复制值类型字段

if p.Address != nil {

newAddress := *p.Address // 复制指针指向的Address对象

newPerson.Address = &newAddress //新对象指针指向新地址

}

return newPerson

}

func main() {

// 浅拷贝示例

p1 := Person{Name: "Alice", Age: 30, Address: &Address{City: "New York"}}

p2 := p1 // 浅拷贝

p2.Address.City = "Los Angeles"

fmt.Println(p1.Address.City) // 输出 "Los Angeles",p1也被修改了

// 深拷贝示例

p3 := Person{Name: "Bob", Age: 25, Address: &Address{City: "Chicago"}}

p4 := p3.DeepCopy() // 深拷贝

p4.Address.City = "Seattle"

fmt.Println(p3.Address.City) // 输出 "Chicago",p3未受影响

}

对于包含指针字段的类型,实现深拷贝和浅拷贝的方式有所不同。浅拷贝很简单,直接赋值即可。Go 会自动复制结构体中的所有字段,包括指针字段。但如前所述,这种复制只是指针值的复制,而不是指针指向的数据的复制。

要实现深拷贝,则需要手动编写代码或使用第三方库。 对于包含指针字段的结构体,一种常见的做法是定义一个 DeepCopy 方法,在该方法中创建新的指针,并复制指针指向的数据。

在这个例子中,Person 结构体包含一个 Address 类型的指针字段。针对该结构体类型变量的浅拷贝操作是直接赋值(p2 := p1),这样两个变量 p1 和 p2 中的指针类型字段 Address 指向同一个内存对象,当通过 p2 将 City 改为 “Los Angeles”,p1 中的 Adress.City 也会随之改变。

深拷贝则使用了自定义的 DeepCopy 方法,DeepCopy 首先复制了 Person 结构体中的值类型字段(Name 和 Age),然后检查 Address 指针是否为 nil。如果不为 nil,则创建一个新的 Address 对象,并复制原始 Address 对象的值,最后将新 Person 对象的 Address 字段指向这个新的 Address 对象。这样就实现了 Person 对象的深拷贝。

在 Go 语言中,深拷贝有其特定的应用场景。 由于 Go 中的赋值操作(包括函数参数传递)默认是浅拷贝,这在某些情况下可能会导致意料之外的副作用。

例如,当你希望修改一个对象的副本,但不希望影响原始对象时,或者当你需要将一个对象的状态保存为一个快照,以备后续恢复时,都需要用到深拷贝。另外,在并发编程中,为了避免多个 goroutine 之间的数据竞争,通常也需要对共享数据进行深拷贝。

不过即便如此,某些情况下,手工实现一个 DeepCopy 方法也是很难的,甚至是不可能的,比如当有循环引用或某些类型不支持拷贝(比如 sync.Mutex)的情况时。

小结

这一讲,我们从底层内存表示出发,重新审视了 Go 语言中看似基础却至关重要的“ 值”与“ 指针”。现在,我们来梳理一下核心要点。

-

值的本质:内存中的一段有界比特序列,其含义由类型决定。

-

Go 核心理念:一切皆值。所有类型实例(包括 map、channel 等)在内存中都以值的形式存在。map/channel 变量的值是指向运行时内部数据结构的指针。

-

指针类型:存储其他值内存地址的特殊值。通过 & 获取地址,通过解引用访问/修改指向的值。

-

唯一传递方式:Go 只有值传递(按位拷贝)。

-

不同传递效果源于拷贝内容

a. 拷贝基本类型/无指针 struct -> 纯值传递效果(隔离)。

b. 拷贝指针值 -> 指针传递效果(共享修改)。

c. 拷贝含指针的结构(如 slice header) -> 部分共享效果(底层数据共享,结构本身隔离)。

-

实用考量

a. 理解零值保证了变量的确定性。

b. 掌握值比较规则,知道哪些类型可比,哪些不可比。

c. 传值 vs 传指针需权衡数据大小(性能)、修改需求(语义)和拷贝语义。

d. 深拷贝 vs 浅拷贝在处理包含指针的对象复制时非常关键。

深入理解值和指针,以及 Go 唯一的值传递机制,是编写出高效、正确、符合 Go 语言习惯代码的关键一步。它能帮助你避免常见的内存共享错误,做出更优的性能决策,并为你理解后续更复杂的概念(如方法接收者、接口实现、并发内存模型)打下坚实的基础。

思考题

结合本节课对值传递三种效果的讨论(纯值效果、指针效果、切片效果),请你动手编写一个 Go 程序示例,要求:

- 定义一个函数

modifyValues。 - 在这个函数内部,尝试修改传入的三个不同类型的参数:一个 int,一个 *int(指向一个int),一个 []int(切片)。

- 在

main函数中,调用modifyValues,并打印调用前后这三个原始变量的值(对于指针,打印指向的值;对于切片,打印切片内容、长度、容量),清晰地展示出这三种传递效果的不同。

欢迎将你的代码示例和观察结果分享在留言区!我是 Tony Bai,我们下节课见。

数组与切片:性能、灵活与陷阱,如何做出最佳选择?

你好,我是 Tony Bai。

上一讲我们深入学习了值与指针以及 Go 的值传递机制。今天,我们要聚焦 Go 语言中使用频率最高的两种复合类型: 数组(array)和切片(slice)。相信你对它们已经不陌生了。

数组是由相同类型元素组成的复合类型,Go 会为每个数组类型实例分配一块连续的内存。一旦创建,数组的元素个数和大小就固定不变。

而切片可以理解为动态数组,它的元素类型也是相同的,但其底层数组(underlying array)的大小会随着调用 append 函数添加元素而自动扩展。所有这些操作都由 Go 运行时自动完成,程序员无需显式干预。

在日常 Go 开发中,切片以其无与伦比的灵活性,在很多场景下取代了数组,成为处理同构(相同类型)元素集合的首选。

但切片的这种灵活性并非没有“代价”。你是否思考过:

- 数组的“死板”背后,隐藏着哪些性能优势?

- 切片的“灵活”背后,又有哪些潜在的性能开销和不易察觉的“陷阱”?

- 比如,

nil切片和空切片有何不同?append导致底层数组“分家”是怎么回事?for range遍历切片时有什么坑? - 在追求性能和追求灵活性之间,我们应该如何明智地选择使用数组还是切片?

这节课,我们就来深入剖析数组和切片的核心差异、性能权衡以及常见的陷阱。掌握这些,你才能真正驾驭好数组和切片这两个Go 语言的利器。

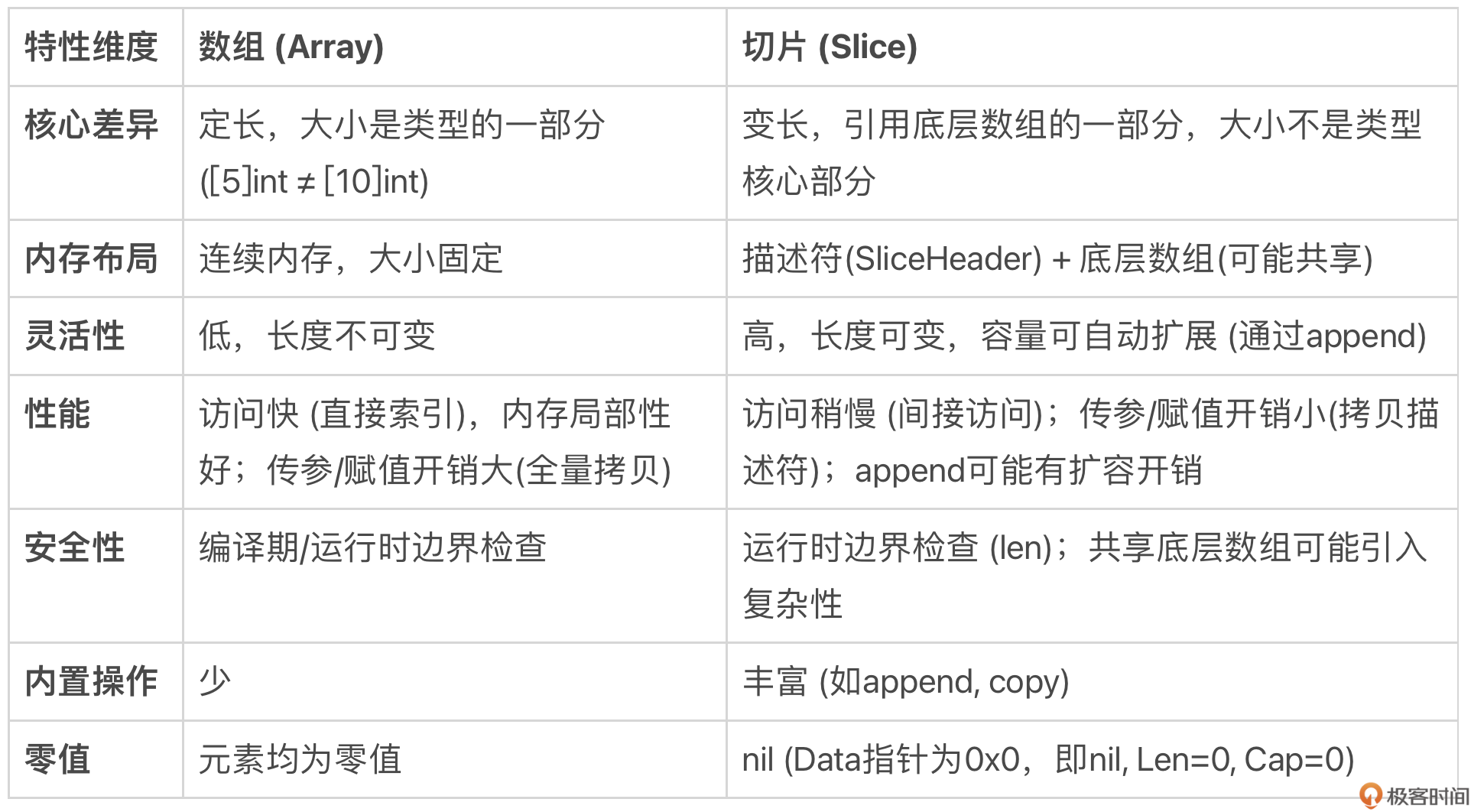

数组 vs 切片:固定与动态的权衡分析

我们可以先从几个维度来对比数组和切片的优劣:

总结来说,核心的权衡在于:

- 数组:胜在性能稳定、内存布局简单、类型强约束带固定长度;劣在不够灵活、传参拷贝代价高。适用于大小固定且对性能有极致要求的场景,或作为其他数据结构的底层存储。

- 切片:胜在灵活、方便、传参代价低;劣在性能有波动(扩容)、内存管理相对复杂、存在一些使用陷阱。是 Go 中处理序列数据的首选和惯用方式。

在同构元素数据结构上,Go 语言的设计者更倾向于灵活性和实用性,因此切片的使用远比数组广泛。但理解切片灵活性的“代价”,是避免踩坑、写出高质量代码的关键。

切片的灵活性:背后的性能“代价”与常见陷阱

切片的易用性背后,隐藏着一些需要我们深入理解的机制和潜在问题。

nil 切片 vs 空切片

有过 Go 语言开发经验的小伙伴估计大多都知道空切片(empty slice)与 nil 切片(nil slice)比较的梗,这也是 Go 面试中的一道高频题:

var sl1 = []int{}

var sl2 []int

在上面代码中,sl1 是空切片,而 sl2 是 nil 切片。要理解这两种切片的区别,离不开运行时的切片表示。我们知道切片在运行时由三个字段构成,标准库 reflect 包中有切片在运行时中表示的具体定义:

// $GOROOT/src/reflect/value.go

type SliceHeader struct {

Data uintptr

Len int

Cap int

}

基于这个定义我们来理解空切片和 nil 切片就容易多了。我们用一段代码来看看这两种切片的差别:

package main

import (

"fmt"

"reflect"

"unsafe"

)

func main() {

var sl1 = []int{}

ph1 := (*reflect.SliceHeader)(unsafe.Pointer(&sl1))

fmt.Printf("empty slice's header is %#v\n", *ph1)

var sl2 []int

ph2 := (*reflect.SliceHeader)(unsafe.Pointer(&sl2))

fmt.Printf("nil slice's header is %#v\n", *ph2)

}

在这段代码中,我们通过 unsafe 包以及 reflect.SliceHeader 输出了空切片与 nil 切片在内存中的表示,即 SliceHeader 各个字段的值。我们运行一下上述代码(使用 -gcflags ‘-l -N’ 可关闭 Go 编译器的优化):

$go run -gcflags '-l -N' dumpslice.go

empty slice's header is reflect.SliceHeader{Data:0xc000092eb0, Len:0, Cap:0}

nil slice's header is reflect.SliceHeader{Data:0x0, Len:0, Cap:0}

通过输出结果,我们看到 nil 切片在运行时表示的三个字段值都是 0;而空切片的 len、cap 值为 0,但 data 值不为 0。如果将 sl1 和 sl2 分别与 nil 进行等值比较,会得到如下与我们预期一致的结果:

println(sl1 == nil) // false

println(sl2 == nil) // true

那么 data 值不为 0,是否意味着 Go 已经给空切片分配了额外的内存空间了呢?并没有!

data 的值实际上是一个栈上的内存单元的地址,Go 编译器并没有在堆上额外分配新的内存空间作为切片 sl 的底层数组。如果你输出上面代码对应的汇编代码,你会发现在汇编代码中并没有调用 growslice 或 newobject 等在堆上分配底层数组的调用。

接下来,我们再来看看切片的自动扩容特性在底层内存管理上给我们带来的理解复杂性。

关于自动扩容

这里要提醒你: 只有通过 Go 预定义的 append 函数向切片追加元素的过程中,才会触发切片实例的自动扩容。如果仅仅是对切片进行下标操作,比如下面使用下标对切片元素的读取和赋值是不会触发自动扩容的。如果下标越界,即超出切片的长度,那么还会引发运行时的 panic。

var sl = make([]int, 8)

sl[0] = 10

... ...

sl[7] = 17

println(sl[3])

sl[8] = 18 // panic: runtime error: index out of range [8] with length 8

针对上面示例中的 sl,如果还要向其中存入数据,可以通过 append 函数,就像这样:

println(cap(sl)) // 8

sl = append(sl, 18)

println(sl[8]) // 18

println(cap(sl)) // 16

我们看到通过 append 向切片变量 sl 追加元素,append 前后的切片容量发生了自动扩充,由 append 前的 8 增加到 16,即一旦切片容量满(len==cap),append 就会重新分配一块更大的底层数组,然后将当前切片元素 copy 到新底层数组中。

通常在切片容量较小的情况下,append 都会按 2 倍切片的容量进行扩容,就像这个例子中的从 8 到 16。对于切片容量较大的情况(Go 1.17 及以前版本,容量超过 1024 归于此类,而从 Go 1.18 开始,这一上限值改为 256 了),那么 Go 便不会按 2 倍容量扩容。

下面是 Go 1.18 版本中的切片扩容算法:

// $GOROOT/src/runtime/slice.go

func growslice(et *_type, old slice, cap int) slice {

... ...

newcap := old.cap

doublecap := newcap + newcap

if cap > doublecap {

newcap = cap

} else {

const threshold = 256

if old.cap < threshold {

newcap = doublecap

} else {

// Check 0 < newcap to detect overflow

// and prevent an infinite loop.

for 0 < newcap && newcap < cap {

// Transition from growing 2x for small slices

// to growing 1.25x for large slices. This formula

// gives a smooth-ish transition between the two.

newcap += (newcap + 3*threshold) / 4

}

// Set newcap to the requested cap when

// the newcap calculation overflowed.

if newcap <= 0 {

newcap = cap

}

}

}

... ...

}

和 Go 1.17 及以前版本相比,Go 1.18 在处理超过门限值(上面代码中的 threshold)的切片容量扩容前后的变化不会那么剧烈,而是使变化更为平滑一些。不过这个扩容算法也不是一成不变的,也许将来的某个版本 Go 中会有更为科学合理的切片扩容算法。

不过,自动扩容会带来一个“副作用”,进而导致代码中的潜在错误,那就是切片扩容后的新老切片彻底分家。这是什么意思呢?我们来看下面的示例:

package main

import "fmt"

func F(sl []int, elems ...int) []int {

sl = append(sl, elems...)

sl[0] = 11

return sl

}

func main() {

var sl = []int{1, 2}

fmt.Printf("origin sl = %v, addr of first element: %p\n", sl, &sl[0])

sl1 := F(sl, 3, 4, 5, 6)

fmt.Printf("after invoke F, sl = %v, addr of first element: %p\n", sl, &sl[0])

fmt.Printf("after invoke F, sl1 = %v, addr of first element: %p\n", sl1, &sl1[0])

}

在这个示例中,我们有一个整型切片 sl,其初始元素值有两个,1 和 2。我们将其传给函数 F,该函数在向切片追加元素后,会将第一个元素的值更新为 11。对这个示例,很多人的预期结果是原 sl 的第一个元素值也会被改为 11,但事实真的是这样吗?

我们来看看这段示例程序的执行结果:

origin sl = [1 2], addr of first element: 0xc00018a010

after invoke F, sl = [1 2], addr of first element: 0xc00018a010

after invoke F, sl1 = [11 2 3 4 5 6], addr of first element: 0xc0001a2000

我们看到,由于 F 函数中 append 元素数量超出了原切片的容量,Go 对切片进行了扩容,分配了新的底层数组,这样扩容前后的切片的底层数组就“分家”了,后续对切片第一个元素的更新,影响的仅仅是分家后的新切片及其底层数组,原切片中第一个元素值并未受到影响。

这个“分家”现象直接影响了我们在函数中处理切片的方式,即当切片作为函数参数时,我们该如何考量这个函数的设计。

函数设计

我们知道切片算是“半个”零值可用的类型,为什么这么说呢?当我们声明一个空切片时,我们不能直接对其做下标操作,比如:

var sl []int

sl[0] = 5 // 错误:引发panic

但是我们可以通过 Go 内置的 append 函数对其进行追加操作,即便 sl 目前的值为 nil:

var sl []int

sl = append(sl, 5) // ok

细心的小伙伴到这里可能会问: 为什么 append 函数要通过返回值返回切片结果呢?再泛化一点:当你在函数设计环节遇到要传入传出切片类型时,你会如何设计函数的参数与返回值呢?下面我们就来探讨一下。

我们在 $GOROOT/src/builtin/builtin.go 中找到了 append 预置函数的原型:

func append(slice []Type, elems ...Type) []Type

显然参照 append 函数的设计, 通过参数传入切片,通过返回值传出更新过的切片肯定是一个正确的方案,比如下面的第一版 MyAppend 函数:

func myAppend1(sl []int, elems ...int) []int {

return append(sl, elems...)

}

func main() {

var in = []int{1, 2, 3}

fmt.Println("in slice:", in) // 输出:in slice: [1 2 3]

fmt.Println("out slice:", myAppend1(in, 4, 5, 6)) // 输出:out slice: [1 2 3 4 5 6]

}

到这里,有些小伙伴会提出:切片不是动态数组吗?是不是可以既作为输入参数,又兼作输出参数呢?我理解提出这个问题的小伙伴们希望设计出像下面这样的函数原型:

func myAppend2(sl []int, elems ...int)

这里 sl 作为输入参数传入 myAppend2,然后在 myAppend2 对其进行 update 后,myAppend2 函数的调用者将得到更新后的 sl。但实际情况是这样的吗?我们来看一下:

unc myAppend2(sl []int, elems ...int) {

sl = append(sl, elems...)

}

func main() {

var arr = [6]{1,2,3}

var inOut = arr[:3:6] // 构建一个len=3,cap=6的切片

fmt.Println("in slice:", inOut)

myAppend2(inOut, 4, 5, 6)

fmt.Println("out slice:", inOut)

}

运行这段程序,我们得到如下结果:

in slice: [1 2 3]

out slice: [1 2 3]

我们看到 myAppend2 并未如我们预期的那样工作,传入的切片并未在 myAppend2 中得到预期的更新,这是为什么呢?首先这是与切片在运行时的表示有关的,在前面我们已经提过这一点了,切片在运行时由三个字段构成(见上面的 SliceHeader 结构体)。

此外,Go 函数采用“值拷贝”的参数传递方式,这意味着 myAppend2 传递的切片 sl 实质上仅仅传递的是切片“描述符” —— SliceHeader。myAppend2 函数体内改变的是形参 sl 的各个字段的值,但 myAppend2 的实参并未受到任何影响,即执行完 myAppend2 后,inOut 的 len 和 cap 依旧保持不变。

而其底层数组是否改变了呢?在这个例子中肯定是“改变”了,但改变的是 inOut 长度(len)范围之外,cap 之内的元素,通过对 inOut 的常规访问是无法获取到这些元素的。

那么我们该如何让 slice 作为 in/out 参数呢?答案是使用指向切片的指针,我们来看下面的例子:

func myAppend3(sl *[]int, elems ...int) {

(*sl) = append(*sl, elems...)

}

func main() {

var inOut = []int{1, 2, 3}

fmt.Println("in slice:", inOut) // in slice: [1 2 3]

myAppend3(&inOut, 4, 5, 6)

fmt.Println("out slice:", inOut) // out slice: [1 2 3 4 5 6]

}

我们看到 myAppend3 函数使用 *[]int 类型的形参,的确解决了切片参数作为输入输出参数的问题:myAppend3 对切片的更改操作都反映到 inOut 变量所代表的这个 slice 上了,即便在 myAppend3 内切片进行了动态扩容,inOut 也能“捕捉”到这点。

不过使用切片指针类型作为函数参数并非 Go 惯用法,我在 Go 标准库中查找了一下,使用指向切片的指针作为参数的函数“少得可怜”:

$grep "*\[\]" */*go|grep func

grep: cmd/cgo: Is a directory

grep: cmd/go: Is a directory

grep: runtime/cgo: Is a directory

log/log.go:func itoa(buf *[]byte, i int, wid int) {

log/log.go:func (l *Logger) formatHeader(buf *[]byte, t time.Time, file string, line int) {

regexp/onepass.go:func mergeRuneSets(leftRunes, rightRunes *[]rune, leftPC, rightPC uint32) ([]rune, []uint32) {

regexp/onepass.go: extend := func(newLow *int, newArray *[]rune, pc uint32) bool {

runtime/mstats.go:func readGCStats(pauses *[]uint64) {

runtime/mstats.go:func readGCStats_m(pauses *[]uint64) {

runtime/proc.go:func saveAncestors(callergp *g) *[]ancestorInfo {

综上,当我们在函数设计中遇到切片类型数据时,如果要对切片做更新操作,优先还是要参考 append 函数的设计方案,即通过切片作为输入参数和返回值的方式实现该操作逻辑,必要时也可以使用指向切片的指针的方式传递切片,就像 myAppend3 那样。

预分配容量

既然自动扩容有性能开销(内存分配 + 数据拷贝),那么如果我们在创建切片时就能预估到它最终大概需要多大容量,就可以提前分配,从而避免或减少后续 append 触发的扩容次数。

我们可以使用带容量参数的 make 函数:

sl := make([]T, length, capacity)

例如,如果你知道一个切片最终会存储约 1000 个元素:

// 方式一:无预分配容量

var sl1 []int

for i := 0; i < 1000; i++ {

sl1 = append(sl1, i) // 可能触发多次扩容

}

// 方式二:预分配容量

sl2 := make([]int, 0, 1000) // 长度为0,容量为1000

for i := 0; i < 1000; i++ {

sl2 = append(sl2, i) // 基本不会触发扩容 (除非1000次append中途有其他操作改变了容量)

}

我们看一下这两种方式的性能基准测试情况:

package main

import (

"testing"

)

func BenchmarkAppendWithoutCap(b *testing.B) {

for i := 0; i < b.N; i++ {

var sl []int

for j := 0; j < 1000; j++ {

sl = append(sl, j)

}

}

}

func BenchmarkAppendWithCap(b *testing.B) {

for i := 0; i < b.N; i++ {

sl := make([]int, 0, 1000)

for j := 0; j < 1000; j++ {

sl = append(sl, j)

}

}

}

在这个基准测试中,我们分别测试了使用 cap 创建的切片和未使用 cap 创建的切片的追加元素操作的开销,测试结果如下:

$go test -bench . benchmark_test.go

cpu: Intel(R) Core(TM) i5-8257U CPU @ 1.40GHz

BenchmarkAppendWithoutCap-8 355918 3378 ns/op

BenchmarkAppendWithCap-8 2456326 485.1 ns/op

PASS

结果显示, 预分配容量的方式性能提升显著(近 7 倍!)。

由此可以得出使用预分配的两个场景。

- 当你能比较准确地估计出切片所需的最大容量时。

- 在性能敏感的代码路径中,频繁的小切片

append操作可能成为瓶颈。

警惕内存泄露

切片支持在使用 append 追加元素时进行自动扩容, 但却不会自动缩容。也就是说在切片容量初始分配较大,或者是在扩容为大内存之后依然长期持有,即便不再使用这些扩容后的内存,这些内存也不会被释放,而会长期占用着内存资源。

下面是一个模拟此种状况的代码示例:

package main

import (

"fmt"

"math/rand"

"runtime"

"sync"

"time"

)

const (

poolSize = 10

maxSliceSize = 1000000

duration = 30 * time.Second

)

type SlicePool struct {

pool chan []int

}

func NewSlicePool(size int) *SlicePool {

return &SlicePool{

pool: make(chan []int, size),

}

}

func (p *SlicePool) Get() []int {

select {

case slice := <-p.pool:

return slice[:0] // 重置切片长度,但保留容量

default:

return make([]int, 0, 10) // 如果池空,创建新切片

}

}

func (p *SlicePool) Put(slice []int) {

select {

case p.pool <- slice:

default:

// 如果池满,丢弃

}

}

func smallWorker(id int, pool *SlicePool, wg *sync.WaitGroup, done <-chan struct{}) {

defer wg.Done()

for {

select {

case <-done:

return

default:

slice := pool.Get()

// 只使用前10个元素

for i := 0; i < 10; i++ {

if i < len(slice) {

slice[i] = i

} else {

slice = append(slice, i)

}

}

// 模拟使用切片

time.Sleep(100 * time.Millisecond)

pool.Put(slice)

}

}

}

func largeWorker(id int, pool *SlicePool, wg *sync.WaitGroup, done <-chan struct{}) {

defer wg.Done()

for {

select {

case <-done:

return

default:

slice := pool.Get()

size := rand.Intn(maxSliceSize)

for i := 0; i < size; i++ {

slice = append(slice, i)

}

// 模拟使用切片

time.Sleep(1 * time.Second)

pool.Put(slice)

}

}

}

func main() {

pool := NewSlicePool(poolSize)

var wg sync.WaitGroup

done := make(chan struct{})

// 启动小型worker

for i := 0; i < 8; i++ {

wg.Add(1)

go smallWorker(i, pool, &wg, done)

}

// 启动大型worker

for i := 8; i < 10; i++ {

wg.Add(1)

go largeWorker(i, pool, &wg, done)

}

// 定时打印内存使用情况

ticker := time.NewTicker(1 * time.Second)

timeout := time.After(duration)

for {

select {

case <-ticker.C:

printMemUsage("当前内存使用")

case <-timeout:

close(done) // 通知所有worker停止

ticker.Stop()

wg.Wait() // 等待所有worker结束

printMemUsage("结束时内存使用")

return

}

}

}

func printMemUsage(msg string) {

var m runtime.MemStats

runtime.ReadMemStats(&m)

fmt.Printf("%s - 使用的内存: %v MB\n", msg, m.Alloc/1024/1024)

}

在这个示例程序中,我们创建了一个切片池,池的大小为 10。我们启动了两类 worker goroutine,一类 worker goroutine 不断从切片池中取出切片,但仅使用其中很少的空间,然后再放回池子中;而另外一类 worker goroutine 则每秒从池中获取切片,随机扩展切片大小(最大为 1000000 个元素),然后将切片归还到池中。主 goroutine 每秒打印一次内存使用情况,持续 30 秒后程序结束。

我们运行这个程序,可以看到类似如下的输出结果:

$go run large_mem_hold.go

当前内存使用 - 使用的内存: 9 MB

当前内存使用 - 使用的内存: 14 MB

当前内存使用 - 使用的内存: 14 MB

当前内存使用 - 使用的内存: 14 MB

当前内存使用 - 使用的内存: 14 MB

当前内存使用 - 使用的内存: 22 MB

... ...

当前内存使用 - 使用的内存: 22 MB

当前内存使用 - 使用的内存: 22 MB

结束时内存使用 - 使用的内存: 22 MB

我们会看到内存使用量在开始时快速增长,然后保持在一个较高的水平,即使大部分时间 goroutine 可能只使用了切片池很小的一部分容量。这是由于切片扩容后,底层数组仍然占用着之前扩容的大量内存,这部分内存无法被释放,因为切片仍在池中被重复使用,导致程序内存占用居高不下。

如何缓解?

- 按需创建:如果可能,尽量在需要时创建大小合适的切片,而不是复用可能过大的切片。

- 显式复制:如果只需要大切片中的一小部分数据,并且希望释放大数组内存,可以显式地释放原切片,并创建一个新切片,并将所需数据拷贝过去。

largeSlice := getLargeSliceFromPool()

var smallSlice []int

tooLarge := (cap(largeSlice) >= 1000)

if tooLarge {

// 创建新切片并拷贝,不再引用大数组

largeSlice = nil // 释放大切片

smallSlice = make([]int, len(yourData))

} else {

smallSlice := largeSlice[:len(yourData)]

}

copy(smallSlice, neededData)

useSmallSlice(smallSlice) // 使用独立的小切片

像上面这样的由于切片在运行时的独特表示以及自动扩容特性所带来的潜在的问题还有一些,接下来我们再来看一个,那就是当 for range 和切片一起使用时可能会出现的问题。

for range 陷阱

切片与 for range 一起使用的方法我们再熟悉不过了,这里不再回顾 for range 的语法,而是直接给出一个 for range 与切片联合使用的代码示例,你先猜猜最终输出的 cnt 值是多少呢?

package main

import "fmt"

func main() {

a := make([]int, 5, 8)

cnt := 0

for i := range a {

cnt++

if i == 1 {

a = append(a, 6, 7, 8)

}

}

fmt.Println("cnt=", cnt)

}

有人说是 8!这些小伙伴的理由估计是这样的:在 i 为 1 时,代码又向切片 a 附加了 3 个新元素,使得切片的长度变为了 8。于是 for range 迭代 8 次,cnt 计数到 8。

下面我们实际运行一下这段代码,看看输出的结果究竟是多少:

cnt= 5

我们看到最终 cnt 的值为 5。为什么会这样呢?这与切片在运行时的表示以及 for range 后面的表达式的含义不无关系!

当我们使用 for range 去迭代切片变量 a 时,实际上 for range 后面的 a 是切片变量 a 的副本(以下以 a’ 代替),就像将一个切片变量以参数的形式传给一个函数一样,这是一个值拷贝的过程。

在 for range 循环过程中,切片 a 的副本 a’ 始终未变更过,它的长度始终为 5,因此 for range 一共就迭代了 5 次,所以 cnt 为 5。而循环体中通过 append 追加的元素实际上是追加到了原切片 a 上了。即便 a 和 a’ 仍然共享底层数组,但由于 a’ 的长度是 5,for range 就只能迭代 5 次。

数组与切片相互转换

最后,我们再来看看数组和切片间的转换。

虽然数组和切片是 Go 语言中不同的类型,但在实际开发中,我们经常需要在它们之间进行转换。理解如何高效地进行转换,避免不必要的内存分配,对于编写高性能的 Go 代码至关重要。

我们先来看看数组转切片。

将数组转换为切片非常简单,Go 语言提供了切片操作符 [:] 来实现这一目的,并且这种转换方式是 零拷贝 的。也就是说,它不会创建新的底层数组,而是直接引用原数组的底层存储。我们看下面示例:

package main

import (

"fmt"

"reflect"

"unsafe"

)

func main() {

arr := [5]int{1, 2, 3, 4, 5}

// 数组转切片

slice := arr[:]

// 验证切片与数组共享底层存储

fmt.Printf("Array address: %p\n", &arr[0])

fmt.Printf("Slice address: %p\n", &slice[0])

// 修改切片元素,观察数组是否受影响

slice[0] = 10

fmt.Println("Array after slice modification:", arr)

//获取数组和切片底层信息

ph1 := (*reflect.SliceHeader)(unsafe.Pointer(&slice))

fmt.Printf("slice's header is %#v\n", *ph1)

ph2 := (*[5]int)(unsafe.Pointer(ph1.Data))

fmt.Printf("slice's underlying array is %#v\n", *ph2)

}

运行这段程序,我们得到如下结果:

Array address: 0xc0000201b0

Slice address: 0xc0000201b0

Array after slice modification: [10 2 3 4 5]

slice's header is reflect.SliceHeader{Data:0xc0000201b0, Len:5, Cap:5}

slice's underlying array is [5]int{10, 2, 3, 4, 5}

从输出结果可以看出,切片 slice 和数组 arr 共享相同的底层存储地址。修改切片的元素也会影响到数组的元素。这种零拷贝的转换方式非常高效。

接下来,我们再来看看切片转数组。

与数组转切片不同的是,Go 并没有提供直接从切片创建数组的语法糖,因为切片是动态的,而数组是固定大小的。但在某些情况下,我们可能希望以数组的方式来操作切片的底层数据。但在 Go 1.17 之前,我们没有办法直接将切片转为数组,只能通过 unsafe 方式得到切片的底层数组的地址。

Go 1.17 增加了切片转数组指针的语法,Go 1.20 版本又增加了将切片转为数组的语法,我们通过下面示例来看一下这两种转换的使用:

package main

import (

"fmt"

"unsafe"

)

func main() {

// 原始切片

slice := []int{1, 2, 3, 4, 5}

fmt.Println("Original slice:", slice)

// 方法1: 标准语法 - Go 1.17+

arrayPtr := (*[5]int)(slice)

fmt.Println("Array pointer (standard):", *arrayPtr)

// 方法2: 使用unsafe的等价形式,不推荐,这里只是为了演示

unsafeArrayPtr := (*[5]int)(unsafe.Pointer(&slice[0]))

fmt.Println("Array pointer (unsafe):", *unsafeArrayPtr)

// 验证两者指向相同的内存

fmt.Printf("Standard array pointer: %p\n", arrayPtr)

fmt.Printf("Unsafe array pointer: %p\n", unsafeArrayPtr)

// 修改通过指针获取的数组,验证它影响原切片

(*arrayPtr)[2] = 30

fmt.Println("Slice after modifying through array pointer:", slice)

// 方法1: 标准语法 - Go 1.20+

slice[2] = 3 // 恢复原值

array := [5]int(slice)

fmt.Println("Array (standard):", array)

// 方法2: 使用unsafe的等价形式

// 另一种unsafe方式(不推荐,这只是为了演示)

unsafeArray := *(*[5]int)(unsafe.Pointer(&slice[0]))

fmt.Println("Array (unsafe deref):", unsafeArray)

// 验证标准转换创建了新的副本

array[2] = 300

fmt.Println("Original slice after modifying array:", slice)

fmt.Println("Modified array:", array)

}

运行这段程序,我们得到如下结果:

Original slice: [1 2 3 4 5]

Array pointer (standard): [1 2 3 4 5]

Array pointer (unsafe): [1 2 3 4 5]

Standard array pointer: 0xc00012e000

Unsafe array pointer: 0xc00012e000

Slice after modifying through array pointer: [1 2 30 4 5]

Array (standard): [1 2 3 4 5]

Array (unsafe deref): [1 2 3 4 5]

Original slice after modifying array: [1 2 3 4 5]

Modified array: [1 2 300 4 5]

从结果我们可以看到,通过转换后的数组指针,我们可以获得切片的底层数组的访问,并且对数组指针的修改也会影响到原切片。而通过 Go 1.20 的切片转数组语法,则是创建了一个新数组,并将切片的数据复制到了新数组中。因此,对新数组的修改不会影响到原来的切片。

Go 1.17 和 Go 1.20 提供了从切片到数组的更安全、更便捷的转换方式,这些方式避免了通过 unsafe 包直接操作指针,降低了出错的风险。同时 Go 1.17 的切片转数组是零拷贝的,非常高效。不过我们也要注意: 如果切片的长度小于数组的长度,会引发运行时 panic。

小结

在本讲中,我们深入对比了 Go 语言的数组和切片,探讨了它们在性能与灵活性上的核心权衡,并重点揭示了使用切片时可能遇到的性能“代价”与常见“陷阱”。

-

核心权衡:数组提供性能稳定和内存可预测性,但缺乏灵活性;切片提供极高的灵活性和便捷性,但性能有波动且隐藏着更多复杂性。

-

切片的“代价”与陷阱

- nil vs 空切片:底层

Data指针不同,影响== nil判断和某些场景(如JSON)。 - 自动扩容:

append超出容量时触发,涉及内存分配和拷贝开销;可能导致新老切片底层数组 “分家”。 - 函数设计:修改切片(尤其长度/容量)的函数,应返回新切片,而非依赖副作用或使用不常用的

*[]T参数。 - 预分配容量:使用

make([]T, len, cap)能显著减少扩容开销,提升性能。 - 内存持有:切片不自动缩容,复用大切片可能导致内存浪费,需警惕。

for range行为:迭代开始时拷贝切片头,循环次数固定,循环体内修改切片长度不影响迭代次数。

- nil vs 空切片:底层

-

数组切片转换:数组转切片是零拷贝;切片转数组指针(1.17+)是零拷贝;切片转数组(1.20+)是拷贝。

如何做出最佳选择?

- 默认使用切片:对于大多数需要处理序列数据的场景,切片的灵活性和易用性使其成为首选。

- 性能敏感且大小固定?考虑数组:如果集合大小在编译期已知,且是性能瓶颈点,数组可能是更好的选择。

数组和切片是 Go 数据结构的基础。深刻理解它们的特性、权衡和陷阱,是写出高效、健壮、地道 Go 代码的必经之路。

思考题

假设你正在设计一个函数,需要接收一个 []byte 切片,对其内容进行某种转换(可能会改变元素值,但不会改变切片的长度),然后返回转换后的结果。

请问,这个函数签名最好设计成以下哪种形式?并说明理由。

func Transform(data []byte)(无返回值,直接修改传入的切片)func Transform(data []byte) []byte(传入切片,返回一个新的切片)func Transform(data *[]byte)(传入指向切片的指针)

欢迎在留言区分享你的选择和思考!我是 Tony Bai,我们下节课见。

字符串:不只是字节序列,揭秘rune、UTF-8与高效操作

你好,我是 Tony Bai。

在 Go 语言中,string 是我们几乎每天都要打交道的基本数据类型。但你是否真正理解它的“内心世界”?

Go 的字符串就像一首精妙的“二重奏”:有时,它表现为一串连续的字节(bytes),你可以对它进行索引、切片,就像操作字节数组一样;有时,它又展现为一串字符(characters),你可以用 for range 优雅地遍历其中的字符,无论它们占多少字节。

这种两面性是如何实现的呢?此外:

- 当我们处理包含中文、日文或其他非 ASCII 字符的文本时,如何确保正确性?

- Go 是如何在底层表示字符串和字符的?rune 类型到底是什么?

- UTF-8 编码在其中扮演了什么角色?

- string 和 []byte 之间频繁转换,性能开销如何?Go 编译器又为我们做了哪些“零拷贝”优化?

- 拼接大量字符串时,用原生连接操作符

+和用 strings.Builder 有多大差别?

如果你对这些问题还有模糊之处,那么这节课就是为你准备的。 不深入理解字符串的“二重奏”本质,就可能在处理多语言文本时踩坑,或者在性能敏感的场景写出低效的代码。

这节课我们将深入学习 Go 字符串的内部实现、字符编码,以及如何高效地操作字符串,理解它“二重奏”的精髓。掌握了这些,你就能更自信、更高效地驾驭 Go 字符串这个强大的工具。

字节与字符:字符串的“两面性”

Go 语言的字符串有一个核心特性: 不可变性(immutability)。一旦创建,字符串的内容就不能被修改。在这个前提下,我们可以从两个视角来看待它。

视角一:字符串是字节序列

从这个角度看,字符串(s)表现得像一个只读的字节数组。

- 可按字节索引

你可以通过下标访问特定位置的字节,下标范围是 0 到 len(s)-1。

s := "hello"

fmt.Printf("s[0]: %c (byte value: %d)\n", s[0], s[0]) // 输出 s[0]: h (byte value: 104)

注意:如果示例中的 s 包含多字节字符(比如中文字符),s[i] 访问的只是其中的一个字节。

- 可按字节切片

你可以使用切片操作 s[low:high] 来获取一个新的字符串,它引用了原始字符串底层字节序列的一部分。 这个操作非常高效,因为它们共享底层字节数组,不会创建新的数据副本。

s := "hello, world"

s1 := s[:5] // 获取 "hello"

s2 := s[7:] // 获取 "world"

fmt.Println(s1, s2) // 输出 hello world

视角二:字符串是字符序列

从这个角度看,字符串代表了一连串的 Unicode 字符。

- 可按字符迭代

使用 for range 循环可以遍历字符串中的每一个 Unicode 字符(rune),无论这个字符由多少个字节组成。

s := "你好,世界!" // 包含中文字符和全角标点

for index, char := range s {

// index 是字符起始字节的索引

// char 是 rune 类型的值 (Unicode 码点)

fmt.Printf("字节索引 %d, 字符 %c, Unicode码点 %U\n", index, char, char)

}

上面代码输出结果如下:

字节索引 0, 字符 你, Unicode码点 U+4F60

字节索引 3, 字符 好, Unicode码点 U+597D

字节索引 6, 字符 ,, Unicode码点 U+FF0C

字节索引 9, 字符 世, Unicode码点 U+4E16

字节索引 12, 字符 界, Unicode码点 U+754C

字节索引 15, 字符 !, Unicode码点 U+FF01

注意观察 index 的变化,它不是连续递增的,因为每个中文字符和全角标点占用了 3 个字节。

- 原生 Unicode 支持

Go 字符串在设计上天然支持 Unicode。你可以使用标准库 unicode/utf8 中的函数来精确计算字符数量、进行 utf8 编解码等,下面是一个示例:

import "unicode/utf8"

s := "Hello, 世界!你好,Go"

fmt.Println("字节长度 (len):", len(s)) // 输出 27 (bytes)

fmt.Println("字符数量 (RuneCountInString):", utf8.RuneCountInString(s)) // 输出 15 (runes/characters)

// 也可以通过转换为 []rune 来获取字符数量

fmt.Println("字符数量 ([]rune):", len([]rune(s))) // 输出 15

这两种视角看似不同,实则都源于 Go 字符串的底层表示和编码方式。要理解这种统一,我们需要先看看字符串在内存中到底长什么样,以及 rune 到底是什么。

rune 类型:Go 如何表示 Unicode 字符?

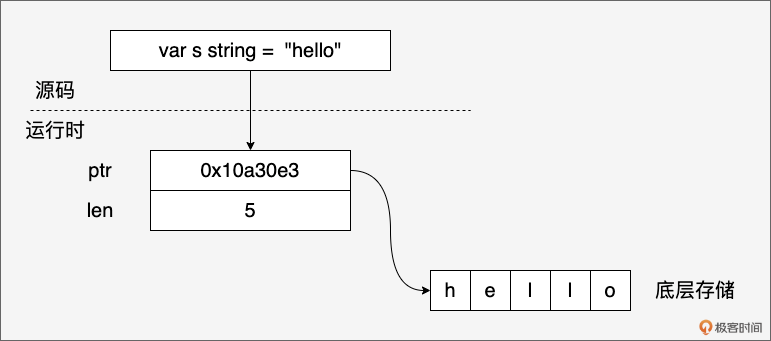

虽然我们在源码层面感觉字符串像字符序列或字节序列,但在 Go 的运行时,一个 string 变量实际上是一个简单的结构体,包含两个字段:

// $GOROOT/src/runtime/string.go

type stringStruct struct {

str unsafe.Pointer

len int

}

其中:

- str 指针指向一块内存,这块内存存储了字符串的字节序列。

- len 字段表示字符串的字节长度,而不是字符数量。

这种设计的关键在于: 字符串是不可变的字节序列。当我们创建一个字符串时,Go 会分配一块内存来存储字符串的字节数据,并将 ptr 指向这块内存的起始地址。由于字符串不可变,多个字符串变量可以共享同一个底层字节数组,从而节省内存空间。例如:

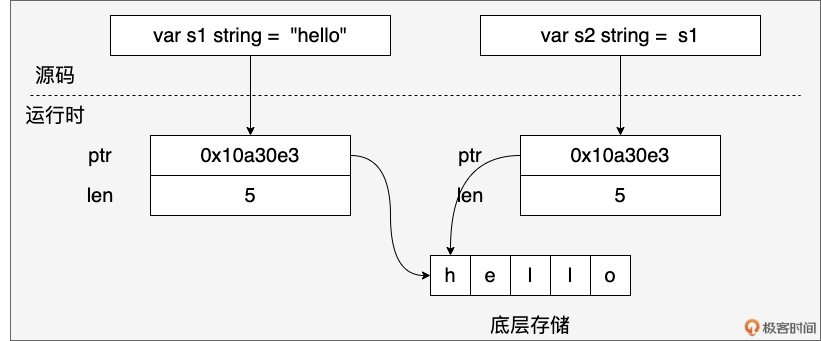

s1 := "hello"

s2 := s1

s1 和 s2 会共享同一个底层字节数组,如下图所示:

如果基于 s1 获取子字符串 s3,s3 也与 s1 共享同一块底层内存。

s3 := s1[1:4] // s3 ("ell") 也指向 s1 的部分内存

字符串底层是一个字节数组,那字符在哪里呢?接下来,我们就来看看 Go 语言是如何表示一个字符的。

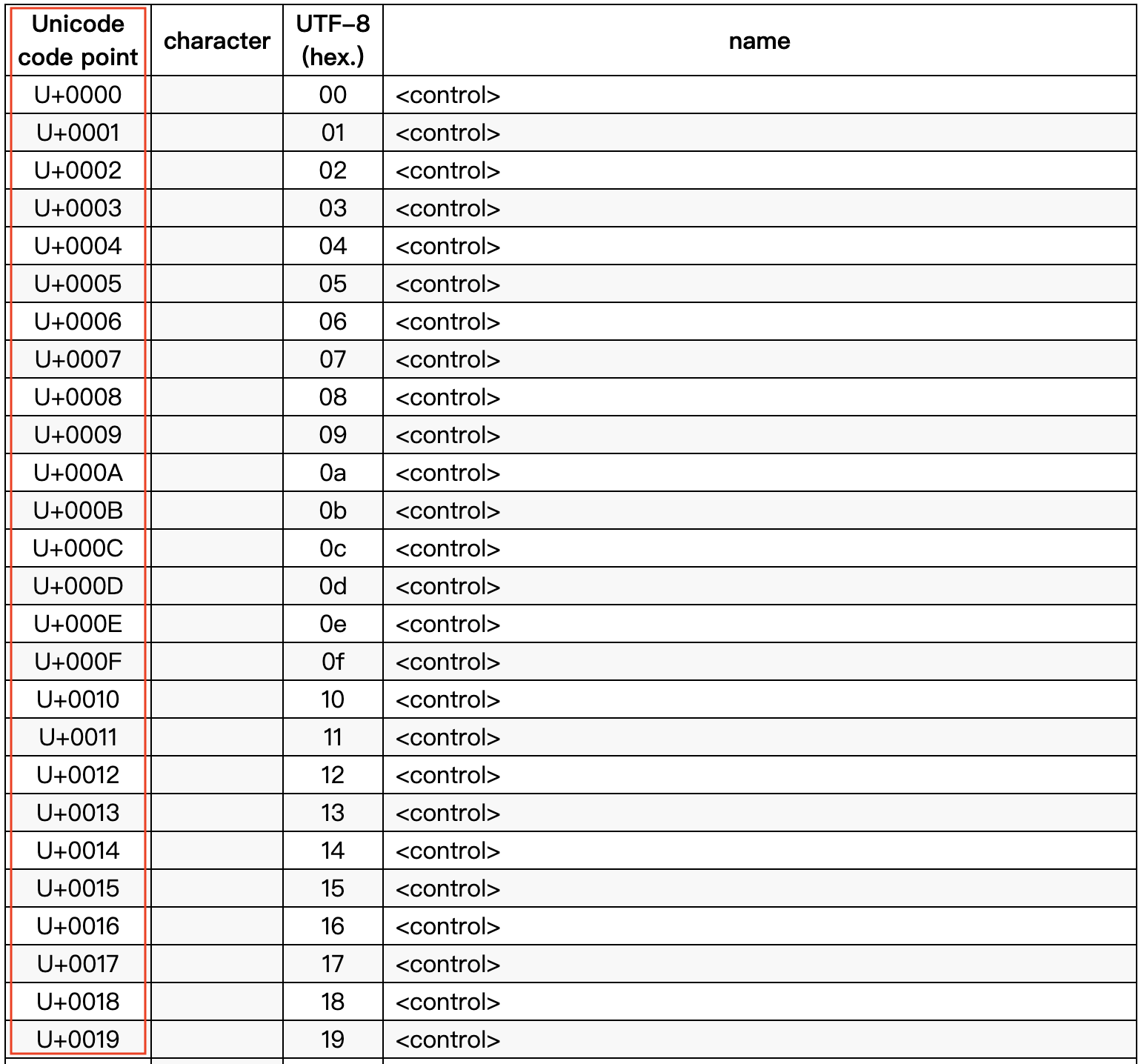

Go 语言使用的是 Unicode 字符,无论是英文字母、数字、中文汉字或是其他符号等,在 Go 中都是一个 Unicode 字符,比如:

c1 := 'a'

c2 := '世'

c3 := '☺'

在 Go 源码层面,每个 Unicode 字符是由一个 rune 类型表示的,也就是说上面代码中的 c1、c2 和 c3 都是 rune 类型的变量。在 Go 中,rune 类型本质是一个 int32 类型,在 $GOROOT/src/go/builtin/builtin.go 中,你可以看到下面代码:

// $GOROOT/src/builtin/builtin.go

// rune is an alias for int32 and is equivalent to int32 in all ways. It is

// used, by convention, to distinguish character values from integer values.

type rune = int32

我们看到 rune 类型是 int32 类型的一个别名(alias),rune 类型变量(比如 c1)中存储的值是一个 Unicode 码点(code point)。

码点就是 Unicode 字符在 Unicode 字符表中的唯一序号,序号是一个数字,如下图:

我们可以通过将字符串转换为 []rune 的方式,来获取其包含的所有字符的码点序列:

import "encoding/hex"

s := "中国人"

runes := []rune(s) // 转换为 rune 切片

for i, r := range runes {

// %c 打印字符,%U 打印 Unicode 码点表示 (U+XXXX)

fmt.Printf("Index %d: Char '%c', Rune %d, Code Point %U\n", i, r, r, r)

}

fmt.Println(hex.Dump([]byte(s)))

输出:

Index 0: Char '中', Rune 20013, Code Point U+4E2D

Index 1: Char '国', Rune 22269, Code Point U+56FD

Index 2: Char '人', Rune 20154, Code Point U+4EBA

00000000 e4 b8 ad e5 9b bd e4 ba ba |.........|

现在问题来了:我们看到字符的码点(如 20013)和字符串底层存储的字节(如上面的 e4 b8 ad …)并不一样。

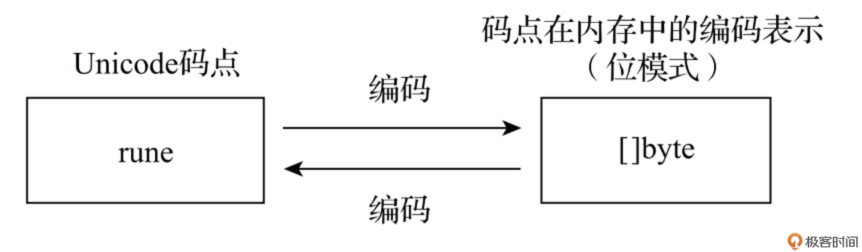

这说明, Go 字符串并没有直接存储码点,而是将码点进行了编码(encoding),然后存储编码后的字节序列。Go 选择的编码方式,正是大名鼎鼎的 UTF-8。

接下来,我们就来看看这种使用最为广泛的 Unicode 字符编码方式。

UTF-8 编码:字符串的底层存储奥秘

Unicode 字符编码就是将抽象的 Unicode 码点(一个整数)转换为用于存储或传输的具体字节序列的过程。反过来,将字节序列转换回码点的过程称为解码(decoding)。

下图展示了 Unicode 字符从抽象的码点(code point)到具体的内存表示(字节序列)之间的转换过程。

Unicode 字符有很多种编码方案,比如:UTF-8、UTF-16、UTF-32 等,其中 UTF-8 编码方案是应用最为广泛的一种,Go 默认使用 UTF-8 编码来存储 Unicode 字符。

上面示例中输出的 e4 b8 ad e5 9b bd e4 ba ba 就是字符串"中国人"经过 UTF-8 编码后得到的字节序列,即内存表示。

UTF-8 是一种可变长度编码,对于 ASCII 字符使用 1 个字节,对于其他字符使用 2~4 个字节,上面的中文字符使用的就是 3 字节的编码。

这种编码方式具有兼容性好(比如完全兼容 ASCII 字符)、节省空间(对于英文和其他拉丁字母的文本,UTF-8 使用的字节数较少,仅 1 字节)等优点。

正是因为 UTF-8 编码的存在,我们才需要区分遍历字符串的字节和字符。 前面我们已经展示了用 for range 遍历字符串的字符序列,那么如何遍历字符串的字节序列呢?

要遍历字节序列,需要使用到经典的三段式 for 循环:

package main

import (

"fmt"

)

func main() {

s := "中国人"

for i := 0; i < len(s); i++ {

fmt.Printf("%d: %x\n", i, s[i])

}

}

该示例输出结果如下:

0: e4

1: b8

2: ad

3: e5

4: 9b

5: bd

6: e4

7: ba

8: ba

注意,示例中的 len 函数返回的是字符串的字节数量,而不是字符数量。从输出结果也可以看到:"中国人"这个字符串的 UTF-8 编码占用了 9 个字节。

理解了 Go 字符串和字符的表示和编码后,我们再来看一个非常重要的实践环节:字符串与字节切片([]byte)的相互转换。我们将深入探讨这两种类型之间的转换机制,以及 Go 编译器在背后所做的优化工作。

零拷贝优化:字符串与字节切片的转换

在 Go 编程中,我们经常需要在 string 和 []byte 之间进行转换。

- 字符串转字节切片

s := "hello"

b := []byte(s) // 分配新的字节切片,并将"hello"的内容复制到切片中

b[0] = 'H'

fmt.Println(s) // 输出"hello",s不变

- 字节切片转字符串

b := []byte{'h', 'e', 'l', 'l', 'o'}

s := string(b) // 分配新的字符串,并将b的内容复制到字符串中

b[0] = 'H'

fmt.Println(s) // s不变,输出"hello",

上面的字符串和字节切片之间的转换看似简单,但在底层却可能涉及内存分配和数据拷贝。为什么呢?

字符串是不可变的,而字节切片是可变的。这意味着每次将字节切片转换为字符串时,Go 运行时都需要分配一块新的内存来存储字符串数据,并将字节切片的内容复制到新分配的内存中。

反之,将字符串转换为字节切片时,也需要分配新的字节切片内存,并复制字符串的数据。这种频繁的内存分配和数据拷贝会带来以下问题。

- 性能开销:内存分配和数据拷贝是相对耗时的操作,会占用 CPU 周期,降低程序性能。

- 内存占用:频繁的内存分配会导致内存碎片,增加垃圾回收(GC)的压力,甚至可能导致程序内存占用过高。

- GC 压力:大量的临时对象(如新分配的字符串和字节切片)会增加 GC 的负担,导致 GC 暂停时间变长,影响程序的响应速度。

为了解决这些问题,Go 编译器在特定场景下会对字符串和字节切片之间的转换进行优化,避免不必要的数据拷贝。这种优化被称为“零拷贝”(Zero-Copy)。

通过零拷贝,Go 编译器可以减少内存分配、降低 CPU 使用率、减轻 GC 压力,从而提高程序的性能和效率。

那么在哪些情况下,Go 编译器会进行优化,避免数据拷贝,实现零拷贝转换呢?下面我们就来全面地看一下。

零拷贝的核心思想是: 如果编译器能确定转换后的结果不会被修改,或者只是临时使用,那么就可以让转换后的类型直接共享原始类型的底层字节数据,从而避免内存分配和数据拷贝。

接下来,我们来看一下编译器进行零拷贝优化的常见场景。为了验证“零拷贝”的场景,我们先来准备一个测试工具函数,用来检查内存分配情况:

const (

testStringSmall = "hello, world"

testStringLarge = "Go is an open source programming language that makes it easy to build simple, reliable, and efficient software. Go语言是一种开源编程语言,它能让我们能够轻松地构建简单、可靠且高效的软件。"

)

func testAllocs(t *testing.T, name string, f func()) {

t.Helper()

n := testing.AllocsPerRun(100, f)

t.Logf("%-40s %f allocs/op", name, n)

if n > 0 {

t.Logf("⚠️ %s: 有内存分配发生", name)

} else {

t.Logf("✅ %s: 零内存分配", name)

}

}

testAllocs 利用 testing 包的 AllocsPerRun 函数来执行被测函数的内存分配情况, testing.AllocsPerRun(100, f) 这行代码的作用是运行函数 f 100 次,并计算在这些运行过程中发生的内存分配次数。

如果 n > 0,表示在执行函数 f 时发生了内存分配,日志中将输出一个警告信息。如果 n == 0,则说明函数在执行过程中没有发生任何内存分配,日志中将输出成功的信息。

接下来,我们将对 Go 编译器如何对字符串和字节切片互转场景进行零拷贝优化做一个全面的整理与分析。

使用 range 遍历 string 转换为 []byte 的场景

// ch05/zerocopy_test.go

func TestRangeOverConvertedBytes(t *testing.T) {

s := testStringLarge

testAllocs(t, "Range over []byte(string)", func() {

sum := 0

for _, v := range []byte(s) {

sum += int(v)

}

_ = sum

})

}

优化原理:Go 编译器检测到该 []byte 只用于遍历,不会被修改,因此可以直接使用原字符串的底层数据,无需额外分配内存。

使用 []byte 转换为 string 作为 map 键的场景

// ch05/zerocopy_test.go

func TestMapKeyConversion(t *testing.T) {

m := make(map[string]int)

m[testStringLarge] = 42

b := []byte(testStringLarge)

testAllocs(t, "Map lookup with string([]byte) key", func() {

v := m[string(b)]

_ = v

})

}

优化原理:Go 编译器检测到该 string([]byte) 仅用于 map 查找,只需要一个临时字符串,可以直接使用原字节切片的数据,无需复制。

append([]byte, string…) 操作

// ch05/zerocopy_test.go

func TestAppendStringToBytes(t *testing.T) {

dst := make([]byte, 0, 100)

s := testStringSmall

testAllocs(t, "append([]byte, string...)", func() {

result := append(dst[:0], s...)

_ = result

})

}

优化原理:Go 编译器将直接从 string 读取数据追加到 []byte 中,而不需要先将 string 转换为 []byte。

copy([]byte, string) 操作

// ch05/zerocopy_test.go

func TestCopyStringToBytes(t *testing.T) {

s := testStringLarge

dst := make([]byte, len(s))

testAllocs(t, "copy([]byte, string)", func() {

n := copy(dst, s)

_ = n

})

}

优化原理:Go 编译器直接将字符串内容复制到目标 []byte,避免中间临时 []byte 的创建。

字符串比较操作:string([]byte) == string

// ch05/zerocopy_test.go

func TestCompareStringWithBytes(t *testing.T) {

s := testStringLarge

b := []byte(s)

testAllocs(t, "Compare: string([]byte) == string", func() {

equal := string(b) == s

_ = equal

})

testAllocs(t, "Compare: string([]byte) != string", func() {

notEqual := string(b) != s

_ = notEqual

})

b1 := []byte(testStringLarge)

b2 := []byte(testStringLarge)

testAllocs(t, "Compare: string([]byte) == string([]byte)", func() {

equal := string(b1) == string(b2)

_ = equal

})

}

优化原理:Go 编译器检测到该操作只需要比较内容,可以直接比较字节切片和字符串、两个字节切片的内容,无需创建临时字符串。

bytes 包函数的 string 类型参数

// ch05/zerocopy_test.go

func TestBytesPackageWithString(t *testing.T) {

s := testStringSmall

testAllocs(t, "bytes.Contains([]byte, []byte(string))", func() {

c := bytes.Contains([]byte("hello world"), []byte(s))

_ = c

})

}

优化原理:bytes 包是专门用于处理字节切片的,当我们使用 []byte(s) 将字符串转换为字节切片时,编译器可以识别出这种模式,并进行优化。

for 循环遍历 string 转换为 []byte 的场景

// ch05/zerocopy_test.go

func TestForLoopOverConvertedBytes(t *testing.T) {

s := testStringLarge

testAllocs(t, "for loop over []byte(string)", func() {

bs := []byte(s)

sum := 0

for i := 0; i < len(bs); i++ {

sum += int(bs[i])

}

_ = sum

})

}

优化原理:虽然这里有 []byte(s) 的转换,但如果 bs 没有被修改,编译器还是可能直接使用底层数组。

switch 语句中使用 string([]byte)

// ch05/zerocopy_test.go

func TestSwitchWithConvertedBytes(t *testing.T) {

b := []byte(testStringSmall)

testAllocs(t, "switch with string([]byte)", func() {

switch string(b) {

case "hello":

// 不执行

case "world":

// 不执行

default:

// 执行

}

})

}

优化原理:编译器可以优化 switch 语句中的 string(b) 转换,避免创建临时字符串。

我们看到,零拷贝优化的核心是 Go 编译器会尽可能地避免在 string 和 []byte 之间转换时进行数据拷贝,前提是转换后的结果不会被修改,或者转换只是临时性的。

优化的场景主要集中在使用 []byte 转换为 string 的场景,且转换后的 string 不会被修改,或者只是用于读取、比较、map 键等操作。 只要涉及对 []byte 或 string 的修改,就无法进行零拷贝优化。

当然,我们也可以使用 unsafe 包进行强制的零拷贝转换,比如下面示例中的 byteToStringUnsafe 和 stringToByteUnsafe 函数:

// ch05/zerocopy_test.go

func byteSliceToStringUnsafe(b []byte) string {

return *(*string)(unsafe.Pointer(&reflect.StringHeader{

Data: uintptr(unsafe.Pointer(&b[0])),

Len: len(b),

}))

}

func stringToByteSliceUnsafe(s string) []byte {

return *(*[]byte)(unsafe.Pointer(&reflect.SliceHeader{

Data: (*reflect.StringHeader)(unsafe.Pointer(&s)).Data,

Len: len(s),

Cap: len(s),

}))

}

func TestUnsafeConversions(t *testing.T) {

b := []byte(testStringLarge)

s := testStringLarge

testAllocs(t, "Unsafe []byte to string", func() {

s2 := byteSliceToStringUnsafe(b)

_ = s2

})

testAllocs(t, "Unsafe string to []byte", func() {

b2 := stringToByteSliceUnsafe(s)

_ = b2

})

}

但这是不安全的,并且,reflect.StringHeader 和 reflect.SliceHeader 也已经被 Go 设置为废弃。除非你非常清楚自己在做什么,否则不建议使用。

Go 1.21 引入了新 unsafe 函数,它提供了更清晰的 API,来执行之前需要使用 reflect.StringHeader 和 reflect.SliceHeader的操作。这些新函数是:

- unsafe.String(ptr *byte, len int) string —— 从字节指针和长度创建字符串

- unsafe.StringData(s string) *byte —— 获取字符串数据的指针

- unsafe.Slice(ptr *T, len int) []T —— 从指针和长度创建切片

- unsafe.SliceData(slice []T) *T —— 获取切片数据的指针

这些操作可以用来实现零拷贝的转换,比如:

// ch05/zerocopy_test.go

// 使用unsafe.String将字节切片转换为字符串

func byteSliceToStringUnsafeGo121(b []byte) string {

return unsafe.String(unsafe.SliceData(b), len(b))

}

// 使用unsafe.Slice将字符串转换为字节切片

func stringToByteSliceUnsafeGo121(s string) []byte {

return unsafe.Slice(unsafe.StringData(s), len(s))

}

func TestUnsafeConversionsGo121(t *testing.T) {

b := []byte(testStringLarge)

s := testStringLarge

testAllocs(t, "Unsafe []byte to string(Go1.21)", func() {

s2 := byteSliceToStringUnsafeGo121(b)

_ = s2

})

testAllocs(t, "Unsafe string to []byte(Go1.21)", func() {

b2 := stringToByteSliceUnsafeGo121(s)

_ = b2

})

}

这些操作虽然实现了零拷贝,但有严格的安全要求:

- 字符串不可变性:使用 unsafe.Slice(unsafe.StringData(s), len(s)) 将字符串转换为字节切片后,绝对不能修改字节切片的内容,否则会破坏 Go 的字符串不可变性保证,可能导致程序崩溃或不可预期的行为。

- 内存生命周期:使用 unsafe.String(unsafe.SliceData(b), len(b)) 将字节切片转换为字符串时,必须确保原始字节切片在字符串使用期间不被回收或修改。

- 并发安全:这些操作不保证并发安全,在并发环境中使用时需要额外同步措施。

提醒大家要注意的是:编译器的优化策略可能会随着 Go 版本的更新而变化,因此在不同的 Go 版本中,零拷贝优化的具体情况可能会有所不同。

通过上面的全面整理与分析,你应该对 Go 编译器在字符串和字节切片转换时的零拷贝优化有了更深入的理解。在实际编程中,了解这些优化机制可以帮助我们编写出更高效的 Go 代码。

最后,我们再来看看另外一个最常见的字符串操作: 字符串拼接,了解一下哪种拼接方式最为高效。

高效字符串拼接:告别低效的 +

字符串拼接是另一个常见操作。最直接的方式是使用 + 或 += 运算符:

s1 := "hello"

s2 := "world"

s3 := s1 + ", " + s2 // 简单直接

但是,在循环或需要拼接大量字符串片段的场景下,使用 + 会非常低效。为什么呢?

因为字符串是不可变的。每次执行 result = result + fragment,Go 运行时都需要:

- 分配一块新的内存,大小为

len(result) + len(fragment)。 - 将

result的内容拷贝到新内存。 - 将

fragment的内容拷贝到新内存。 - 让

result指向这块新内存。 - 旧

result的内存成为垃圾,等待回收。

如果在一个循环中执行 N 次拼接,就会产生 N-1 个临时的、马上被丢弃的字符串对象,以及大量的内存分配和拷贝操作,性能开销巨大。

推荐方案: strings.Builder。

strings.Builder 类型是专门为高效构建字符串设计的。它内部维护一个可变的字节缓冲区( []byte)。

import "strings"

var fragments = []string{"Go", " ", "is", " ", "fast", "!"}

// 低效方式

var resultPlus string

for _, frag := range fragments {

resultPlus += frag

}

// 高效方式

var builder strings.Builder

// 可选:预估总长度,减少缓冲区扩容

builder.Grow(15) // 估算一个大概长度

for _, frag := range fragments {

builder.WriteString(frag) // 追加到内部缓冲区,可能触发扩容,但比每次都分配新string高效得多

}

resultBuilder := builder.String() // 最后一次性生成最终字符串

fmt.Println(resultPlus)

fmt.Println(resultBuilder)

strings.Builder 的优势:

WriteString方法直接将字符串的字节追加到内部缓冲区,避免创建大量临时字符串。- 内部缓冲区会按需扩容,但扩容策略通常比

+运算符导致的频繁分配更高效。 - 可以通过

Grow方法预先分配缓冲区大小,进一步减少扩容次数。 - 最后调用

String()方法时,它会返回一个指向内部缓冲区字节数据(或其副本,取决于实现细节和优化)的新字符串。

下面我们写一个 benchmark 测试,直观地对比一下 Builder 与 + 操作符的字符串连接速度,benchmark 测试的代码如下:

// ch05/benchmark_test.go

package main

import (

"strings"

"testing"

)

const numStrings = 1000

func BenchmarkPlus(b *testing.B) {

for i := 0; i < b.N; i++ {

s := ""

for j := 0; j < numStrings; j++ {

s += "hello"

}

}

}

func BenchmarkStringBuilder(b *testing.B) {

for i := 0; i < b.N; i++ {

var sb strings.Builder

for j := 0; j < numStrings; j++ {

sb.WriteString("hello")

}

_ = sb.String() // 获取最终字符串,防止编译器优化

}

}

运行该 benchmark 测试,结果如下:

$go test -bench .

goos: darwin

goarch: amd64

pkg: demo

BenchmarkPlus-8 3109 382385 ns/op

BenchmarkStringBuilder-8 280808 4136 ns/op

PASS

ok demo 2.445s

我们看到在这个特定场景下,Builder 的字符串连接性能要远远超过原生的 + 操作符。

那么何时使用 strings.Builder 呢?我建议是在 需要拼接多个(通常 3 个或以上)字符串片段时,尤其是在循环中构建字符串时。 而对于仅拼接两三个短字符串的简单情况,直接使用 + 操作符仍然是可读性最好、也足够快的选择。

小结

这一讲,我们深入探索了 Go 字符串的“二面性”世界,理解了它为何既像字节序列又像字符序列。

- 两面性:字符串是不可变的字节序列,支持按字节索引和切片;同时也是 Unicode 字符序列,可通过 for range 按字符(rune)迭代。

- 底层表示:运行时由

stringStruct(指向字节数据的指针str+ 字节长度len)表示。 rune类型:int32 的别名,用于表示一个 Unicode 码点。- UTF-8 编码:Go 默认使用 UTF-8 存储字符串,是可变长度编码,兼容 ASCII,能表示所有 Unicode 字符。

string与[]byte转换:通常涉及拷贝以保证不可变性。但 Go 编译器在多种只读、临时使用的场景下进行零拷贝优化,直接共享底层数据,提升性能。应优先依赖编译器优化,避免使用unsafe进行强制零拷贝,除非极度必要且能控制风险。- 高效拼接:在拼接多个字符串片段(尤其在循环中)时,应使用

strings.Builder替代+运算符,以避免大量临时对象分配和数据拷贝,显著提高性能。

掌握 Go 字符串的这些核心概念和实践技巧,对于正确处理全球化文本、优化 I/O 操作、提升程序整体性能至关重要。

思考题

我们知道 for range s 可以遍历字符串 s 中的 Unicode 字符 ( rune),而 for i := 0; i < len(s); i++ 遍历的是字节 ( byte)。

请思考:在什么情况下,我们可能需要放弃 for range 的便利性,而选择手动地、按字节 ( for i := 0; ...) 来处理一个字符串?举一个或多个你认为合理的场景。

欢迎在留言区分享你的想法!我是 Tony Bai,我们下节课见。

Map:不仅是键值对,掌握哈希表的高效用法与并发陷阱

你好,我是 Tony Bai。

前面几讲我们“强化”了 Go 中的原生序列类型,如数组、切片和字符串。它们擅长处理有序数据,但如果我们需要快速根据一个“键”找到对应的“值”呢?这时,Go 的另一个内置法宝—— map 就登场了。

map 本质上是哈希表(hash table)的一种实现。它的核心“魅力”在于,无论你的数据集有多大,查找、插入、删除一个键值对的操作,平均时间复杂度都能达到惊人的 O(1),也就是常数时间!这使得 map 成为 Go 中使用频率最高、也最实用的数据结构之一,无论是做缓存、去重,还是建立数据间的关联,都离不开它。

但是,强大的工具往往伴随着复杂性。map 的使用并非“傻瓜式”操作,一不小心就可能掉进各种“陷阱”:

- 并发读写 map 为何会导致程序崩溃?如何安全地在 goroutine 间共享 map?

- 为什么不能直接获取 map 中元素的地址?修改 map 中的结构体字段为何会报错?

nilmap 和空 map 有何区别?误用为何会导致 panic?- 为何不能直接用

==比较两个 map 是否相等? - map 的遍历顺序为何是随机的?

如果你对这些问题还存在疑惑,那么这节课就是为你量身定制的。 不深入理解 map 的特性、约束和常见陷阱,就可能写出有并发风险、性能低下甚至隐藏Bug 的代码。

本节课我们将深入探讨 map 的用法、特性、陷阱和优化技巧,让你能够充分发挥 map 的优势,避免常见的错误。

并且,Go map 的实现依然在优化,Go 1.24 版本中引入了基于 swiss table 的新 map 实现,在本节课末尾,我也会对新 map 的实现做简单介绍,对新旧 map 实现做个简单对比。我们的目标很明确: 让你不仅会用 map,更能用好 map,充分发挥其威力,规避其风险。

map 基础回顾

我们先快速过一遍 map 的基础,确保大家都在同一起跑线上。

创建 Map: make vs 字面量

声明一个 map 变量:

var m map[KeyType]ValueType

KeyType 必须是可比较(comparable)的类型,支持 == 和 !=,如 int、string、指针、 struct(所有字段都可比较)等,但 slice、func、map 本身不行。ValueType 可以是任意类型。

但仅仅这样声明的 map 还不行,因为其值是 nil。 对 nil map 进行写操作会导致 panic! 因此,必须初始化 map 才能使用。下面是两种常用的初始化 map 的方式:

- 使用

make函数

// 创建一个空的 map

m1 := make(map[string]int)

// 创建时预估容量 (后面会讲为何重要)

m2 := make(map[string]int, 100) // 预分配大约100个元素的空间

make 是创建空 map 或需要动态添加元素时的常用选择。

- 使用字面量(Literal)

// 创建并初始化

m3 := map[string]int{

"apple": 1,

"banana": 2,

}

// 创建一个空的 map (等效于 make)